Die Entwicklung von Sprachmodellen hat in den letzten Jahren enorme Fortschritte gemacht und prägt mittlerweile zahlreiche Anwendungen von maschineller Übersetzung über Chatbots bis hin zu automatischer Textgenerierung. Während große Modelle wie GPT-4 beeindruckende Ergebnisse liefern, sind kleinere und effizientere Modelle ebenfalls von großer Bedeutung, vor allem wenn Ressourcen limitiert sind oder Erklärbarkeit wichtig ist. Genau hier setzt SimpleStories an, ein synthetisches Textdatenset, das zum Training winziger Sprachmodelle konzipiert wurde. Dieses Datenset bietet eine bahnbrechende Möglichkeit, Sprachmodelle mit hoher Vielfalt und gleichzeitig überschaubarer Komplexität zu trainieren, was die Forschung und Entwicklung im Bereich der kompakten KI-Systeme voranbringt. SimpleStories entstand aus der Motivation heraus, eine alternative Textgrundlage bereitzustellen, die explizit auf das Training kleiner Sprachmodelle zugeschnitten ist.

Anders als natürliche Textcorpora, die oft riesig und unstrukturiert sind und viele unerwünschte Eigenschaften haben, liefert SimpleStories klar definierte, kurze Geschichten mit annotierten Kategorien. Diese Geschichten sind synthetisch generiert und zeichnen sich dadurch aus, dass sie inhaltlich klar, stilistisch diversifiziert und in verschiedenen komplexitäts- und semantischen Dimensionen untersucht wurden. Damit bietet SimpleStories eine sowohl reichhaltige als auch saubere Basis für Trainingszwecke und Evaluierung. Das Datenset umfasst über zwei Millionen kurze Geschichten, jeweils mit einer Länge, die kleine Modelle gut verarbeiten können. Die Geschichten sind dabei nicht willkürlich, sondern verfügen über umfangreiche Metadaten, die Themen wie Freundschaft, Abenteuer, Verlust, Innovation, Magie und vieles mehr abdecken.

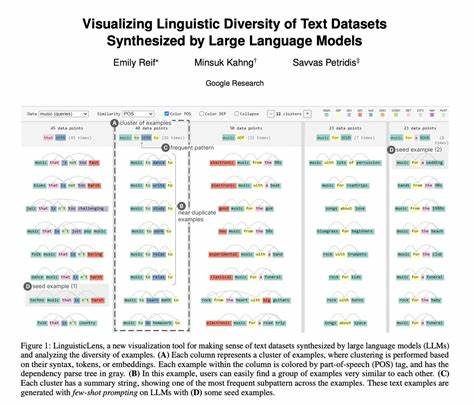

Zusätzlich sind stilistische Merkmale, Lesbarkeitswerte und syntaktische Eigenschaften enthalten, sodass sich auch spezifische Anwendungsfälle und Experimente realisieren lassen. Diese Etikettierung erleichtert das gezielte Training und die kontrollierte Generierung von Texten unterschiedlicher Art. Ein entscheidender Vorteil von SimpleStories liegt in der Transparenz und Offenheit der Erzeugungsmethodik. Die Texte wurden mithilfe moderner, kleiner und interpretierbarer KI-Modelle generiert, die wiederum speziell auf kurze Geschichten fokussiert sind. Dieses rekursive Verfahren erlaubt maximale Kontrollierbarkeit über Inhalt und Stil.

Forschende können so nicht nur Modelle trainieren, sondern auch nachvollziehen, wie die Datengrundlage entstanden ist und diese an spezifische Forschungsfragen anpassen. Diese Offenheit hebt SimpleStories von vielen anderen Datensets ab, die oft wenig Einblick in die Datenherkunft bieten. Die Vielfalt der Geschichten sorgt für eine hohe Generalisierbarkeit der darauf trainierten Modelle. Die erzählten Szenarien variieren von märchenhaft über humorvoll bis hin zu nachdenklich und tragisch, was kleine Modelle besonders für viele NLP-Aufgaben vorbereitet. Dazu zählen Textgenerierung, Lesbarkeitsanalyse, semantische Klassifikation und sogar emotionale Bewertung.

Die synthetische Natur schränkt das Spektrum der Inhalte bewusst ein, um sich vor allem auf gut steuerbare und gut verständliche Sprachmuster zu konzentrieren – ideal, um Modelle zu entwickeln, die nicht nur performen, sondern auch erklärbar bleiben. Technisch ist SimpleStories im Parquet-Format abgelegt, was schnelles Laden in gängigen Datenanalyse- und Machine Learning-Frameworks wie PyTorch, TensorFlow oder Hugging Face Datasets ermöglicht. Damit erleichtert es die Integration in bestehende NLP-Pipelines. Zusätzlich werden verschiedene Versionen des Datensets bereitgestellt, die sich in Größe und Komplexität unterscheiden, von kleineren Sets mit einer Million Geschichten bis hin zu Sets mit über 30 Millionen Zeilen, je nachdem, wie groß das Modell sein soll und wie viel Rechenressourcen zur Verfügung stehen. Die Trainingsmodelle, die auf SimpleStories basieren, beweisen, dass kleine, fokussierte Datensätze herausragende Resultate erzielen können, ohne dass extrem große und teure Datensammlungen notwendig sind.

Kleine Sprachmodelle haben den Vorteil, zugänglicher zu sein, schnelleres Training zu ermöglichen und Einsatzszenarien zu erfüllen, bei denen Effizienz und geringe Latenz entscheidend sind – beispielsweise in mobilen Anwendungen oder eingebetteten Systemen. Die Kombination aus hochwertigen Story-Generierungen, detaillierten Annotationen und offener Methodik macht SimpleStories zu einer wertvollen Ressource für Entwickler, Forschende und Unternehmen, die leichte und interpretierbare KI-Modelle entwerfen möchten. Das Projekt ist inspiriert vom TinyStories-Ansatz, erweitert diesen aber durch eine größere Vielfalt und tiefere Analyse der Geschichten, was mehr Flexibilität für experimentelle Ansätze bietet. Einen weiteren Pluspunkt stellt die Mehrsprachigkeit dar. Während die Hauptherkunft des Datensatzes Englisch ist, wird aktuell an Versionen in Japanisch und anderen Sprachen gearbeitet.

Dies eröffnet Potenziale für die Erforschung sprachspezifischer Eigenheiten im kleinen Modellsegment und ermöglicht die Anpassung an Märkte und Nutzergruppen weltweit. Durch die Veröffentlichung auf bekannten Plattformen wie Hugging Face bleibt SimpleStories für die Community leicht zugänglich. Dort stehen neben den Rohdaten auch vortrainierte Modelle bereit, die mit den Geschichten trainiert wurden. Damit können Entwickler direkt mit Inferenz und Feinjustierungen beginnen, ohne aufwändige Vorarbeit leisten zu müssen. Zusammenfassend bringt SimpleStories frischen Schwung in die Welt der synthetischen Datensets für NLP und bietet eine praktikable Alternative zu massiven, unübersichtlichen Textsammlungen.

Seine Fokusierung auf kurze, inhaltlich klare Geschichten mit umfangreichen Metadaten unterstützt das Training von kleinen, sparsamen und transparenten Sprachmodellen, die in vielen realen Anwendungsfällen eine bedeutende Rolle spielen können. Als Werkzeug für die Forschung, Prototypenentwicklung und sogar für produktive Lösungen stellt SimpleStories damit einen wichtigen Meilenstein dar. Für die Zukunft sind Erweiterungen des Datensatzes geplant, die weitere Sprachen, Story-Genres und komplexere narrative Strukturen enthalten sollen. Auch die Integration von interaktiven Elementen wie Frage-Antwort-Paaren oder Mehrfachpfaden ist denkbar. Dies alles würde die Anwendungsbreite weiter erhöhen und die kleine Modelllandschaft um leistungsfähige, vielseitige Werkzeuge bereichern.

SimpleStories zeigt deutlich, dass synthetisch generierte und wohlstrukturierte Textdatensets den Weg für kleine und effiziente Sprachmodelle ebnen können. Gerade im Zeitalter der KI, in dem Nachhaltigkeit, Erklärbarkeit und Zugänglichkeit immer wichtiger werden, ist dies eine zukunftsweisende Entwicklung. Ob Forschung, Lehre oder Industrie – die Möglichkeiten für neue Innovationen und Anwendungen mit SimpleStories sind vielfältig und vielversprechend.