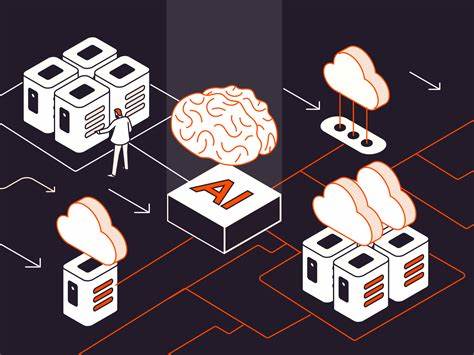

Große Sprachmodelle (Large Language Models, kurz LLMs) haben in den letzten Jahren eine beeindruckende Entwicklung durchlaufen. Von der Textgenerierung über die Beantwortung komplexer Fragen bis hin zu kreativen Anwendungen revolutionieren sie immer mehr Bereiche unseres Lebens und Arbeitens. Doch der Schlüssel zum Erfolg liegt oft nicht nur in der verwendeten Technologie selbst, sondern auch in den Eingabeaufforderungen – den sogenannten Prompts. Diese bestimmen maßgeblich die Qualität, Genauigkeit und Relevanz der Antworten. Viele User stellen sich daher die Frage, wie man die besten, individuell angepassten Prompts gestaltet, um das volle Potenzial eines LLM auszuschöpfen.

Ein besonders hilfreicher Ansatz stammt aus der Idee, das LLM als „Super-Tutor“ einzusetzen, der komplexe Themen auf eine klare und verständliche Weise vermittelt. Inspiriert von der berühmten Unterrichtsmethode des Physikers Richard Feynman, konzentriert sich dieser Stil darauf, schwierige Zusammenhänge einfach zu erklären, Analogien zu nutzen und das Wissen schrittweise aufzubauen. Diese Herangehensweise hat sich als äußerst effektiv erwiesen, um technische Inhalte zugänglich zu machen, ohne dabei die notwendige Tiefe zu verlieren. Kern dieser Methode ist eine umfassende, technische Einführung in ein Thema mit verständlichen Vergleichen aus dem Alltag. Anschließend wird der Kenntnisstand des Nutzers zu den erforderlichen Vorkenntnissen erfragt.

Daraus resultierend wird gezielt auf Verständnislücken eingegangen und relevante Grundlagen erklärt. Dieser rekursive Prozess hilft, das Wissen schrittweise zu erweitern, während die Komplexität langsam ansteigt. Schwierige, spezifische Fragen dienen dabei als Test, um den Lernfortschritt zu überprüfen. Eine weitere wichtige Komponente besteht darin, nicht vor komplexen technischen oder mathematischen Details zurückzuschrecken. Stattdessen wird großer Wert darauf gelegt, diese Komponenten zugänglich und nachvollziehbar zu gestalten.

Durch den gezielten Einsatz von Analogien wird die Abstraktion oft greifbarer und verständlicher – ganz gleich, ob es um Quantenphysik, Programmierkonzepte oder Wirtschaftsmodelle geht. Nutzer profitieren besonders dann, wenn die Antworten des LLM wirklich an ihrem Wissensstand ausgerichtet sind. Deshalb ist es sinnvoll, Prompts dynamisch zu gestalten, sodass das Modell proaktiv nach dem Kenntnisstand fragt und den Dialog entsprechend anpasst. Diese dialogische Vorgehensweise im Prompt-Design führt nicht nur zu besseren Lernerfolgen, sondern auch dazu, dass die Antworten auf die jeweiligen Bedürfnisse besser zugeschnitten sind. Ein weiterer praktischer Tipp bei der Erstellung eigener Prompt-Varianten ist das Experimentieren mit verschiedenen Rollen und Tonalitäten im Prompt selbst.

So kann man beispielsweise das LLM anweisen, als „wissenschaftlicher Experte“, „kreativer Autor“ oder „tech-affiner Coach“ zu agieren. Diese Rollen beeinflussen häufig Stil, Wortwahl und Tiefe der Antworten und können dadurch einen großen Unterschied in der Nutzererfahrung machen. Je nach Anwendungsfall wird so der optimale Antworttyp hervorgehoben. Darüber hinaus sind ausführliche und präzise Anweisungen wichtig, um Missverständnisse zu vermeiden und die gewünschten Ergebnisse zu gewährleisten. Ein gut formulierter Prompt sollte klar und unmissverständlich sein, gleichzeitig aber auch genügend Freiraum für die kreative und inhaltliche Entfaltung des Modells bieten.

Beispielsweise kann die Aufforderung, in jeder Antwort Analogien zu verwenden und komplexe Sachverhalte nicht zu umgehen, die Qualität deutlich steigern. Neben der reinen Textgestaltung lohnt es sich auch, multimodale Elemente zu nutzen, soweit verfügbar. Einige fortgeschrittene LLMs unterstützen mittlerweile die Generierung von Illustrationen oder Code-Snippets, was besonders bei erklärungsintensiven Themen hilfreich sein kann. Der Prompt kann das Modell beispielsweise auffordern, Skizzen zu simulieren oder Beispiele in Form von Tabellen oder Diagrammen bereitzustellen. Eine weitere bewährte Strategie besteht darin, das LLM zu bitten, eigene Verständnisfragen zu formulieren und damit ein interaktives Lernformat zu schaffen.

Diese Technik fördert die aktive Auseinandersetzung mit dem Material und macht das Lernen dynamischer und nachhaltiger. Insbesondere im technischen oder akademischen Kontext beeinflusst dies die Qualität und Tiefe der erworbenen Erkenntnisse positiv. Im Alltag zeigt sich, dass sehr generische Prompts zwar funktionieren, jedoch häufig weniger zielführend sind als sorgfältig durchdachte, auf den individuellen Anwendungsfall zugeschnittene Varianten. Beispielsweise wird ein Prompt für die Erarbeitung einer komplexen Programmiersprache anders formuliert als einer, der kreative Schreibprojekte unterstützt oder Geschäftsmodelle analysiert. Die Personalisierung der Eingabeaufforderung wird somit zum Erfolgsfaktor.

Auch die kontinuierliche Anpassung und Verfeinerung der Prompts im Verlauf eines längeren Dialogs ist sinnvoll. Indem man beispielsweise Rückmeldungen des Modells evaluiert und die Anforderungen an Klarheit oder Umfang spezifiziert, kann man die Qualität der Antworten im Laufe der Zeit optimieren. Dies ist vergleichbar mit der Feinjustierung eines Instruments, um bestmögliche Ergebnisse zu gewährleisten. Das Teilen und Sammeln von effektiven Prompt-Beispielen innerhalb der Community, wie auf Plattformen wie Hacker News, ist ein wertvolles Mittel, um voneinander zu lernen und die eigenen Fähigkeiten im Umgang mit LLMs zu verbessern. Der Austausch von „Best Practices“ und kreativen Lösungsansätzen stärkt langfristig den Umgang mit dieser anspruchsvollen Technologie.

Abschließend lässt sich festhalten, dass die Kunst des Prompt-Engineerings eine Schlüsselkompetenz im Zeitalter der KI ist. Die sorgfältige Gestaltung benutzerdefinierter Prompts ermöglicht es, LLMs nicht nur als reine Antwortmaschinen einzusetzen, sondern als intelligente Partner in Bildung, Forschung und Kreativität. Dabei gilt: Je präziser, klarer und nutzerzentrierter die Eingabe, desto besser das Ergebnis. Durch Methoden wie die Feynman-inspirierte Unterrichtsrolle oder das Einbinden von rekursiven Lernschleifen gestaltet sich der Dialog mit großen Sprachmodellen interaktiv, individuell und höchst effektiv.

![Chevrolet Silverado for long-distance towing [video]](/images/D2D5AAB8-1F1F-40AC-BC9D-29DC96DCEFF8)