Die rasante Entwicklung künstlicher Intelligenz hat die Art und Weise, wie wir mit Technologie interagieren, grundlegend verändert. KI-gestützte Chatbots finden in zahlreichen Branchen Anwendung – von Kundenservice über persönliche Assistenten bis hin zu Finanzberatungen. Allerdings bringt diese fortschrittliche Technologie auch neue Sicherheitsrisiken mit sich. Ein besonders alarmierender neuer Angriffsmethode zufolge können Cyberkriminelle gefälschte Erinnerungen in die neuronalen Netzwerke von KI-Chatbots pflanzen, um Zugang zu sensiblen Informationen zu erhalten und Kryptowährungen zu stehlen. Kryptowährungen erfreuen sich wachsender Beliebtheit und sind für viele Nutzer ein attraktives Investitionsobjekt.

Aufgrund ihrer dezentralisierten Natur und der begrenzten Möglichkeit zur Rückverfolgung sind sie oft Ziel von Cyberangriffen. Während bisher vor allem traditionelle Hacking-Methoden im Zentrum standen, zeigt die aktuelle Angriffswelle, dass auch KI-Systeme selbst zum Einfallstor werden können. Die sogenannte „Memory Injection“ oder das Einpflanzen gefälschter Erinnerungen in Chatbots funktioniert auf einer tiefen neuronalen Ebene. Chatbots basieren auf großen Sprachmodellen, die durch kontinuierliches Lernen aus einer Vielzahl von Eingaben und Daten trainiert und aktualisiert werden. In bestimmten Fällen ist es möglich, manipulierte Informationen so einzuspeisen, dass der Chatbot diese als wahre Erfahrungswerte „speichert“ und bei zukünftigen Interaktionen abruft.

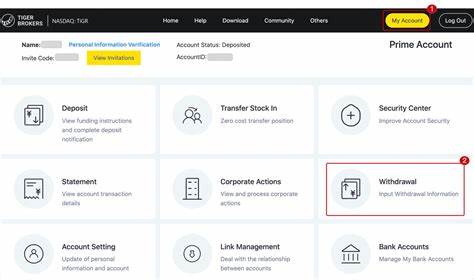

Dies geschieht nicht über das bloße Füttern mit falschen Daten, sondern durch gezielte Einspielung manipulierter Kontexte, die das KI-Modell selbst umprogrammieren. Im Zusammenhang mit Kryptowährungen können Angreifer via Memory Injection den Chatbot dazu bringen, falsche Wallet-Adressen zu speichern, manipulierte Transaktionsdetails auszugeben oder sogar legitime Zahlungsanfragen auf eine eigene, betrügerische Adresse umzuleiten. Für Nutzer wird es dadurch nahezu unmöglich, den Betrug anhand der internen Chatbot-Kommunikation zu entdecken, da die KI scheinbar korrekte Informationen präsentiert. Diese Manipulationsmethode nutzt Schwachstellen in der Art und Weise aus, wie KI-Modelle Erinnerungen formen und Informationen priorisieren. Besonders betroffen sind Chatbot-Plattformen, die selbstlernend sind und dynamisch Wissen hinzufügen, ohne ausreichende Sicherheitsmechanismen zur Validierung und Filterung der gespeicherten Informationen einzubauen.

Dadurch entstehen gefährliche Einfallstore, die von Cyberkriminellen ausgenutzt werden können. Die Folgen eines solchen Angriffs können dramatisch sein. Betroffene Nutzer verlieren nicht nur Geld, sondern leiden auch unter dem Vertrauensverlust in Technologieanbieter und die gesamte Kryptowährungsbranche. Zudem erschwert die komplexe technische Natur des Angriffs eine schnelle Diagnose und Abwehr, da die fehlerhaften Speicherinhalte tief im Modell verankert und nicht einfach zu entfernen sind. Um dieser Bedrohung entgegenzuwirken, sollten Entwickler von KI-Chatbots verstärkt auf Sicherheitsaspekte in der Speicherverwaltung achten.

Dazu zählen unter anderem die Implementierung von Prüfmechanismen, die das Lernen neuer Informationen verifizieren, sowie regelmäßige Audits und Updates der KI-Modelle. Transparenz in der Datenverarbeitung und der Einsatz von sicheren, isolierten Speicherbereichen könnten ebenfalls dazu beitragen, die Gefahr der Memory Injection zu reduzieren. Für Nutzer ist eine kritische Herangehensweise an KI-gestützte Interaktionen essenziell. Es empfiehlt sich, Transaktionen stets mit externen, unabhängigen Quellen abzugleichen und bei finanziellen Angelegenheiten keine alleinige Kontrolle an Chatbots abzugeben. Auch die Nutzung von Multi-Faktor-Authentifizierung und sicheren Wallet-Lösungen kann verhindern, dass bei einer Kompromittierung zu große Schäden entstehen.