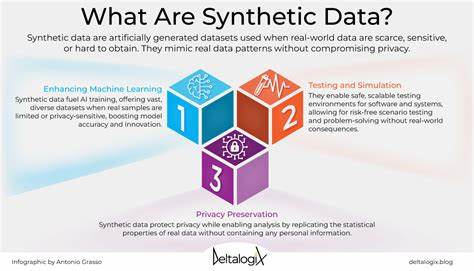

Reinforcement Learning (RL) hat sich in den letzten Jahren als eine der fortschrittlichsten Methoden etabliert, um leistungsfähige KI-Modelle für spezialisierte Aufgaben zu entwickeln. Insbesondere bei großen Sprach- und Foundation-Modellen ermöglicht RL eine gezielte Anpassung an spezifische Anforderungen und Zielsetzungen. Doch die konventionelle Nutzung von RL ist stark auf umfangreiche, menschlich annotierte Datensätze angewiesen, was den Einsatz und die Skalierbarkeit drastisch einschränkt. Vor allem die Kosten und der Zeitaufwand, die mit der manuellen Datenbeschriftung verbunden sind, stellen häufig eine große Hürde dar. Hier kommt Synthetic Data RL ins Spiel – ein innovativer neuer Ansatz, der diese Probleme elegant umgeht und das Reinforcement Learning nachhaltig transformiert.

Synthetic Data RL baut auf der faszinierenden Idee auf, dass man für die Feinabstimmung von Modellen weder umfangreiche reale Datensätze noch langwierige menschliche Annotationen benötigt. Stattdessen werden synthetische Daten aus den vorhandenen Aufgabenbeschreibungen generiert. Dies geschieht durch einen automatisierten Prozess, der zunächst Fragen und Antworten aus der Aufgabenstellung sowie optional aus zugehörigen Dokumenten ableitet. Dabei wird die Schwierigkeit der generierten Fragen dynamisch an die Leistungsfähigkeit des Modells angepasst. Das bedeutet, dass die künstlich erzeugten Daten so gestaltet sind, dass sie weder zu trivial noch zu schwer für das Modell sind, sondern genau auf das aktuelle Leistungsniveau zugeschnitten bleiben.

Dieser Prozess optimiert das Lernen und verhindert Über- oder Unterforderung des Systems.Ein weiterer entscheidender Vorteil dieses Ansatzes ist die Auswahl der Trainingsfragen anhand der durchschnittlichen Erfolgsquote des Modells, wodurch während des RL-Trainings stets solche Aufgaben priorisiert werden, die den größten Nutzen für die Modellverbesserung versprechen. Durch diesen intelligenten Mechanismus kann die Lernkurve deutlich beschleunigt werden, ohne dabei auf teure menschliche Eingriffe bei der Datenaufbereitung angewiesen zu sein.Die Ergebnisse, welche mit Synthetic Data RL erzielt wurden, sind beeindruckend und unterstreichen das enorme Potenzial der Methode. So wurde beispielsweise das Modell Qwen-2.

5-7B mit dieser Technik trainiert und erreichte auf verschiedenen anspruchsvollen Benchmarks signifikante Leistungssteigerungen. Am Beispiel des GSM8K-Datensatzes, der komplexe mathematische Aufgaben beinhaltet, konnte eine Verbesserung von über 29 Prozentpunkten gegenüber dem Basismodell erzielt werden. Diese Steigerung übertrifft deutlich auch den Gewinn durch traditionelle Methoden wie Instruction-Tuning oder Self-Instruct, welche ebenfalls auf menschlich erzeugte Anweisungen und Daten setzen.Besonders bemerkenswert ist, dass Synthetic Data RL unter dem gleichen Dateneinsatz eine bessere Leistung als herkömmliches Fine-Tuning mit menschlichen Daten erreicht. Dies zeigt, dass die Qualität und gezielte Anpassung der Trainingsdaten im RL-Prozess häufig wichtiger sind als das schiere Volumen an annotierten Beispielen.

Ferner wurde demonstriert, dass selbst die Hinzunahme kleiner Mengen an echten menschlichen Demonstrationen einen nur marginalen Effekt in der Leistungssteigerung bringt, was die Effizienz des rein synthetischen Ansatzes zusätzlich bestätigt.Die Anwendungsmöglichkeiten von Synthetic Data RL sind breit gefächert. In Bereichen wie Medizin (z.B. MedQA), Recht (CQA für juristische Fragen) oder Finanzen (CFA) konnten signifikante Verbesserungen bei der Modellleistung dokumentiert werden.

Diese Vielseitigkeit unterstreicht die generalisierbare Natur des Konzepts, das theoretisch auf nahezu jedes Aufgabenfeld anwendbar ist, in dem klare Aufgaben- oder Fragestellungen vorliegen.Neben den offensichtlichen Vorteilen hinsichtlich der Datenverfügbarkeit und der Kostenersparnis eröffnet Synthetic Data RL auch neue Perspektiven für die Entwicklung von personalisierten oder stark spezialisierten KI-Systemen. Gerade Unternehmen oder Forschungseinrichtungen, die über keine Ressourcen für breit angelegte Datenannotation verfügen, können so auf einfache Weise leistungsfähige Modelle trainieren und einsetzen.Natürlich bringt die Arbeit mit synthetischen Daten auch Herausforderungen mit sich. Die Qualität und Repräsentativität der generierten Fragen und Antworten spielen eine zentrale Rolle für den Erfolg des Verfahrens.

Auch die Feinabstimmung der automatisierten Schwierigkeitseinschätzung sowie die Optimierung der Auswahlmechanismen für die Trainingsdaten sind wesentliche Forschungsgebiete mit großem Entwicklungspotential. Dennoch zeigen die ersten praktischen Anwendungen, dass Synthetic Data RL eine realistische und zukunftsträchtige Alternative zu traditionellen RL-Ansätzen darstellt.Mit Blick auf die Zukunft dürfte sich dieser Ansatz weiter etablieren und in Kombination mit verbesserten Methoden zur automatischen Datengenerierung und Modellbewertung neue Maßstäbe in der KI-Modellanpassung setzen. Die Integration von synthetischen Daten in den RL-Prozess ermöglicht eine nachhaltige und skalierbare Entwicklung, die unabhängig von externen Datensätzen und menschlichen Annotationen arbeitet.Abschließend lässt sich sagen, dass Synthetic Data RL das Versprechen birgt, das Training und die Feinabstimmung von KI-Modellen grundlegend zu verändern.

Durch die clevere Nutzung von Aufgabenbeschreibungen als einzige Datenquelle entfällt der bisher kritische Engpass der Datenbeschaffung. Dies ebnet den Weg für eine breitere, kosteneffizientere und flexiblere Anwendung von Reinforcement Learning in verschiedensten Bereichen der künstlichen Intelligenz. Wer heute auf der Suche nach innovativen Methoden für die Modellanpassung ist, sollte Synthetic Data RL definitiv im Blick behalten.