Die Programmierung zählt zu den komplexesten und spezialisierteren Tätigkeiten innerhalb der digitalen Welt. Für die Herstellung präziser und funktionaler Software müssen Entwickler nicht nur tiefgehendes technisches Wissen besitzen, sondern auch erhebliche Erfahrung im Umgang mit unterschiedlichen Programmiersprachen, Logik und Algorithmen vorweisen. In diesem Kontext wächst das Interesse an Künstlicher Intelligenz (KI), die den Prozess der Programmgenerierung automatisieren und somit die Produktivität von Entwicklern deutlich steigern kann. Ein zentrales Forschungsfeld hierbei ist die Programmsynthese – die automatische Erzeugung von Software basierend auf vorgegebenen Spezifikationen oder Beispielen. Die zunehmende Bedeutung hybrider KI-Ansätze, die symbolische mit neuronalen Methoden verbinden, eröffnet dabei neue, vielversprechende Wege für das automatisierte Programmieren.

Symbolische KI und neuronale Netzwerke stellen zwei fundamental unterschiedliche Paradigmen dar. Die symbolische KI nutzt explizite Regelwerke, Logik und deduktive Methoden, um Programme zu erzeugen, und hat den Vorteil einer präzisen, nachvollziehbaren und interpretierbaren Arbeitsweise. Neuronale Netzwerke, insbesondere große Sprachmodelle (Large Language Models, LLMs), setzen auf statistische Mustererkennung und Approximation, was ihnen erlaubt, aus riesigen Datenmengen zu lernen und kreative Lösungen zu erarbeiten, allerdings teilweise mit einer gewissen Unsicherheit und mangelnder Konsistenz. Hybrid-KI versucht, das Beste aus beiden Welten zu kombinieren: die Genauigkeit und Verlässlichkeit symbolischer Ansätze mit der Flexibilität und Lernfähigkeit neuronaler Modelle. Die Herausforderung bei der Programmsynthese liegt darin, ein gegebenes Input – sei es in Form von formalen Spezifikationen, Beispielen oder Beschreibungen in natürlicher Sprache – in exakt funktionierenden Code umzuwandeln.

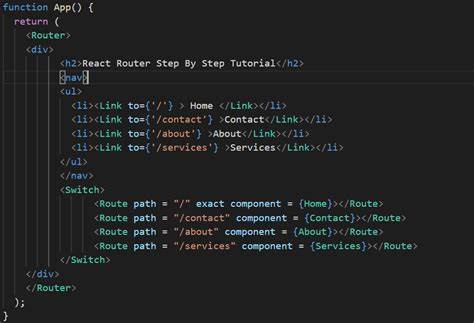

Formale Spezifikationen bestehen oft aus logischen Formulierungen oder Testfällen, die das gewünschte Verhalten eines Programms eindeutig beschreiben. Hier werden häufig domänenspezifische Sprachen (Domain Specific Languages, DSL) eingesetzt, die den Suchraum der möglichen Programme eindämmen und es so ermöglichen, effizientere Algorithmen zu verwenden. Im Gegensatz dazu basiert das Programmieren anhand von Beispielen (Programming by Example, PBE) auf einer Reihe von Ein- und Ausgabepaaren, mit deren Hilfe ein Modell den zugrundeliegenden Zusammenhang lernen soll, um daraus ein Programm zu generieren, das auch unbekannte Eingaben korrekt verarbeitet. Die Arbeit mit natürlicher Sprache als Spezifikation stellt eine besondere Schwierigkeit dar, da Sprache intrinsisch unscharf, mehrdeutig und kontextabhängig ist, während Code streng formal und deterministisch sein muss. Hier haben große Sprachmodelle durch ihre Fähigkeit, semantische Nuancen zu erfassen und komplexe Zusammenhänge zu interpretieren, bemerkenswerte Fortschritte ermöglicht.

Dennoch ist die Umwandlung von Textbeschreibungen in fehlerfreien Programmcode eine anspruchsvolle Aufgabe, die oft erst durch die Kombination mit symbolischer Überprüfung und Suchstrategien bewältigt werden kann. Die rein symbolische Programmsynthese verwendet systematische Suchverfahren, wie die sogenannten enumerativen Algorithmen, die alle möglichen Programme innerhalb eines Suchraums durchgehen und anhand von formalen Bedingungen verifizieren. Dieses Verfahren ist aber oft sehr rechenintensiv und kann bei komplexeren Aufgaben schnell unpraktikabel werden. Rein neuronale Methoden hingegen versuchen, die Aufgabe direkt als Mustererkennungsproblem zu formulieren, indem sie beispielsweise Eingaben und Ausgaben über neuronale Netzwerke abbilden. Diese Methoden profitieren von der universellen Approximationseigenschaft neuronaler Netze, besitzen jedoch typischerweise Schwierigkeiten, die nötige Präzision sicherzustellen, was zu inkonsistenten oder fehlerhaften Programmen führen kann.

Hybridmethoden kombinieren die Stärken der beiden Ansätze, indem sie neuronale Modelle als Heuristiken oder Vorschlagsgeneratoren einsetzen, während symbolische Suchverfahren die endgültige Verifikation und Zusammensetzung übernehmen. So kann das neuronale Modell effizient vielversprechende Programmteile identifizieren, die dann anhand der formalen Regeln gründlich geprüft und zusammengesetzt werden. Die resultierenden Verfahren werden unter dem Begriff neuro-symbolische KI oder kurz NeSy zusammengefasst und dienen als Brücke zwischen schnellem, intuitivem Lernen und rigoroser, logikbasierter Verifikation. Zentrale Techniken in diesem Bereich umfassen sowohl Top-Down- als auch Bottom-Up-Enumerationsstrategien. Top-Down-Verfahren bearbeiten das Problem hierarchisch von der Gesamtstruktur hinunter zu den Unterkomponenten, was gut mit den Fähigkeiten von LLMs harmoniert, die den Kontext weit erfassen können.

Bottom-Up-Strategien bauen Programme aus kleinen Bausteinen zusammen und überprüfen diese Stück für Stück, was Ähnlichkeiten zur Entwurfsweise menschlicher Entwickler aufweist. Beide Ansätze profitieren von probabilistischen Modellen und heuristischen Richtlinien, die auf linguistischen Kontexten, wahrscheinlichen Programmmustern und bisherigen Erfahrungen basieren. Eine wichtige Rolle spielen probabilistische kontextfreie Grammatiken (pCFG). In solchen Grammatiken sind die Regeln der Sprache mit Wahrscheinlichkeiten versehen, die das Suchverfahren steuern und die Auswahl wahrscheinlicher Programmstrukturen begünstigen. Die Wahrscheinlichkeiten können aus Trainingsdaten oder auch aus den Vorschlägen eines neuronalen Modells abgeleitet werden.

Dadurch wird die Suche nach sinnvollen Programmen erheblich effizienter. Methoden wie DeepCoder nutzen Attributvektoren, um Wahrscheinlichkeiten bestimmter Programmfeatures festzulegen, während Modelle wie CrossBeam die Kombination von Programmteilen basierend auf Bewertungen ihrer Zwischenergebnisse priorisieren. Ein weiterer Innovationsschub resultiert aus der verstärkten Einbindung großer Sprachmodelle in den Syntheseprozess. LLMs übertreffen frühere neuronale Architekturen in Aspekten wie der langfristigen Kontextverarbeitung und haben den Vorteil, ein breites Wissensspektrum abzudecken, das weit über die unmittelbare Spezifikationsaufgabe hinausgeht. Dennoch sind LLMs auch anfällig für Inkonsistenzen – sie liefern unterschiedliche Lösungen bei leicht veränderten Eingaben oder Prompts.

Dies erschwert eine zuverlässige Automatisierung rein durch neuronale Methoden. Hybridverfahren wie iLLM-synth adressieren diese Herausforderungen, indem sie LLMs parallel zu etablierten Suchalgorithmen einsetzen. Beispielsweise generieren LLMs Hilfsfunktionen oder Syntaxvorschläge, die in eine dynamisch angepasste pCFG eingebettet werden. Anschließend steuert ein symbolischer Suchalgorithmus, etwa basierend auf A*, die effiziente Exploration des Programmraums. So profitiert das System von der breiten, natürlichen Sprachkompetenz der LLMs und der rigorosen Genauigkeit der symbolischen Verfahren.

Weitere Ansätze wie Neural Guided Deductive Search (NGDS) arbeiten durch Selektion vielversprechender Programmzweige basierend auf Input-Ausgabe-Beispielen, während HySynth LLM-basierte Kandidaten nutzt, um gezielt Bottom-Up-Suchen durchzuführen. Auch Alpha Geometry zeigt, wie eine Kombination aus neuronalen Netzwerken und formalen Beweisverfahren komplexe geometrische Aufgaben automatisch lösen kann, ein Beispiel für die vielfältigen Anwendungsdomänen hybrider Programmsynthese. Zusammenfassend lässt sich festhalten, dass hybride KI-Methoden für die Programmgenerierung eine wichtige Rolle spielen, um die Stärken von neuronalen Netzwerken und symbolischer Logik zu vereinen. Während rein neuronale Ansätze vor allem bei einfachen Problemen oder dank großer Trainingsmengen punkten, bieten Hybridsysteme eine robustere Lösung, die Präzision, Effizienz und Flexibilität verbindet. Die Einbindung von LLMs verleiht den Systemen zusätzliche kognitive Fähigkeiten, jedoch bleibt es essentiell, diese durch bewährte Such- und Verifikationsverfahren abzusichern.

Der Trend geht klar dahin, dass zukünftige Programmsynthesesysteme zunehmend auf hybride Architekturen setzen werden, um die wachsenden Anforderungen an Komplexität, Verlässlichkeit und Vielseitigkeit zu erfüllen. Dabei eröffnen neue Forschungsansätze Potenziale, durch adaptive Grammatikmodelle, lernbasierte Heuristiken und verbesserte Kontextmodellierung noch effizientere und leistungsfähigere Systeme zu entwickeln. Die kontinuierliche Integration neuronaler Fischgräten mit symbolischen Suchstrategien markiert somit einen bedeutenden Fortschritt in der Automatisierung der Softwareentwicklung und ebnet den Weg für neuartige Anwendungen in der Informatik und darüber hinaus.