Die Suche nach mechanistischer Interpretierbarkeit in der Künstlichen Intelligenz (KI) war lange Zeit ein dominierender Forschungszweig, der darauf abzielte, die inneren Abläufe von KI-Modellen vollständig zu verstehen. Mechanistische Interpretierbarkeit bedeutet im Kern, die einzelnen Neuronen und Verbindungen innerhalb eines Modells zu analysieren, um Rückschlüsse auf dessen Entscheidungen und Verhalten ziehen zu können. Doch trotz intensiver Bemühungen und beachtlicher Investitionen hat sich diese Herangehensweise als problematisch erwiesen – oft lässt sie Schlüsse zu kurz kommen oder ist schlicht nicht praktikabel. Dieser Artikel beleuchtet die Gründe, warum die mechanistische Interpretation von KI-Systemen eine Fehlannahme sein kann und warum alternative Herangehensweisen dringend erforderlich sind.Der Ursprung des mechanistischen Denkens in der KI liegt in einem reduktionistischen Weltbild, das davon ausgeht, dass komplexe Systeme durch ihre Grundbausteine vollständig erklärt werden können.

Diese Vorstellung ist tief in der Wissenschaft verwurzelt und führte in der Physik, Chemie oder auch im Maschinenbau zu großen Erfolgen. Doch KI-Modelle, besonders jene, die auf neuronalen Netzwerken basieren, sind keine einfachen Maschinen mit klar zuzuordnenden Einzelteilen. Sie sind vielmehr komplexe Systeme mit einer enormen Anzahl an Verbindungen, die auf nichtlinearen Wechselwirkungen beruhen. Die Eigenschaften und Entscheidungen solcher Systeme sind emergent – das bedeutet, sie entstehen auf einer höheren Ebene und können nicht einfach auf das Verhalten einzelner Komponenten zurückgeführt werden.Beispielsweise versucht die Wissenschaft in der Meteorologie nicht, jede einzelne Molekülbewegung zu verfolgen, sondern arbeitet mit statistischen Modellen und größeren Wetterphänomenen, um Vorhersagen zu treffen.

Ähnlich verhält es sich in der Biologie und Psychologie – das Verhalten von Organismen oder Menschen lässt sich nicht allein durch die Betrachtung einzelner Zellen oder Neuronen erklären. Die menschliche Entscheidungsfindung selbst ist oft intuitiv und von Faktoren beeinflusst, die schwer zu artikulieren sind. Der bekannte Begriff der Polanyi'schen Paradox beschreibt dies treffend: „Wir wissen mehr, als wir sagen können.“ Auch wenn sich eine KI dazu programmieren lässt, Entscheidungen zu treffen, ist die genaue Nachverfolgung ihres inneren Prozesses im gleichen Maße scheiternd wie bei menschlichen Gedanken.Diese komplexe Natur von KI-Modellen führt dazu, dass mechanistische Interpretierbarkeit zwar theoretisch nachvollziehbar ist, in der Praxis jedoch an ihre Grenzen stößt.

KI-Systeme mit Milliarden von Parametern und Terabyte an Gewichtungsdaten können nicht mehr in handhabbaren Einzelschritten erklärt werden. Der Aufwand, alle neuronalen Interaktionen detailliert zu beschreiben, ist schlicht zu hoch, und selbst wenn er durchgeführt werden könnte, wäre das Ergebnis für Menschen wahrscheinlich unverständlich. Denn im Kern erfordert ein effektives Verständnis eine Verdichtung – eine einfache Erklärung oder ein Kernprinzip, das auf überschaubarem Raum erklärt werden kann. Aber genau darin liegt das Dilemma: Wenn ein komplexes Modell auf eine solch einfache Formel reduziert werden kann, dann wäre es vermutlich unnötig, so komplex zu sein.Die Forschung der vergangenen Jahre lieferte immer wieder Beispiele für die Probleme mechanistischer Interpretierbarkeit.

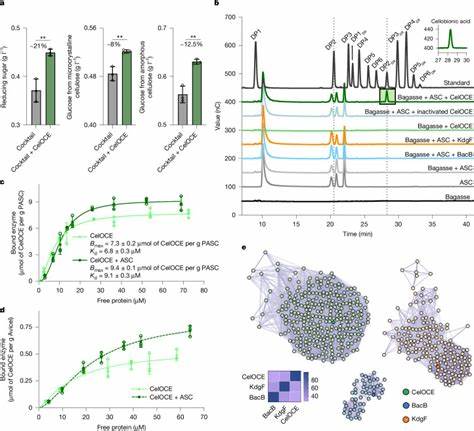

Beispielsweise versuchten Feature-Visualisierungen einzelne Neuronen mit klar definierbaren Aufgaben zu verbinden. Erste Erfolge suggerierten, dass einige Neuronen beispielsweise für das Erkennen von Merkmalen wie „Schnurrhaare“ zuständig seien. Doch beim genaueren Hinsehen zeigte sich, dass diese Neuronen oft multiplen, nicht zusammenhängenden Features reagieren, was die Deutung erschwerte. Salienz-Methoden, die herausfinden wollen, welche Teile einer Eingabe wichtig für eine Entscheidung sind, erweisen sich oft als unzuverlässig und ändern sich bei zufälliger Manipulation der Modellschichten kaum. Dies weist darauf hin, dass sie nicht das tatsächliche, gelernte Verhalten der Modelle widerspiegeln.

Die Illusion der Interpretierbarkeit zeigt sich auch bei Sprachmodellen wie BERT. Dort konnte zunächst eine neuronale Aktivierung für bestimmte Satzarten gefunden werden, die bei anderen Datensätzen plötzlich nicht mehr erkennbar war. Dies deutet darauf hin, dass es keine klar abgegrenzte neuronale Funktion für bestimmte Sprachmuster gibt. Selbst bei der Analyse großer Modelle wie DeepMinds Chinchilla mit 70 Milliarden Parametern gestaltete sich die Identifikation von neuronalen Schaltkreisen als äußerst zeitintensiv und ergab keine vollständigen Erklärungen. Dabei zeigt sich auch, wie fragil die Interpretationen sind, wenn sich die Aufgaben leicht ändern.

Eine vielversprechende Technik waren einst Sparse Autoencoder, die versuchten neuronale Aktivierungen auf eine minimale Anzahl von „aktiven“ Neuronen zu reduzieren. Doch auch hier scheiterte man daran, eine stabile und zuverlässige Zerlegung der komplexen Modelle in handhabbare Teile vorzunehmen. Die Erkenntnis aus diesen Forschungsversuchen ist klar: Komplexe KI-Modelle sind dynamisch, verteilt und nicht notwendigerweise in einfach zu erfassenden Subsystemen organisiert.Vor diesem Hintergrund gewinnen neue Interpretationsansätze an Bedeutung, die bewusst die Komplexität akzeptieren und versuchen, KI-Modelle auf höherer, abstrahierter Ebene zu verstehen. Dieses Top-Down-Denken entspricht dem Vorgehen in anderen komplexen Wissenschaftsdisziplinen, in denen Forscher sich auf emergente Eigenschaften konzentrieren und nicht auf die minutiöse Analyse einzelner Komponenten.

Die sogenannte Repräsentations-Engineering (RepE) Marktforscher bemüht sich, Muster und Charakteristika nicht einzelner Neuronen, sondern ganzer neuronaler Aktivitätsmuster zu analysieren und so besser zu manipulieren.Diese Methode hat bereits praktische Anwendungen gezeigt: Modelle wurden dahingehend angepasst, dass sie schädliche oder unerwünschte Konzepte loswerden, ehrlicher agieren und robuster gegen Angriffe werden können. Statt eine vollständige mechanistische Transparenz anzustreben, wird hier die Modellsteuerung auf einer Ebene betrieben, die für Menschen zugänglich und gleichzeitig nützlich ist. Besonders für die Sicherheit von KI und ethische Steuerbarkeit ist dieser Ansatz sehr vielversprechend.Trotzdem halten viele Forscher – die sogenannten „Neats“ – an mechanistischer Interpretierbarkeit fest, getrieben von einem Wunsch nach klaren, eleganten Erklärungen und einem tiefen Verständnis.

Diese Haltung steht im Gegensatz zu den „Scruffies“, die die Komplexität der Systeme anerkennen und pragmatisch mit der undurchsichtigen Natur von KI umgehen. Allerdings haben Studien und praktische Erfahrungen mit komplexen maschinellen Lernsystemen gezeigt, dass akkurate aber komplexe „black box“-Modelle leistungsfähiger sind als einfache, vollständig transparente Modelle.Das Festhalten an mechanistischer Interpretierbarkeit birgt die Gefahr, Ressourcen auf einen Ansatz zu verwenden, der kaum erfolgversprechend ist, während alternative Methoden vernachlässigt werden könnten. Es ist deshalb sinnvoll, die Forschungsausrichtung kritisch zu hinterfragen und gegebenenfalls die Schwerpunkte zu verschieben. Die jüngste Entscheidung von DeepMind, voll auf Sparse Autoencoders zu verzichten, illustriert diese Wende.

Das bekannteste Bild, das diese neue Sichtweise symbolisiert, ist die Analogie zu medizinischen Bildgebungsverfahren wie dem MRT. Ein MRT erlaubt es, gewisse Aktivitäten im Gehirn sichtbar zu machen, doch es kann nicht jeden einzelnen Gedanken neuronengenau verfolgen oder erklären. Entsprechend könnte eine „MRI für KI“ ein wertvolles Werkzeug sein, um das Verhalten von Modellen besser zu verstehen, ohne dass alle Details mechanistisch analysiert werden müssen.Zusammenfassend lässt sich sagen, dass mechanistische KI-Interpretierbarkeit zwar ein faszinierendes Ziel war, in der Praxis aber kaum umsetzbar ist. KI-Modelle sind komplexe Systeme mit emergenten Eigenschaften, die sich nicht einfach in einzelne, klar zu verstehende Mechanismen zerlegen lassen.

Stattdessen sollte die Forschung ein Umdenken vollziehen und sich auf top-down Ansätze konzentrieren, die Modelle als Ganzes betrachten und auf höheren Ebenen interpretierbar machen. Diese Richtung ist nicht nur realistischer, sondern bietet auch praktikable Wege zur Verbesserung der Sicherheit und Steuerbarkeit von KI-Systemen. In einer Welt, in der KI immer mehr Verantwortung erhält, ist es essenziell, die menschlichen Erwartungen an Verständnis und Kontrolle an die tatsächliche Natur dieser Technologien anzupassen und entsprechend zu handeln.