In der Welt des maschinellen Lernens sind Modell-Checkpoints von entscheidender Bedeutung. Sie markieren wichtige Fortschritte im Trainingsprozess und bieten die Möglichkeit, Modelle in verschiedenen Stadien zu evaluieren und zu vergleichen. Dabei ist es essenziell, dass diese Checkpoints nicht nur regelmäßig erstellt, sondern auch kontinuierlich überwacht und bewertet werden, um die Entwicklung und Qualität des Modells nachvollziehen zu können. Genau hier setzt Assayer an – ein einfaches, aber äußerst effizientes Werkzeug, das auf dem Python-RQ-Framework basiert und speziell für die Überwachung von ML-Modell-Checkpoints entwickelt wurde. Assayer automatisiert die Arbeitsschritte, die mit der Überwachung von Checkpoints verbunden sind.

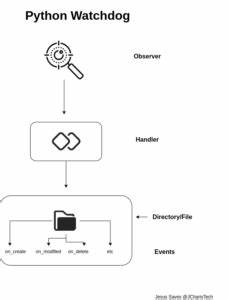

Es erkennt automatisch neu erstellte Modellversionen in einem angegebenen Verzeichnis und löst eigenständig Evaluationsprozesse aus. Diese Evaluierungen werden dabei offline durchgeführt, was bedeutet, dass sie das Training nicht blockieren oder verlangsamen. Dies ist insbesondere bei komplexen oder rechenintensiven Evaluationsvorgängen von großem Vorteil, wie beispielsweise bei der Anwendung von Language-Model-Harnesses oder anderen anspruchsvollen Testverfahren. Der Kern von Assayer basiert auf zwei entscheidenden Redis-Warteschlangen. Die erste dient der Überwachung – sogenannte Watch-Jobs verfolgen kontinuierlich das angegebene Verzeichnis, ob neue Checkpoints erschienen sind.

Sobald ein neuer Checkpoint detektiert wird, wird ein Evaluationsjob in einer zweiten Warteschlange ausgelöst. Dadurch wird sichergestellt, dass die Bewertungsprozesse asynchron und parallel ablaufen können, ohne den Trainingsverlauf zu stören. Dieses Prinzip ermöglicht es, dass mehrere Experimentordner gleichzeitig überwacht werden können und für jeden neuen Checkpoint direkt eine Bewertung gestartet wird. Ein weiterer wesentlicher Vorteil von Assayer liegt in der Flexibilität bei der Definition der Evaluationsfunktion. Nutzer implementieren eine eigene Funktion, welche als Argument eine Checkpoint-Dateipfad erhält und daraufhin die jeweilige Bewertung durchführt.

Diese Evaluationslogik ist völlig frei gestaltbar und kann sowohl einfache Metriken wie Genauigkeit, Verlust oder komplexe Analysen umfassen. Dabei besteht auch die Möglichkeit, die Evaluationsfunktion so zu gestalten, dass sie tatsächlich nur die Einreichung eines Jobs auf einem externen Cluster, wie etwa mit SLURM, bewirkt. Damit wird die Auslastung der unmittelbaren Evaluationsressourcen gering gehalten und die Evaluationsjobs werden effizient auf größere, externe Rechenressourcen verteilt. Die Installation von Assayer ist unkompliziert, benötigt jedoch das Redis-Datenbankmanagementsystem als Voraussetzung. Redis fungiert als das Rückgrat für die Warteschlangenverwaltung und verarbeitet die Job-Queues stabil und performant.

Insbesondere auf Linux-Systemen oder Rechnerclustern ist Redis leicht zu installieren und zu starten. Nach Einrichtung von Redis können die Python-Abhängigkeiten einfach über pip installiert werden, wobei auch das Assayer-Paket selbst direkt aus dem GitHub-Repository bezogen wird. Besonders hervorzuheben ist die Möglichkeit, die Filterkriterien für die Checkpoints individuell festzulegen. Standardmäßig überwacht Assayer Checkpoints mit gängigen Endungen wie .pt, .

pth, .ckpt, .model oder .state, aber mit einem flexiblen regulären Ausdrucksfilter lassen sich auch andere Dateiformate oder spezielle Namenskonventionen abdecken. Diese Eigenschaft sorgt dafür, dass das Tool in zahlreichen unterschiedlichen Projekten und Umgebungen ohne großen Anpassungsaufwand eingesetzt werden kann.

Die Skalierbarkeit von Assayer spiegelt sich ebenfalls in der Anzahl der eingesetzten Worker wider. Nutzer können durch Parameter die Zahl der Watch-Worker für die Überwachung und der Eval-Worker für die Ausführung der Evaluationsjobs individuell anpassen. So ist es möglich, die Ressourcen den Anforderungen anzupassen: bei weniger frequentem Erstellen von Checkpoints genügen wenige Worker, bei regelmäßigen und umfangreichen Evaluationen kann eine größere Anzahl parallel arbeitender Prozesse konfiguriert werden. Diese Anpassbarkeit verhindert Bottlenecks und gewährleistet eine zügige Bewertung der neuesten Modelle. Ein weiteres nützliches Feature ist die Evaluierung bereits bestehender Checkpoints in einem Verzeichnis.

Standardmäßig reagiert Assayer nur auf neu erstellte Dateien nach dem Start des Watch-Kommandos, aber auf Wunsch kann mit einem Zusatz-Flag auch eine Evaluierung aller vorhandenen Checkpoints angestoßen werden. Das ist praktisch, wenn man das Überwachungssystem nachträglich aufsetzen will oder vergangene Trainingsstände analysieren möchte. Um Assayer zu beenden, bietet das Tool einen einfachen Shutdown-Befehl, mit dem die Warteschlangen geleert und alle laufenden Worker ordnungsgemäß beendet werden. Anschließend kann der Redis-Server gestoppt werden, wobei auf diese Weise eine saubere Umgebung geschaffen wird. Aus der Perspektive der Entwickler wurde bewusst auf Abhängigkeiten von weiteren Packages wie watchdog verzichtet, um die Wartbarkeit gering zu halten und das Tool auch langfristig leicht nutzbar zu machen.

Ein besonders praxisnahes Beispiel für den Einsatz von Assayer ist die Integration in ein Trainingsszenario für die MNIST-Datenbank. Dort wird ein Convolutional Neural Network (CNN) trainiert, dessen Checkpoints kontinuierlich abgespeichert und automatisch durch Assayer bewertet werden. Die Evaluationsfunktion lädt den jeweiligen Checkpoint, berechnet die Genauigkeit und den Loss auf dem Testdatensatz und speichert die Ergebnisse als JSON-Datei. Diese einfache, aber effektive Demonstration zeigt, wie Assayer die Gesamteffizienz eines Trainings- und Evaluationsprozesses steigern kann. Für Forscher und Entwickler, die ihren Trainingsablauf überwachen wollen, bietet Assayer weit mehr als nur ein Benachrichtigungssystem.

Die Möglichkeit, mehrere Experimente parallel zu betreuen, sorgt gerade in großen Forschungsprojekten für einen erheblichen Zeitgewinn und eine bessere Übersicht. Automatische Evaluationsläufe fördern eine regelmäßige Kontrolle des Modellstatus und ermöglichen ein schnelleres Erkennen von Trainingsextremen wie Überanpassung oder Stagnation. Darüber hinaus fördert Assayer die Reproduzierbarkeit von Experimenten, indem es den Zusammenhang zwischen Checkpoint und dessen Bewertung nachvollziehbar hält. Standardisierte Evaluationsroutinen, die automatisch und systematisch angewendet werden, reduzieren menschliche Fehler und erleichtern die Dokumentation des Trainingsverlaufs. Die Anpassungsmöglichkeiten und die damit verbundene Flexibilität machen Assayer zudem ideal für unterschiedliche Arten von Modellen und Anwendungsfällen.

Ob es sich um klassische Bildklassifikation, komplexe Sprachmodelle oder andere Domänen handelt – das Grundprinzip bleibt dasselbe und kann einfach umgesetzt werden. Zusammenfassend ist Assayer ein wertvolles Werkzeug für Entwickler, die professionelle Kontrolle und Evaluation von ML-Modell-Checkpoints während des Trainingsprozesses suchen. Es automatisiert wesentliche Arbeitsschritte, bindet dabei keine Ressourcen, indem es auf asynchrone, parallelisierte Prozesse setzt, und hält den Trainingsprozess agil und transparent. Die leichte Installation, Konfigurierbarkeit und Skalierbarkeit machen das Tool zu einem integralen Bestandteil moderner maschineller Lern-Pipelines. Wer mit maschinellen Lernmodellen arbeitet, sollte Assayer in Betracht ziehen, um die eigene Workflow-Effizienz signifikant zu verbessern, Zeit zu sparen und die Modellqualität kontinuierlich im Blick zu behalten.

Das Tool kann problemlos in bestehende Entwicklungsumgebungen integriert und individuell angepasst werden und sorgt so für ein professionelles Monitoring und eine zuverlässige Bewertung von ML-Modellen.