Die Welt der Softwareentwicklung befindet sich seit einiger Zeit im Wandel. Künstliche Intelligenz und maschinelles Lernen sind nicht mehr nur Zukunftsvisionen, sondern fest integrierte Werkzeuge im Alltag von Programmierern. GitHub Copilot ist dabei eines der bemerkenswertesten Projekte, das KI nutzt, um Entwicklern direkt im Editor Vorschläge zu Codefragmenten zu machen. Seit Mai 2025 geht GitHub jedoch noch einen Schritt weiter: Mit der Einführung des sogenannten „Copilot“ Bot Users wird nicht nur im Privaten via Vorschlägen assistiert, sondern der Bot ist aktiv in zahlreichen Repositorien präsent und erzeugt automatisch Issues und Pull Requests. Dabei sorgt vor allem die Tatsache für erhebliche Kritik, dass dieser Bot von GitHub nicht blockiert werden kann – selbst von den Besitzern der Repositorien nicht.

GitHub ist die mit Abstand populärste Plattform für Code-Hosting und Kollaboration. Entwickler aus aller Welt nutzen das Portal, um Code gemeinsam zu erstellen, Fehler zu verwalten und neue Features zu diskutieren. In diesem Kontext hat das Versprechen, die Produktivität mittels KI zu steigern, viele Nutzer begeistert. GitHub Copilot als Plugin für beliebte Editoren wie Visual Studio Code bietet bereits wichtige Hilfestellungen. Doch mit der automatisierten Interaktion durch den Bot User auf Repositorien erzeugt sich eine neue und für viele unangenehme Situation.

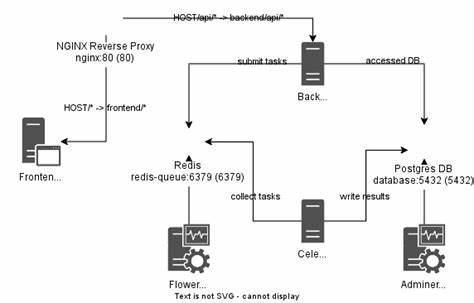

Das zentrale Problem ist, dass dieser Copilot Bot nicht als normaler Benutzer geführt wird. Er ist vielmehr ein spezieller Dienst, der auf der Backend-Seite in das GitHub-Ökosystem integriert ist. Dadurch gelten für ihn nicht dieselben Regeln wie für reguläre Accounts. Üblicherweise kann ein Repositoriumsbesitzer oder auch ein normaler Nutzer unerwünschte Benutzer blockieren – ein Schutzmechanismus gegen Spam, Missbrauch oder störende Bots. Im Gegensatz dazu ist der Copilot Bot von dieser Blockiermöglichkeit ausgenommen.

Diese Ausnahme führt dazu, dass viele Entwickler sich machtlos fühlen, wenn der Bot ungewünschte Issues oder Pull Requests erstellt, die häufig als Spam wahrgenommen werden. Das sorgt für eine breite Diskussion in der Entwickler-Community und hat bereits dutzende Beiträge auf Plattformen wie Mastodon oder GitHub-Foren ausgelöst. Viele Nutzer kritisieren, dass die Funktion, Benutzer zu blockieren, eine fundamentale Schutzmaßnahme ist, die durch Microsofts Einfluss auf GitHub an dieser Stelle genau umgangen wird. Dabei wird befürchtet, dass diese Praxis den Nutzern die Kontrolle über ihre eigenen Projekte entzieht. Ein nicht zu unterschätzender Faktor ist auch die Qualität der vom Copilot Bot erzeugten Inhalte.

Oft bestehen diese Issues oder Pull Requests aus automatisch generiertem Text, der nicht immer sinnvoll oder hilfreich erscheint. Die eigentliche Angst vieler Entwickler ist, dass die Veränderung von GitHub hin zu mehr Automatisierung durch KI diese Plattform mit „Müll“ füllt, der die Lesbarkeit und die Seriosität von offenen Projekten untergräbt. Gerade Open-Source-Projekte leben vom aktiven und hochwertigen Austausch ihrer Mitwirkenden. Wenn ein Bot ungefragt, immer wieder neue Tickets und Improvement-Vorschläge generiert, entsteht zusätzlicher Aufwand, der von echten Entwicklern getragen werden muss. Was kann man also tun, um mit dieser neuen Situation umzugehen? Zum einen haben einige Entwickler bereits eigene Human-Content-Richtlinien in ihre Repositorien aufgenommen, in denen klar formuliert wird, dass automatisiert generierte Beiträge nicht akzeptiert oder zumindest besonders behandelt werden.

Ein solcher Ansatz dient als klare Ansage an menschliche Kollegen und signalisiert auch, dass maschinell erzeugte Beiträge einer erhöhten Prüfung unterzogen werden. Darüber hinaus gibt es Bestrebungen, auf alternative Plattformen umzusteigen oder zumindest als Ergänzung zu nutzen. Codeberg, GitLab oder Sourcehut gehören zu den favorisierten Alternativen, die überwiegend von der Community unabhängig sind und andere Schwerpunkte im Bereich Datenschutz, Nutzerkontrolle und Offentlickeitsgestaltung setzen. Insbesondere Codeberg wird gern als demokratisch organisierte, genossenschaftliche Plattform beschrieben, die strengere Regeln für Bot-Interaktionen und KI-Einsatz verfolgt. Ebenso erfreut sich Sourcehut zunehmender Beliebtheit, auch wenn das Interface noch als sehr minimalistisch gilt.

Die Debatte um die Unblockierbarkeit des Copilot Bots führt auch zu einer grundsätzlichen Reflexion über die Rolle von Künstlicher Intelligenz in der Softwareentwicklung. Einerseits bietet KI enorme Chancen zur Effizienzsteigerung und Unterstützung. Auf der anderen Seite wird die Gefahr gesehen, dass der Mensch und seine kreative, kontextbezogene Leistung zurückgedrängt wird. Gerade bei Open-Source-Projekten, bei denen Vertrauen und Transparenz grundlegend sind, wird die Balance zwischen Automation und menschlicher Kontrolle besonders kritisch gesehen. Einige Experten vermuten, dass die spezielle Art der Bot-Implementierung kein böswilliges „Sonderrecht“ für Microsoft oder GitHub darstellt, sondern eher einem technischen Designentscheid geschuldet ist.

Der Bot ist nicht wie ein normaler User angelegt, sondern als Backend-Service, der sich lediglich in der Nutzeroberfläche wie ein User verhält. Eine echte Blockierfunktion sei deshalb technisch nicht ohne weiteres möglich. Dennoch erweckt diese Situation bei den Nutzern den Eindruck, dass GitHub sich bewusst an den Interessen des Copilot-Projekts vorbeimogelt, um es möglichst umfassend durchzusetzen. Was bedeutet das langfristig für Entwickler? Viele sind zu Recht skeptisch, ob ihre Projekte auf GitHub künftig noch frei von unerwünschtem Bot-Spam bleiben können. Die automatische Generierung von Issues oder Pull Requests kann zu einer Überflutung führen, bei der relevante Beiträge leichter übersehen werden.

Gleichzeitig wird durch die fehlende Möglichkeit, den Copilot Bot zu blockieren, der empfundene Verlust an Kontrolle zu einem zentralen Kritikpunkt. Praktische Tipps für Entwickler sind, die eigenen Repositorien mit klaren Beitragsrichtlinien auszustatten und automatisierte Beiträge entsprechend zu behandeln. Außerdem kann das Auslagern bestimmter Projekte auf alternative Plattformen sinnvoll sein, wo solche Kopilot-Bots nicht aktiv sind oder sich leichter kontrollieren lassen. Auch die Sensibilisierung der Community und der Austausch über Workarounds sind wichtige Schritte. Ein weiteres Thema im Gesamtgefüge ist die Handhabung von Datenschutz und Nutzerrechten.

Die automatische Interaktion von Bots wirft beim sensiblen Thema Quellcode auch Fragen zur Einhaltung von Lizenzen und geistigem Eigentum auf. Wenn der Bot Code-Teile oder Issues aufgrund von automatischer Verarbeitung generiert, ist unklar, ob die geltenden Lizenzbedingungen beachtet werden. All das sorgt für eine Unsicherheit, die viele Open-Source-Entwickler beschäftigt. Insgesamt steht fest, dass Künstliche Intelligenz die Softwareentwicklung grundlegend verändern wird. Doch die Art und Weise, wie Plattformen wie GitHub dieses Potenzial nutzen, spiegelt auch die Machtverhältnisse im Ökosystem wider.

Der „Copilot“ Bot, der sich der Blockierbarkeit entzieht, ist deshalb nicht nur ein technisches Thema, sondern auch ein gesellschaftliches. Es zeigt auf, wie wichtig Transparenz, Nutzerorientierung und ethische Leitlinien sind, wenn neue Technologien tief in alltägliche Arbeitsabläufe eingreifen. Während viele Entwickler sich auf der Suche nach Lösungen befinden, steht eines fest: Die Community wird keinesfalls kampflos hinnehmen, dass ihre Selbstbestimmung und die Qualität ihrer Projekte durch solche „Spezialfälle“ untergraben werden. Die Diskussionen der letzten Monate zeigen, dass ein breiter Dialog zwischen Anbietern, Nutzern und KI-Experten geführt werden muss, um faire Regeln und Mechanismen für einen verantwortungsvollen Einsatz von KI in der Softwareentwicklung zu schaffen. Abschließend lässt sich festhalten, dass die Situation mit dem GitHub Copilot Bot viele Fragen aufwirft, die derzeit weder technisch noch ethisch abschließend geklärt sind.

Entwickler sollten wachsam bleiben, eigene Schutzmaßnahmen treffen und sich über alternative Plattformen informieren. Gleichzeitig ist es auch ratsam, aktiv in Diskussionen und Projekte einzusteigen, die Standards zum Umgang mit KI-gestützter Automatisierung in der Softwareentwicklung definieren. Nur so kann gewährleistet werden, dass Innovationen wie GitHub Copilot den Arbeitsalltag bereichern, ohne die Kontrolle und Qualität der Entwicklergemeinschaft zu gefährden.