Die rasante Entwicklung der Künstlichen Intelligenz (KI) und speziell der großen Sprachmodelle (Large Language Models, LLMs) hat viele Fachleute in der Softwarebranche vor eine wichtige Entscheidung gestellt: Soll man sich tief in die technischen und wissenschaftlichen Grundlagen dieser Technologien einarbeiten oder sie primär als Werkzeuge für die tägliche Entwicklungsarbeit nutzen? Diese Frage ist heute aktueller denn je, da KI-Anwendungen zunehmend alltäglich werden und sich der Arbeitsalltag von Programmierern und Ingenieuren stark verändert. Zum besseren Verständnis lohnt es sich zunächst, die Rolle von LLMs im aktuellen Technologiekontext zu betrachten. Im Gegensatz zu klassischen Algorithmen, die nach klar definierten Regeln arbeiten, basieren LLMs auf neuronalen Netzwerken und probabilistischen Modellen. Sie erzeugen Texte oder Codes auf Grundlage riesiger Datenmengen, Mustererkennung und Wahrscheinlichkeitsverteilungen. Dabei sind sie nicht frei von Fehlern, produzieren teils unerwartete Ergebnisse und erfordern ein gewisses Maß an kontrolliertem Einsatz.

Für viele Softwareentwickler steht deshalb die Frage im Raum: Ist es notwendig oder gar sinnvoll, sich tief mit dem Inneren dieser Modelle, wie deren mathematischen Grundlagen, der Funktionsweise von Transformern oder Trainingsmethoden, auseinanderzusetzen? Oder reicht es aus, die KI als mächtiges Tool in den gewohnten Entwicklungsprozess zu integrieren und sich auf die Entwicklung von Anwendungen und Produkten zu fokussieren? Ein Argument, das häufig für den tiefen Einstieg in KI-Forschung und LLM-Interna angeführt wird, ist die zunehmende Bedeutung von KIs als Kerntechnologie. Wie bei früheren technologischen Revolutionen – beispielsweise bei Datenbanken, Netzwerksystemen oder Web-Frameworks – entstehen spezialisierte Rollen, die genau diese Systeme verstehen, optimieren und weiterentwickeln. Dies erfordert neben fundiertem technischen Wissen auch eine wissenschaftliche Neugier und die Bereitschaft, sich stetig weiterzubilden. Allerdings sehen viele Experten die heutigen LLMs zunehmend in der Phase der Kommoditisierung. Das bedeutet, dass die reine Entwicklung solcher Modelle spezialisierten Forschungsinstituten und Großunternehmen vorbehalten bleibt, während der Großteil der Entwickler diese Modelle als schwarze Boxen durch Schnittstellen und APIs nutzt.

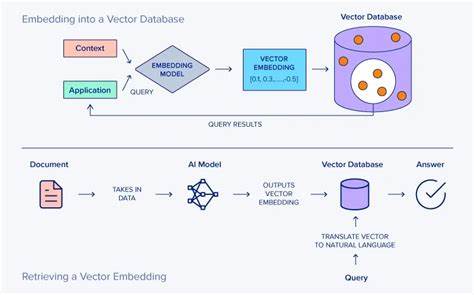

Ähnlich wie bei Datenbanken oder Betriebssystemen, die viele Entwickler nicht auf Code-Ebene verstehen, sondern effizient einsetzen, können auch LLMs überwiegend als Werkzeuge betrachtet werden. Ein hilfreiches Mittelmaß ist es, ein grundlegendes Verständnis über die Funktionsweise von LLMs zu entwickeln. Dazu gehört das Wissen um Konzept wie Embeddings, Transformer-Architekturen, Tokenisierung und Sampling-Methoden. Dieses Wissen ermöglicht es, realistische Erwartungen an die Leistungsfähigkeit der KI zu haben und typische Limitierungen zu erkennen. Ein Programmierer, der diese Grundlagen kennt, kann LLMs bewusster und effizienter einsetzen.

Der praktische Nutzen von LLMs im Arbeitsalltag ist dabei nicht zu unterschätzen. Viele Entwickler berichten, dass die Assistenz durch KI bei Codevervollständigung, Dokumentation oder Fehlersuche die Produktivität deutlich steigert. So können Routineaufgaben schneller erledigt, Prototypen schneller entwickelt und komplexe Zusammenhänge leichter überblickt werden. Das macht KI zu einem echten Produktivitätsmultiplikator. Allerdings birgt die Nutzung von KI-Tools auch Herausforderungen.

Da LLMs nicht immer korrekte oder optimale Ergebnisse produzieren, müssen Entwickler die generierten Vorschläge kritisch hinterfragen und professionell nachbearbeiten. Die Fähigkeit, KI-Ausgaben sinnvoll zu überprüfen und zu optimieren, wird in Zukunft ebenso wichtig wie das reine Programmieren. Wer tiefer in das Thema einsteigen möchte, dem wird oft geraten, sich mit einfacheren neuronalen Netzwerkmodellen vertraut zu machen und selbst kleinere Netzwerke von Grund auf zu implementieren. Das schafft ein besseres Gefühl für die Mechanismen des maschinellen Lernens. Anschließend lohnt sich die Auseinandersetzung mit hochentwickelten Modellen wie Transformern und Fortgeschrittenen Trainingsstrategien, um ein qualitatives Verständnis zu erlangen.

Darüber hinaus entwickeln sich neue Berufsbilder wie der „AI Engineer“ oder der „LLM Whisperer“, die an der Schnittstelle zwischen Forschung, Entwicklung und Anwendung stehen. Diese Rollen beinhalten neben technischem Know-how auch die Fähigkeit, KI-Systeme in existierende Prozesse zu integrieren, die richtigen Anwendungsfälle zu identifizieren und Workflows zu orchestrieren, die KI-Komponenten intelligent einsetzen. Ein weiterer wichtiger Aspekt ist die sich wandelnde Arbeitswelt für Softwareentwickler. KI-Technologien verändern die Art und Weise, wie Software entsteht und verbessert wird. Dies erfordert neue Kompetenzen und eine experimentelle Haltung.

Ein „Learning by Doing“-Ansatz, bei dem Entwickler aktiv mit KI-Tools arbeiten, diese hinterfragen und weiterentwickeln ist essenziell. Langfristig betrachtet gibt es auch berechtigte Sorgen über Beschäftigungseffekte durch KI. Einige befürchten, dass Automatisierung in Bereichen wie Full-Stack-Entwicklung zu einem veränderten Jobmarkt mit höherem Wettbewerb und eventuell weniger Stellen führt. Andererseits entstehen durch KI völlig neue Möglichkeiten und Nischen, in denen menschliche Expertise unverzichtbar bleibt. Daher kann die Entscheidung, ob man in die Tiefen der KI-Forschung eintaucht oder KI primär als Werkzeug benutzt, auch eine persönliche Frage der Interessen und Karriereziele sein.

Wer von Natur aus Freude am Forschen und am mathematisch-technischen Tiefgang hat, könnte in Forschungsrollen oder spezialisierten Entwicklungsbereichen aufblühen. Wer hingegen praxisorientiert arbeitet und schnelle Ergebnisse erzielen will, findet in der Nutzung von LLMs als Tool wertvolle Unterstützung. Letztlich ist es wichtig, offen für Veränderungen zu bleiben und kontinuierlich dazuzulernen. Die KI-Landschaft ist dynamisch und entwickelt sich rasant weiter. Was heute neu erscheint, kann morgen schon etabliert sein.