Die rasante Entwicklung großer Sprachmodelle (Large Language Models, LLMs) hat in den letzten Jahren zahlreiche Fachgebiete revolutioniert – nicht zuletzt die Chemie. Durch ihre Fähigkeit, natürliche Sprache zu verstehen und zu generieren, bieten diese Modelle neue Möglichkeiten, chemisches Wissen zu verarbeiten, Fragen zu beantworten und selbst komplexe Probleme zu lösen. Doch wie stehen diese KI-Systeme im Vergleich zu erfahrenen Chemikerinnen und Chemikern? Welche Chancen und Grenzen ergeben sich durch ihre Anwendung? Diese Fragen sind angesichts der zunehmenden Integration von Künstlicher Intelligenz (KI) in die Wissenschaft von großer Relevanz. Große Sprachmodelle sind darauf trainiert, auf Grundlage riesiger Textmengen mittels maschinellen Lernens sinnvolle und kohärente Antworten zu formulieren. Aufgrund der Skalierung und Vielfalt der Datenquellen haben die führenden Modelle inzwischen Fähigkeiten erreicht, die teilweise mit menschlichen Expertinnen und Experten konkurrieren oder sie sogar übertreffen können – zumindest bei bestimmten Aufgaben.

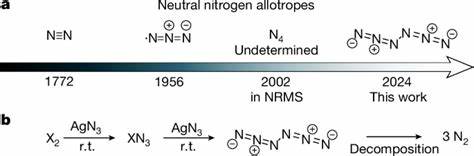

In der Chemie zeigt sich ein vergleichbares Bild: Projekte wie ChemBench ermöglichen es, die chemischen Kenntnisse und das Denkvermögen von LLMs objektiv zu messen und mit menschlichen Leistungen zu vergleichen. Dabei ist bemerkenswert, dass einige Modelle in gewissen Bereichen selbst hochqualifizierte Chemikerinnen und Chemiker übertreffen. Der ChemBench-Ansatz fußt auf einem umfangreichen Fragenkatalog von über 2700 Aufgaben, der verschiedene Themenfelder der Chemie abdeckt und sowohl grundlegendes Wissen als auch komplexes logisches Schlussfolgern erfasst. Die Fragen umfassen allgemeine Chemie ebenso wie spezialisierte Disziplinen, etwa anorganische, analytische oder technische Chemie. Wichtig ist, dass nicht ausschließlich Multiple-Choice-Aufgaben verwendet werden, sondern auch offene Fragen, die das kreative und kontextabhängige Verständnis der Modelle prüfen.

Zudem werden Fähigkeiten wie Wissen, Berechnung, Argumentation und Intuition erfasst, um ein umfassendes Bild der Modellkompetenzen zu gewinnen. Die Tests offenbaren eine faszinierende Mischung aus Stärken und Schwächen der KI-Systeme. So punktet das beste derzeit verfügbare Modell in der Gesamtwertung sogar deutlich besser als die besten menschlichen Testteilnehmer. Dabei zeigen viele Modelle ein ausgeprägtes Faktenwissen und sind in der Lage, gängige Fragestellungen schnell und korrekt zu beantworten. Dies unterstreicht die Fähigkeit der Algorithmen, große Wissensbestände effizient zu verarbeiten und anzuwenden.

Andererseits treten Defizite bei Aufgaben auf, die tiefere chemische Intuition oder die exakte mechanistische Begründung von Phänomenen verlangen. Beispielsweise fällt es den Modellen schwer, die Anzahl eindeutig verschiedener Signale in einem NMR-Spektrum korrekt vorherzusagen, was selbst erfahrene Chemiker mit visueller Molekülvorlage schon fordert. Diese Diskrepanz verweist darauf, dass die LLMs bislang eher Muster und Korrelationen aus den Trainingsdaten erkennen, als wirklich nachvollziehbar zu strukturieren und zu kombinieren. Ein weiterer kritischer Aspekt liegt in der Unsicherheitsabschätzung der Modelle. Die Fähigkeit, selbst einzuschätzen, wie zuverlässig eine gegebene Antwort ist, ist besonders im naturwissenschaftlichen Kontext essentiell.

Hier zeigten die Untersuchungen, dass die Sprachmodelle häufig übermäßig selbstsicher auftreten und somit fehlerhafte Aussagen kaum als unsicher erkennen oder kommunizieren. Dies birgt Risiken, besonders für Anwender ohne tiefgehende Fachexpertise, die sich auf die KI-Ergebnisse verlassen. Die Durchlässigkeit und Vertrauenwürdigkeit der Modelle ist daher derzeit ein großer Gegenstand der Forschung. Bezüglich der Spezialgebiete ist die Leistungsfähigkeit der Systeme gemischt. Während zu allgemeinen und technischen Themen häufig solide Ergebnisse erzielt werden, schneiden die KI-Modelle bei sicherheitsrelevanten Inhalten, beispielsweise zur Toxizität oder chemischen Sicherheitskennzeichnungen, bislang vergleichsweise schwach ab.

Hier wirken sowohl die Komplexität der Materie als auch zurückhaltende Sicherheitsfilter der Anbieter, die automatische Auskünfte zu potenziell gefährlichen Substanzen einschränken, als limitierende Faktoren. Auch in der Bewertung chemischer Präferenzen und Intuition, die für Anwendungen wie Wirkstoffentwicklung zentral sind, bleiben die Modelle hinter menschlichen Experten zurück. Trotz eines gut etablierten Datensatzes, in dem erfahrene Chemiker Paare von Molekülen hinsichtlich ihrer Präferenz wählten, konnte keine sinnvolle Übereinstimmung durch die Modelle erzielt werden. Das zeigt, dass emotionale, ästhetische und erfahrungsbasierte Einschätzungen noch besonders schwer algorithmisch abbildbar sind. Ein spannender Trend ist, dass die Leistungsfähigkeit der großen Sprachmodelle mit deren Parameterzahl und Datenumfang zunimmt.

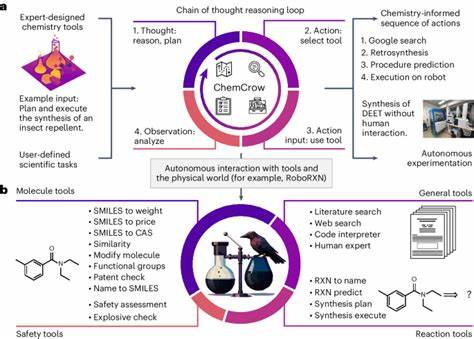

Dies entspricht allgemeinen Beobachtungen beim maschinellen Lernen. Zugleich eröffnet der offene Zugang zu hochperformanten, quelloffenen Modellen, wie zum Beispiel Llama-3, neue Möglichkeiten für Forschende, die ohne proprietäre Systeme hochwertige Ergebnisse erzielen möchten. Die Integration von speziellen chemischen Datenbanken, Rechenwerkzeugen und Literaturdaten scheint hierbei ein vielversprechender Weg, um die Wissensbasis der Modelle weiter zu verbessern und ihre praktische Nutzbarkeit zu erhöhen. Die Befunde werfen jedoch auch grundsätzliche Fragen zum zukünftigen Umgang mit chemischer Ausbildung und Forschung auf. Während traditionelles Lernen häufig auf Auswendiglernen und das Lösen bekannter Standardaufgaben abzielt, zeigt sich, dass KI hier schon jetzt überlegen agieren kann.

Stattdessen wird zunehmend kritisches Denken, die Fähigkeit, abstrakte Probleme zu durchdringen und Kontextwissen zu verknüpfen, mehr an Bedeutung gewinnen. Lehrpläne und Prüfungsformate könnten sich daher verändern müssen, um Chemikerinnen und Chemiker optimal auf die Zusammenarbeit mit KI-Systemen vorzubereiten. Zusammengefasst bietet der Einsatz von großen Sprachmodellen in der Chemie enorme Chancen. Ob bei der schnellen Beantwortung fachlicher Fragen, der Unterstützung von Forschungsprojekten oder der automatischen Extraktion von Wissen aus der Literatur – LLMs können den wissenschaftlichen Prozess beschleunigen und ergänzen. Gleichzeitig bleiben Einschränkungen in der Verlässlichkeit und im tiefgreifenden Verständnis bestehen, die einem unreflektierten Einsatz Grenzen setzen.

Die aktive Zusammenarbeit von KI-Entwicklern, Chemikerinnen und Chemikern sowie Pädagoginnen und Pädagogen wird entscheidend sein, um diese Technologien verantwortungsvoll zu gestalten und zu nutzen. Innovative Evaluationsframeworks wie ChemBench spielen dabei eine Schlüsselrolle. Sie ermöglichen es, Fortschritte systematisch zu messen, Schwächen zu identifizieren und damit gezielt Verbesserungen voranzutreiben. Zudem sorgen sie für Transparenz und einen realistischen Blick auf die Fähigkeiten von KI in der Chemie. So ist ein konstruktiver Dialog und eine enge Verzahnung von menschlicher Expertise und künstlicher Intelligenz zu erwarten, die zusammen zukünftige Durchbrüche in der Chemie ermöglichen.

In einer Ära, in der Sprache und Wissen zunehmend in digitalen Formaten vorliegen, erschließen große Sprachmodelle bislang unerschlossene Potenziale. Indem sie den menschlichen Forschergeist ergänzen und teilweise herausfordern, zeichnen sie ein Bild von Chemie der Zukunft, in der Interaktion zwischen Mensch und Maschine den Fortschritt neu definiert und erweitert.