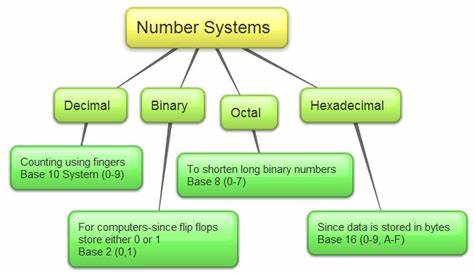

Die Welt der Computersysteme ist tief verwurzelt in der Fähigkeit, Zahlen präzise und effizient darzustellen. Denn Computer arbeiten nicht mit den Dezimalzahlen, die wir täglich verwenden, sondern ausschließlich mit einer binären Codierung. Diese binäre Darstellung, die nur die Zahlen 0 und 1 kennt, ermöglicht es elektronischen Schaltungen, komplexe Daten zu verarbeiten und logische Operationen auszuführen. Die digitale Revolution wäre ohne das Verständnis und die Umsetzung der verschiedenen numerischen Repräsentationen in Computerhardware und Software undenkbar. Anfänglich standen Ingenieure und Wissenschaftler vor einer großen Herausforderung: Wie kann man reelle und ganzzahlige Zahlen innerhalb eines Systems abbilden, das nur zwei Zustände kennt? Hierbei spielen verschiedene Konzepte eine entscheidende Rolle, die nicht nur die Effizienz und Geschwindigkeit moderner Geräte beeinflussen, sondern auch die Genauigkeit und Fehleranfälligkeit bei Berechnungen.

Eine der grundlegenden Voraussetzungen für jede numerische Darstellung in einem Computer ist die Beschränkung durch die Anzahl der verfügbaren Bits. Jedes Bit kann entweder den Wert 0 oder 1 annehmen. Daraus ergibt sich eine Vielzahl von möglichen Kombinationen, deren Quantität durch die Potenz von zwei bestimmt wird, also 2 hoch n, wobei n die Anzahl der Bits beschreibt. Beispielsweise kann ein 4-Bit-System genau 16 verschiedene Werte darstellen, von 0 bis 15. Diese grundlegende Eigenschaft legt die maximale Reichweite von Zahlen fest, die ein Computer in einem bestimmten Speicherbereich abbilden kann.

Dabei ist der Begriff der Wertebereichs sehr entscheidend. Ein rein positiver Wertebereich lässt sich mit der sogenannten unsigned Integer-Darstellung realisieren. Diese Verwendung ist besonders in Fällen optimal, in denen negative Zahlen nicht relevant sind, beispielsweise bei Speicheradressen. Obwohl einfach, kann der unsigned-Modus nur Werte von null bis zum Maximalwert 2 hoch n minus eins abbilden. Komplexer wird es, wenn auch negative Zahlen dargestellt werden sollen.

Hierfür wurden verschiedene Darstellungsformen entwickelt, die sich hinsichtlich Effizienz und Implementierungsaufwand unterscheiden. Eine der ältesten Methoden ist das Sign-Magnitude-Verfahren, bei dem das höchstwertige Bit als Vorzeichenbit fungiert. Dieses Bit zeigt an, ob es sich um eine positive oder negative Zahl handelt, während die verbleibenden Bits den absoluten Betrag der Zahl speichern. Trotz seiner Einfachheit besitzt dieses Verfahren einen wesentlichen Nachteil: Es existieren zwei Darstellungen für die Zahl Null, nämlich +0 und -0. Dies führt zu Verwirrungen in arithmetischen Operationen und erschwert die Hardware-Implementierung.

Um diese Probleme zu umgehen, etablierten sich sogenannte Komplement-Darstellungen. Insbesondere die sogenannte Zweierkomplement-Darstellung hat sich weltweit als Standard durchgesetzt. Sie ermöglicht nicht nur eine eindeutige Darstellung der Null, sondern vereinfacht auch die Addition und Subtraktion von Zahlen, unabhängig von deren Vorzeichen. Bei der Zweierkomplement-Darstellung wird das negative Äquivalent einer Zahl durch Invertierung aller Bits und Addition von eins erzeugt. Dadurch entsteht eine symmetrische Werteverteilung zwischen positiven und negativen Zahlen, wobei das höchstwertige Bit weiterhin als Vorzeichenbit fungiert.

Neben der Darstellung von Ganzzahlen stellt die Abbildung von reellen Zahlen eine noch größere Herausforderung dar. Reelle Zahlen umfassen neben ganzen Zahlen auch Brüche und Zahlen mit Nachkommastellen, deren exakte Repräsentation im Binärsystem nicht immer möglich ist. Viele Zahlen, beispielweise 1/3 oder 0,1, besitzen im Binärsystem unendliche periodische Folgen, weshalb eine exakte Kodierung im normalen Rahmen der Speichergröße nicht realisierbar ist. Deshalb sind Näherungen und Rundungen notwendig, was zwangsläufig zu Präzisionsverlust und kleinen Fehlern führt. Die Lösung für diese Problematik fanden Forscher in der Entwicklung der Gleitkommadarstellung (floating point).

Diese Methode ähnelt der wissenschaftlichen Notation, bei der eine Zahl als Produkt von Signifikand (Mantisse) und Basis potenziert mit einem Exponenten dargestellt wird. Das IEEE 754-Format standardisiert diese Gleitkommazahlen für Computergrafik, wissenschaftliche Berechnungen und allgemeine Programmierung. Die Gleitkommadarstellung erlaubt die Abbildung sehr großer und sehr kleiner Zahlen in einem definierten Wertebereich mit einer festgelegten Genauigkeit. Im Inneren moderner Computer übernimmt oft eine spezialisierte Einheit, die sogenannte Floating Point Unit (FPU), die Aufgabe der Gleitkommaberechnung. Die FPU ist dafür optimiert, Operationen wie Addition, Subtraktion, Multiplikation und Division von Gleitkommazahlen sehr schnell und effizient durchzuführen.

Dabei werden komplexe Vorgänge wie das Angleichen der Exponenten, die Normalisierung der Ergebnisse und ein präzises Runden intern abgewickelt. Die Implementierung dieser numerischen Systeme hat einen großen Einfluss auf die Programmierung. Programmiersprachen wie C und C++ unterscheiden zwischen verschiedenen Datentypen, um den Bedarf an Genauigkeit und Speicherplatz optimal abzudecken. Während „float“ für einfache Gleitkommazahlen mit 32 Bit steht, bietet der Datentyp „double“ eine höhere Präzision mit 64 Bit. Dies ermöglicht flexiblen Umgang mit unterschiedlichen Rechenanforderungen und verhindert Fehler durch unnötige Speicherung von zu belastenden Zahlen.

Ein bedeutender Aspekt ist zudem, wie ein Prozessor zwischen unterschiedlichen Datentypen oder Darstellungsmethoden unterscheidet. Die Antwort lautet: Er unterscheidet nicht von sich aus. Ein Prozessor empfängt eine Folge von Bits und interpretiert sie entsprechend der Anweisung eines Programms, die vom Entwickler vorgegeben wird. Ohne diesen Kontext bleiben die Daten nur eine abstrakte binäre Folge, die alles Mögliche darstellen kann – Zahlen, Buchstaben, Farben oder Befehle. Durch all diese Entwicklungen konnten Computer immer komplexere Anwendungen bewältigen – von wissenschaftlichen Berechnungen über Grafikbearbeitung bis hin zu künstlicher Intelligenz.