Kubernetes hat sich als dominierende Plattform für die Orchestrierung von Container-Anwendungen etabliert. Doch mit der zunehmenden Komplexität der Infrastruktur wächst auch der Bedarf an flexiblen und leistungsfähigen Werkzeugen, die nicht nur die Bereitstellung von Ressourcen, sondern auch deren Verwaltung und Abhängigkeiten adressieren. In diesem Kontext hat sich Koreo als eine innovative Lösung im Bereich Platform Engineering positioniert. Doch was genau ist Koreo, und warum gewinnt dieses Toolkit im Kubernetes-Ökosystem immer mehr an Bedeutung? Koreo ist ein Open-Source-Toolkit, das speziell für das Platform Engineering in Kubernetes-Umgebungen entwickelt wurde. Es vereint zwei zentrale Aspekte, die für den Betrieb moderner Cloud-Plattformen entscheidend sind: Konfigurationsmanagement und Ressourcenorchestrierung.

Während klassische Tools wie Helm und Kustomize vor allem auf das Management von YAML-Manifesten zur Ressourcenbeschreibung fokussiert sind, erweitert Koreo diese Funktionalitäten um eine programmierbare und workflow-basierte Steuerung der Ressourcenlebenszyklen. Ein grundlegendes Problem vieler existierender Kubernetes-Tools ist die Trennung zwischen bloßem Templating der Ressourcen und der eigentlichen Orchestrierung komplexer Abhängigkeiten. Helm bietet eine einfache Methode, um Helm-Charts als Templates zu verwenden, die sich über Werte-Dateien anpassen lassen. Allerdings stößt Helm schnell an seine Grenzen, sobald die Templates Logik enthalten oder von verschachtelten Bedingungen abhängen. Das macht die Entwicklungs- und Wartungsprozesse unübersichtlich und fehleranfällig.

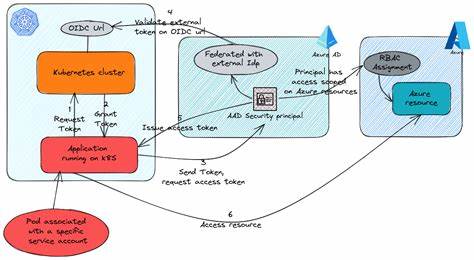

Kustomize wiederum liefert eine strukturierte Methode, Basisressourcen durch Overlays und Patches anzupassen. Diese Herangehensweise eignet sich für statische Variationen, stößt aber an ihre Grenzen, wenn dynamische Werte oder eine komplexe Verknüpfung zu anderen Ressourcen erforderlich sind. Wichtige Szenarien, in denen Kubernetes-Ressourcen voneinander abhängen, lassen sich mit diesen Werkzeugen kaum elegant und zuverlässig abbilden. Genau an diesem Punkt setzt Koreo an. Es kombiniert die deklarative Definition von Ressourcen mit einem programmierbaren Workflow-Engine-Ansatz.

Kernkonzepte von Koreo sind hierbei sogenannte Funktionen und Workflows. Funktionen sind kleine, wiederverwendbare logische Bausteine, die entweder pure Werte berechnen (ValueFunctions) oder auf Kubernetes-Ressourcen zugreifen und diese manipulieren können (ResourceFunctions). Diese Funktionen lassen sich in Workflows zusammenfügen, die als gerichtete Graphen aus Schritten, Bedingungen und Abhängigkeiten definiert werden. So entsteht ein flexibles, YAML-basiertes Steuerungssystem, das sowohl die Konfiguration als auch die Orchestrierung komplexer Abläufe bündelt. Ein entscheidender Vorteil von Koreo ist dabei die explizite Sichtbarkeit und Testbarkeit der einzelnen Komponenten.

Plattformingenieure können die Materialisierung von Ressourcen exakt überprüfen und validieren, noch bevor diese in einem Cluster ausgerollt werden. Dies adressiert eine typische Schwachstelle bei anderen Tools, bei denen Änderungen erst direkt im Cluster getestet werden können, was zu langen Feedbackzyklen und erhöhter Fehleranfälligkeit führt. Der Ursprung von Koreo liegt in der praktischen Notwendigkeit, hybride Cloud-Umgebungen effizient zu verwalten. Die Entwickler hinter Koreo suchten nach Lösungen, um cloudübergreifend mit Google Cloud Platform (GCP) und Amazon Web Services (AWS) zu arbeiten – insbesondere unter Einsatz von Config Connector und AWS Controllers for Kubernetes (ACK). Bekannte Werkzeuge wie Crossplane erschienen ihnen zwar leistungsfähig, zeigten aber Herausforderungen wie hohe Komplexität und eingeschränkte Multitenancy-Fähigkeiten.

Die Kombination aus einer flexiblen Template-Engine und einer einfachen Workflow-Orchestrierung führte letztlich zur Gründung von Koreo. Was Koreo besonders macht, ist seine softwareentwicklerfreundliche Philosophie. Es betrachtet Platform Engineering als eine Disziplin, die die gleichen Prinzipien klarer Interfaces, modularer Komponenten und rigoroser Tests verdient wie die traditionelle Anwendungsentwicklung. Durch die Verwendung von YAML bleibt Koreo nah an der zugrunde liegenden Kubernetes-Welt, reduziert die mentale Komplexität und erleichtert die Übernahme für Entwickler, die bereits mit Kubernetes vertraut sind. Mit Koreo können Plattformteams ihre gesamte Plattform-Architektur als Code definieren, testen und versionieren.

Workflows erlauben das Zusammenspiel verschiedener Ressourcen, so dass deren Ein- und Ausgaben miteinander verknüpft werden. Ein Beispiel wäre die automatische Bereitstellung eines Google Kubernetes Engine (GKE) Clusters inklusive Netzwerkpolicies und der Rollout einer Anwendung basierend auf einer höherwertigen Tenant-Spezifikation. Jeder Schritt in diesem Prozess ist transparent, nachvollziehbar und kann individuell angepasst werden. Die Integration externer Controller und Operatoren wie Config Connector und ACK erfolgt nahtlos. Statt individuelle Operatoren für jede Anforderung erstellen zu müssen, lässt sich Koreo als zentrale Plattform verwenden, die alle Ressourcen orchestriert und kontrolliert.

Dies führt zu einer vereinfachten Architektur, die gleichzeitig skalierbar und flexibel bleibt. Aktuelle Weiterentwicklungen von Koreo konzentrieren sich auf die Verbesserung der Nutzererfahrung, wie etwa verbesserte statische Typprüfungen, Debugging-Features für Workflows und eine grafische Benutzeroberfläche zur Visualisierung von Ablaufgraphen. Zudem wächst das Spektrum an unterstützten Szenarien stetig, von einfachen Ressourcenbereitstellungen bis hin zu komplexen multi-cluster Umgebungen, die in einer zentralen Steuerungsebene verwaltet werden. Für Plattformingenieure, Site Reliability Engineers (SREs) und DevOps-Teams, die mit der wachsenden Komplexität moderner Kubernetes-Ökosysteme kämpfen, bietet Koreo einen frischen Ansatz, um Automatisierung sicherer, nachvollziehbarer und wartbarer zu gestalten. Die Möglichkeit, Plattformlogik als getesteten Code zu verwalten, verkürzt Feedbackzyklen und minimiert Ausfallrisiken erheblich.

In einer Welt, in der immer mehr Unternehmen ihre Infrastruktur und internen Plattformen als Software betrachten, stellt Koreo ein zukunftsweisendes Werkzeug dar, das die Brücke zwischen Infrastrukturmanagement und moderner Softwareentwicklung schlägt. Mit seinem ganzheitlichen Ansatz ist es bestens gerüstet, um auf dem dynamischen Feld von Kubernetes-gestützten Plattformen erfolgreich zu bestehen. Die Entwicklung von Koreo ist noch jung, aber das Potenzial, das sich hinter dem Toolkit verbirgt, zeigt deutlich, wie wichtig ein durchdachtes Platform Engineering für die Zukunft der Cloud-nativen Welt ist.

![The All-New Whoop Experience [video]](/images/FDE973EC-17BB-42C5-84D2-FC70DE785274)