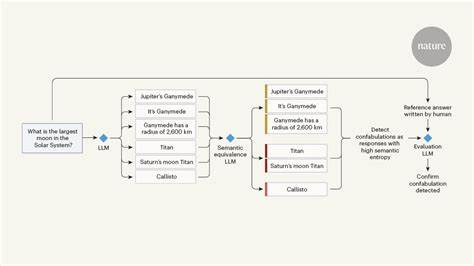

In der heutigen Welt sind große Sprachmodelle, sogenannte LLMs (Large Language Models), allgegenwärtig geworden. Sie revolutionieren, wie wir Informationen erzeugen, verarbeiten und konsumieren. Doch mit ihrem zunehmenden Einsatz steigt auch die Menge an KI-generierten Inhalten, die teils wertvolle Informationen, teils aber auch irrelevantes oder falsches Material enthalten. Das Ziel, gute von schlechten Inhalten zu unterscheiden, wird somit komplexer, was viele Nutzer vor große Herausforderungen stellt. Die spannende Frage lautet daher: Wie kann man LLMs verwenden, um die Auswirkungen anderer LLMs zu kontrollieren oder zu bekämpfen? Die Antwort liegt in der kreativen Nutzung von LLMs selbst, um durch Zusammenfassung, Filterung und Veredelung einen Mehrwert zu schaffen.

Das bedeutet, dass Künstliche Intelligenzen eingesetzt werden, um die Unmengen an KI-erstellten Daten zu strukturieren und die Informationsqualität zu erhöhen. Diese Vorgehensweise bietet eine neue Perspektive im Umgang mit der Informationsflut im digitalen Zeitalter. Anders ausgedrückt: LLMs helfen uns, die Flut an LLM-Texten zu bewältigen, indem sie selbst als Werkzeuge zur Inhaltsverdichtung und -analyse dienen. Dies eröffnet völlig neue Möglichkeiten für Forschung, Medienarbeit und den Alltag jedes Nutzers, der mit Texten verschiedenster Herkunft konfrontiert wird. Ein wesentlicher Aspekt bei diesem Ansatz ist die Verwendung spezialisierter Werkzeuge, die den Prozess von der Erfassung bis zur Aufbereitung der Daten vereinfachen und automatisieren.

Ein Beispiel dafür ist die Nutzung von Web-Scrapern, die Webseiteninhalte gezielt extrahieren und in ein aggregiertes Format bringen. Dieses Rohmaterial kann dann von LLMs analysiert und zusammengefasst werden, ohne dass der Anwender mühselig den gesamten Text lesen muss. Daraus ergibt sich eine effektive Zeiteinsparung und eine bessere Verständlichkeit komplexer Sachverhalte, was vor allem in Informationsberufen und bei Viel-Lesern sehr geschätzt wird. Ein bekanntes Tool für die Extraktion von Webinhalten ist Firecrawl, das in der Lage ist, relevante Texte aus Online-Artikeln in einem sauberen, maschinenlesbaren Format bereitzustellen. Es reduziert den Aufwand, mehrere Quellen manuell aufzugreifen, und bietet eine Schnittstelle, die von anderen Programmen, insbesondere LLMs, leicht genutzt werden kann.

Durch die Kombination von Firecrawl und einer flexiblen Kommandozeilen-Lösung namens llm-cli entsteht eine Pipeline, mit der Benutzer Modelle verschiedenster Anbieter bequem steuern und Textanalysen durchführen können. Dies hat den weiteren Vorteil, dass man nicht auf einen einzelnen Anbieter oder deren spezifische Infrastruktur angewiesen ist. Die Selbsthostung von Tools bringt zudem mehr Unabhängigkeit und Sicherheit im Umgang mit sensiblen Daten. Orbstack ist eine moderne Plattform, die es erlaubt, Dienste wie Firecrawl in einer isolierten Umgebung zu betreiben und dabei DNS-Management elegant zu automatisieren. Ein solches Ökosystem ermöglicht es, selbst komplexe Prozesse aus mehreren Arbeitsschritten automatisiert auszuführen, die im Hintergrund dafür sorgen, dass die gewünschten Ausgaben prompt und zuverlässig erzeugt werden.

Die Automatisierung erfolgt häufig über shell-basierte Skripte oder -funktionen, die sich je nach Nutzerwunsch individuell anpassen lassen. So wird ein konsistenter Workflow geschaffen, der sowohl Flexibilität bietet als auch Wiederholbarkeit gewährleistet. Ein praktisches Szenario zeigt sich beim Zusammenfassen langer Texte oder umfangreicher Webartikel. Statt mühselig den gesamten Inhalt durchzuarbeiten, überlässt der Nutzer die Extraktion und das Verdichten den Werkzeugen. Das Ergebnis ist eine prägnante Zusammenfassung, die gleichzeitig die Kernaussagen widerspiegelt und irrelevante Details ausblendet.

Diese Zusammenfassung kann in Markdown ausgegeben und visuell ansprechend dargestellt werden, was besonders in der Dokumentation und Berichterstattung von Vorteil ist. Diese neue Art des Umgangs mit sprachbasierten KI-Modellen bedeutet eine große Erleichterung im Alltag. Nutzer können sich auf die Essenz einer Information fokussieren und sparen wertvolle Zeit. Zudem hilft die höhere Signalqualität dabei, Informationsüberflutung zu vermeiden und Entscheidungen auf einer soliden Basis zu treffen. Die Entwicklung dieser Arbeitsweise spiegelt auch einen wichtigen gesellschaftlichen Trend wider: Die Notwendigkeit, Tools zu entwickeln, die intelligente Inhalte generieren und gleichzeitig die Qualität kontrollieren und sicherstellen.

Ohne solche Werkzeuge besteht die Gefahr, dass die Flut digitaler Inhalte Menschen überfordert oder sie mit Fehlinformationen in die Irre führt. Somit wird der Kampf gegen schlechte oder unübersichtliche KI-generierte Inhalte unter Zuhilfenahme anderer KI-Modelle zu einer Aufgabe von großer Bedeutung. Unternehmen, Redaktionen und Wissenschaftseinrichtungen entdecken immer mehr die Vorteile dieses Ansatzes. Durch den Einsatz von LLMs als Helfer und Wächter werden Prozesse effizienter, transparenter und vertrauenswürdiger. Das wirkt sich nicht nur positiv auf die Qualität der erzeugten Inhalte aus, sondern auch auf die Akzeptanz von KI-Systemen in der Gesellschaft.

Trotz aller Fortschritte gibt es jedoch Herausforderungen und offene Fragen. Beispielsweise müssen Mechanismen gefunden werden, die die Zusammenfassung vor Verzerrungen schützen und sicherstellen, dass keine wesentlichen Aussagen verloren gehen. Die Qualität der Ausgangsdaten spielt dabei eine entscheidende Rolle, ebenso wie die korrekte Konfiguration und Auswahl der eingesetzten Modelle. Ein weiterer Punkt ist die Skalierbarkeit der Systeme. Wenn die Menge an Online-Inhalten weiterhin exponentiell wächst, müssen die Arbeitsabläufe und die verwendeten Werkzeuge entsprechend robust und schnell bleiben, um effektiv zu funktionieren.

Die Integration von Künstlicher Intelligenz in den Prozess des Lesens, Filternns und Verstehens digitaler Informationen zeigt auch die zunehmende Symbiose zwischen Mensch und Maschine. Künstliche Intelligenz unterstützt dabei, an Informationsflut zu managen und gibt den Nutzern so die Kraft zurück, fundierte und schnelle Entscheidungen zu treffen. Dies ist besonders in dynamischen Branchen von enormer Bedeutung, wo Wissen und Reaktionsfähigkeit über Erfolg oder Misserfolg entscheiden können. Nicht zuletzt steht auch der ethische Aspekt im Fokus. Der Einsatz von LLMs zum Bekämpfen von LLM-generierten Inhalten muss verantwortungsvoll gestaltet werden.

Dazu gehört Transparenz über die verwendeten Modelle, Schutz der Privatsphäre und Sicherheit der Daten sowie eine Überwachung, die Missbrauch und Manipulation verhindert. Fachleute arbeiten kontinuierlich daran, solche Standards und Rahmenbedingungen zu entwickeln, um den größtmöglichen Nutzen bei minimalen Risiken zu erzielen. Die Kombination aus Web-Scraping, leistungsfähigen Sprachmodellen und benutzerfreundlichen Schnittstellen eröffnet ein enormes Potential in vielen Anwendungsgebieten. Ob in der Forschung, im Journalismus, in der Unternehmenskommunikation oder im privaten Alltag – die Fähigkeit, Informationsflüsse intelligent zu kanalisieren und auf das Wesentliche zu reduzieren, wird zum entscheidenden Erfolgsfaktor. Zusammenfassend lässt sich sagen, dass der Einsatz von LLMs, um die von LLMs erzeugten Inhalte besser zu bewältigen, eine innovative und zukunftsweisende Strategie darstellt.

Sie hilft, den Kern von Informationen effizient zu extrahieren und die Qualität der digitalen Kommunikation nachhaltig zu verbessern. Indem man künstliche Intelligenz zur Bekämpfung der Herausforderungen einsetzt, die durch künstliche Intelligenz entstehen, entsteht ein vielversprechender Kreislauf der Optimierung, der für die kommenden Jahre und Jahrzehnte wichtig sein wird. Letztendlich ist die Fähigkeit, zwischen Signal und Rauschen zu unterscheiden, eine zentrale Voraussetzung für den erfolgreichen Umgang mit der digitalen Wissensexplosion – und LLMs sind dabei ein unverzichtbares Werkzeug. Durch konsequente Weiterentwicklung dieses Ansatzes wird es möglich sein, eine Informationswelt zu gestalten, die nicht nur umfangreich, sondern auch verständlich und vertrauenswürdig ist.