Die rasante Entwicklung großer Sprachmodelle (Large Language Models, LLMs) hat in den letzten Jahren sowohl technologische als auch wirtschaftliche Dynamiken in der Künstlichen Intelligenz grundlegend verändert. Doch während die Diskussion oft auf Leistungsfähigkeit, Genauigkeit und Anwendungsbereiche fokussiert, bleiben die finanziellen Aspekte der Inferenz oft im Verborgenen. Die Kostenstruktur bei der Nutzung von LLMs ist entscheidend, um die Profitabilität von Anbietern zu verstehen sowie die Zugänglichkeit solcher Technologie für Endnutzer einzuschätzen. Ein Blick auf die ökonomischen Grundlagen der LLM-Inferenz erlaubt es, die Mechanismen hinter Preisgestaltung, Skalierung und Effizienz zu durchdringen – und dadurch auch die Zukunft der KI-Nutzung wirtschaftlich zu erahnen. Im Kern lautet die zentrale Frage: Wie setzen sich die Kosten für das Generieren eines einzelnen Tokens bei großen Sprachmodellen zusammen und welche Faktoren beeinflussen diese Kosten maßgeblich? Die Antwort hierauf beginnt mit der Erkenntnis, dass die primären Kosten für LLM-Inferenz aus der benötigten Rechenleistung resultieren.

Um Token zu generieren, sind spezialisierte Grafikkarten (GPUs) unverzichtbar, welche entsprechend Energie, Hardware und Infrastruktur benötigen. Jeder GPU ist mit einer festen stündlichen Betriebskosten verbunden. Die Anzahl der Tokens, die eine GPU pro Stunde produzieren kann, wird somit zum Schlüsselkriterium, denn daraus ergibt sich der Preis pro generiertem Token. Grundsätzlich werden LLMs wie Llama 3.3 mit rund 70 Milliarden Parametern als Rechenbeispiele angeführt, da sie eine Balance zwischen realitätsnaher Komplexität und Handhabbarkeit bieten.

Mit ihren Milliarden von Parametern speichern diese Modelle ihr „Wissen“ in gewichteten Netzwerken, die mehr Speicher sowie Rechenleistung benötigen – je größer das Modell, desto höher die Anforderungen an die Hardware. Ein großes Problem ergibt sich hierbei aus dem Speicherbedarf der Modelle. Beispielsweise benötigt Llama 3.3 70B etwa 141 GB Speicher allein für die Modellgewichte, während die verbreiteten Datenzentrum-GPUs eine VRAM-Kapazität von 80 GB besitzen. Daher wird die Modellinferenz praktisch auf vielen GPUs parallel durchgeführt, um den Speicherbedarf zu decken, was wiederum Kommunikationsaufwände zwischen den GPUs erzeugt.

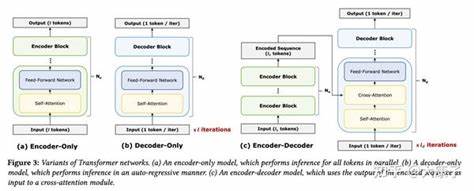

Neben der reinen Speichergröße ist die Fähigkeit zu blitzschnellen Operationen auf Gleitkommazahlen (gemessen in FLOPS) sowie der Datentransfer zwischen Speicher und Prozessor (Memory Bandwidth) entscheidend. Modernste GPUs erreichen Teraflops an Rechenleistung sowie mehrere Terabyte pro Sekunde an Speicherbandbreite. Für die LLM-Inferenz ist ein entscheidendes Konzept die „arithmetische Intensität“, die das Verhältnis zwischen Rechenoperationen und Speicherzugriffen beschreibt. Modelle mit hoher arithmetischer Intensität nutzen die GPU-Compute-Ressourcen effektiver, während Modelle mit niedriger Intensität durch Speicherzugriffe limitiert sind. Interessanterweise weist die Inferenz von LLMs zwei deutlich unterschiedliche Phasen auf: die sogenannte Prefill-Phase und die Token-by-Token-Phase.

Während der Prefill-Phase wird der Input-Prompt als Ganzes verarbeitet und es entsteht der initiale Kontext. Diese Phase ist stark rechenlastig, da fürs gesamte Inputfeld viele Matrixmultiplikationen und Transformationen nötig sind. Demgegenüber steht die Token-by-Token-Phase, in der schrittweise jeder neue Token basierend auf dem bisherigen Kontext generiert wird. Diese Phase ist hingegen hauptsächlich durch Speicherbandbreite limitiert – das heißt, die Daten müssen schnell vom Speicher zur GPU transportiert werden, der Rechenaufwand ist jedoch relativ gering. Um die Effizienz in der Token-by-Token-Phase zu verbessern, wird oft ein sogenannter „KV-Cache“ verwendet, der Zwischenergebnisse speichert um redundante Berechnungen zu vermeiden.

Der KV-Cache beansprucht Speicherplatz proportional der Kontextlänge und Batch-Größe, was insbesondere bei langen Sequenzen oder großen Batches zu hohen Speicheranforderungen führt. Mit steigenden Kontextlängen wachsen sowohl der Rechenaufwand in der Prefill-Phase quadratisch als auch Speicherbedarf im Token-by-Token-Stadium linear – das hat einen direkten Einfluss auf Latenz und Kosten. Ein weiterer zentraler Faktor für die Ökonomie der LLM-Inferenz ist die Batch-Größe. Durch parallele Verarbeitung mehrerer Anfragen können die fixe Kosten für das Laden der Modellgewichte auf mehrere Anfragen verteilt werden. Große Batches wirken sich daher positiv auf die Tokenproduktionsrate und somit auf die Kosten pro Token aus.

Im professionellen Umfeld werden meist Tensor-Parallelismus oder Pipeline-Parallelismus eingesetzt, um mit mehreren GPUs eine einzelne Instanz eines Modells effizient zu betreiben. Während der Pipeline-Parallelismus weniger Synchronisationskommunikation erfordert, bietet Tensor-Parallelismus bessere Latenzzeiten, hat dafür aber Regressionen bei Konkurrierenden Workloads. Im realen Betrieb ist die theoretische maximale Leistung einer GPU selten erreichbar. Faktoren wie Synchronisationsaufwand, nicht ideale Speicherzugriffsmuster und Overheads durch Software-Frameworks verringern die Effektivität oft deutlich. Deshalb fällt die reale Token-durchsatzrate unter die Schätzung gemäß Theorie.

Bei der Preisgestaltung von LLM-APIs berücksichtigt man meist sowohl die Gestaltung der Benutzerinteraktion als auch die Compute- und Memory-Kosten. Dabei sind Input-Token oft günstiger als Output-Token, weil bei ersteren nur der Prefill rechenintensiv ist, wohingegen Output-Token fortlaufend generiert werden. Der Kostenaufwand für Eingabe- und Ausgabe-Tokens ist allerdings kein fester Wert, sondern hängt von Batch-Größe, Kontextlänge und Modell ab. Zusammenfassend lässt sich sagen, dass der Schlüssel zur wirtschaftlichen und preislich attraktiven Inferenz in der Kombination aus effizienten parallelen Methoden, ausreichend großer Batch-Verarbeitung und dem gezielten Management von Kontextlängen liegt. Nur mit ausreichend hoher Auslastung einer GPU kann der Betreiber die hohen Fixkosten der Hardware durch tokenbezogene Einnahmen decken.

Für Nutzer hingegen bedeutet dies, dass besonders bei kleineren Anfragen oder geringen Abfragen die Kosten pro Token deutlich höher sein können. Diese Erkenntnis ist wesentlich, wenn man den Einsatz von LLMs etwa in SaaS-Produkten, Chatbots oder großskaligen KI-Anwendungen plant. Schließlich zeigt auch der Vergleich populärer Hardware: Große Speichergröße allein reicht nicht aus. Die Speicherbandbreite ist oft der entscheidende Flaschenhals bei der Interaktion mit LLMs. GPUs wie Nvidia H100 zeichnen sich nicht nur durch viel VRAM, sondern auch überdurchschnittlich hohe Speicherbandbreite aus, was schnelle Token-Generierung ermöglicht.

Demgegenüber können zwar Systeme mit sehr großem, aber langsamerem Speicher (wie bestimmte Apple-Chips oder andere Consumer-Hardware) die Modelle zwar speichern, jedoch liegen die Tokenproduktionsraten weit unter den professionellen Lösungen. Das macht Edge-Anwendungen mit großen LLMs aktuell wirtschaftlich noch wenig attraktiv. Ohne die Möglichkeit, Batches zu bündeln und den Bedarf an schnellem Speicher zu decken, steigen Stromkosten und Hardware-Abschreibungen pro Token signifikant an. Durch das Verständnis der grundlegenden Architektur von LLMs, der Hardwarebeschränkungen und der Phasen der Inferenz lassen sich Businessmodelle, Kostenschätzungen und technische Implementierungen besser planen. Künftige Entwicklungen in Quantisierung, Speichereffizienz und innovativen Verfahren könnten diese Erkenntnisse noch weiter verschieben und die Nutzung von LLMs noch zugänglicher und günstiger machen.

Grundlegende ökonomische Prinzipien bleiben dabei jedoch zentral, um echte Fortschritte in der Skalierung und Kostensenkung zu realisieren. So wird deutlich, dass wirtschaftliche Effizienz Hand in Hand mit technologischem Fortschritt geht – und ein tiefes Verständnis der LLM-Inferenzökonomie eine wichtige Voraussetzung bildet, um das volle Potenzial großer Sprachmodelle nachhaltig und profitabel zu heben.