Im digitalen Zeitalter nimmt die Geschwindigkeit, mit der Daten verarbeitet und übertragen werden, eine zentrale Rolle ein. Ein Begriff, der in diesem Zusammenhang immer häufiger auftaucht, ist der „Cursor“, insbesondere wenn es um Datenbanken und API-Anfragen geht. Ein Phänomen, das viele Entwickler und Nutzer beschäftigt, ist das absichtliche Verlangsamen langsamer, nicht performanter Anfragen durch Cursors. Doch warum wird das gemacht, welche Auswirkungen hat es und wie kann man damit umgehen? Diese Fragen sollen im Folgenden ausführlich beantwortet werden. Cursor sind eine Technik, die vor allem in der Datenbankverwaltung und bei der Verarbeitung großer Datenmengen zum Einsatz kommt.

Sie ermöglichen es, durch Ergebnisdatensätze zu navigieren und Teilmengen von Daten abzurufen, ohne die gesamte Datenmenge auf einmal zu laden. In der Praxis bedeutet dies, dass eine Anwendung beispielsweise 50 Datensätze auf einmal anzeigt und den Cursor nutzt, um beim nächsten Abruf weitere Datensätze zu laden. Das macht den Datenverkehr effizienter und reduziert die Belastung von Servern und Netzwerken. Allerdings besteht bei „langsameren“ oder „nicht schnellen“ Anfragen das Risiko, dass durch ineffiziente Abfragen oder fehlende Optimierungen die Serverressourcen übermäßig beansprucht werden. Insbesondere bei APIs, die durch eine große Anzahl von Anfragen belastet werden, greifen Betreiber häufig auf mechanische Maßnahmen zurück, um das System zu schützen.

Eine solche Maßnahme ist das absichtliche Verlangsamen von Anfragen, die als weniger performant oder „nicht schnell“ erkannt werden. Das Ziel dahinter ist sowohl Schutz vor Überlastungen als auch Förderung einer fairen Nutzung der Ressourcen. Das bedeutet, der Cursor verlangsamt gezielt bestimmte Anfragen oder sorgt für eine künstliche Verzögerung bei langsamen Abfragen, um die Last gleichmäßiger zu verteilen. Dies kann sich im Endeffekt darin äußern, dass beim Abruf von Daten einzelne Schritte länger dauern, oder dass eine Folge von Datenzugriffen nicht in der gewohnten Geschwindigkeit erfolgt. Für Entwickler kann dies frustrierend sein, vor allem wenn optimale Performance erwartet wird.

Warum aber werden nicht einfach alle Anfragen gleich behandelt? Der Grund liegt in der Balance zwischen Nutzererfahrung und Systemstabilität. Schnelle und effiziente Anfragen können problemlos in Echtzeit beantwortet werden, da sie die Ressourcen schonen und systemkonform ablaufen. Lange und ineffiziente Anfragen oder solche, die zu viele Daten auf einmal abfragen, können das System überlasten. Durch eine gezielte Verlangsamung können Betreiber einerseits eine Überlastung verhindern und andererseits einen fairen Zugang zu den Daten sicherstellen. Unterschiedliche Plattformen und Serviceanbieter haben jeweils eigene Algorithmen und Richtlinien, wie sie mit langsamen Anfragen umgehen.

Manche Systeme melden direkt eine Fehlermeldung, etwa eine Rate-Limit-Überschreitung, während andere wie etwa Reddit oder Twitter einen Mechanismus einsetzen, der die Antwortzeiten absichtlich verlängert und dadurch indirekt eine Drosselung bewirkt. Gerade bei öffentlichen APIs wird oft empfohlen, sogenannte „Cursor-basierte Pagination“ zu verwenden, um Anfragen effizient zu gestalten und keine unnötigen Belastungen zu erzeugen. Ein weiterer wichtiger Punkt ist die Identifikation der Anfragen als „langsam“ oder „nicht schnell“. Dies geschieht oft anhand von Metriken wie Antwortzeit, Datenmenge pro Anfrage, Anzahl der Anfragen pro Zeitspanne oder Komplexität der Abfragen. Werden hohe Grenzwerte überschritten, greift die Verlangsamung.

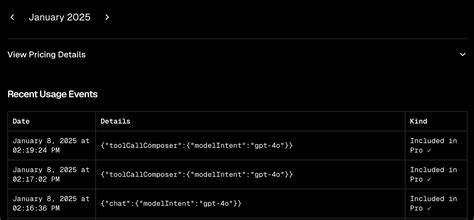

Manche Systeme verlangen auch, dass Nutzer sich authentifizieren oder entwickeln individuelle Rate-Limits für verschiedene Nutzergruppen. Wie lässt sich also verhindern, dass der Cursor Anfragen absichtlich verlangsamt? Zunächst ist es ratsam, die eigenen Abfragen zu optimieren. Statt große Datenstücke auf einmal abzurufen, sollte man kleinere, gezielte Anfragen stellen und möglichst die von der Plattform empfohlenen Paginierungsmechanismen nutzen. Auch das Einhalten von Rate-Limits hilft dabei, nicht in den Bereich langsamer Anfragen zu geraten. Zusätzlich ist es wichtig, den User-Agent klar und aussagekräftig zu gestalten, vor allem bei API-Anfragen.

Systeme wie Reddit blockieren oder verlangsamen Anfragen mit fehlendem oder verdächtigem User-Agent string, weil dies auf potenzielle Bots oder automatisierten Zugriff hinweist. Die Registrierung als Entwickler und die Nutzung offizieller Zugangsdaten können ebenfalls dazu beitragen, bevorzugt behandelt zu werden. Darüber hinaus kann ein steter Dialog mit dem Plattformbetreiber hilfreich sein, falls man das Gefühl hat, zu Unrecht verlangsamt oder blockiert zu werden. Manche Plattformen bieten Support- oder Ticket-Systeme an, um solche Probleme schneller zu lösen und optimale Zugriffsrechte zu gewähren. Die zunehmende Bedeutung von Datenschutz und Netzwerksicherheit spielt ebenfalls eine Rolle.

Betreiber möchten verhindern, dass unkontrollierte Massenabfragen sensible Daten gefährden oder Serverressourcen für böswillige Zwecke genutzt werden. Die Verlangsamung langsamer Anfragen wird somit auch als ein Schutzmechanismus gesehen. Aus Entwicklersicht ist es sinnvoll, sich mit der Dokumentation der jeweiligen Plattform auseinanderzusetzen, um alle Anforderungen genau zu kennen. Konzepte wie asynchrone Verarbeitung, effiziente Indexierung und saubere Pagination tragen dazu bei, dass Anfragen performant bleiben und keiner Verlangsamung unterliegen. Abschließend lässt sich sagen, dass die absichtliche Verlangsamung von langsamen Anfragen durch Cursors ein wichtiges Instrument zur Sicherstellung der Systemstabilität und Fairness im Internet darstellt.

Sie ist als Teil umfassender Netzwerk- und Ressourcenmanagement-Strategien zu verstehen und kann durch gezielte Optimierung der Abfragen, Authentifizierung und gute Programmierpraktiken vermieden oder reduziert werden. So bleibt die Nutzung von Datenquellen effizient und zuverlässig, selbst bei hoher Nachfrage und komplexen Anwendungen.