In einer Ära, in der Daten als das neue Gold gehandelt werden, gewinnt die Art und Weise, wie Unternehmen Informationen sammeln, speichern und analysieren, immer größere Bedeutung. Die meisten Organisationen sind heutzutage mit der Verwaltung enormer Datenmengen vertraut – von Kundeninteraktionen über Verkaufszahlen bis hin zu Nutzungsstatistiken und Kommunikationsverläufen. Dennoch stellen sich immer häufiger Fragen nach der Effektivität der bisherigen Dateninfrastrukturen. Sind traditionelle Datenbanken und gängige Analysesysteme noch zeitgemäß? Oder steuern wir auf den Bedarf eines neuen Paradigmas in der Datenverarbeitung zu? Die wertvolle Rolle der Datenbanken in der Vergangenheit ist unbestritten. Sie erlauben zentrale Speicherung, schnelle Abfragen und die Verarbeitung großer Datensätze, was in der digitalen Wirtschaft maßgeblich zur Entscheidungsfindung beiträgt.

Moderne Cloud-Datenbanklösungen wie Databricks oder Snowflake haben den Markt geprägt, indem sie Skalierbarkeit, Performanz und Benutzerfreundlichkeit vereinfachen. Doch während diese Technologien technisch beeindruckend sind und das Speichern und Abrufen von Daten erleichtern, zeigen sich zunehmend Lücken in ihrem praktischen Nutzen für viele Unternehmen. Eine der bedeutendsten Herausforderungen liegt in der Qualität und der Nützlichkeit der Daten selbst. Viele Firmen sammeln zwar umfangreiche Informationen, doch der wahre Wert steckt im Kontext und in der Relevanz dieser Daten. Quantitative Daten, wie Klickzahlen oder Verkaufsstatistiken, sind oft nur ein Abbild und nicht das vollständige Abbild der komplexen Realität und Kundenintentionen.

Viele analytische Bemühungen scheitern daran, aussagekräftige Erkenntnisse zu gewinnen, die direkt zu besseren Geschäftsergebnissen führen. Die erhoffte Revolution hin zu datengetriebenen Organisationen entpuppt sich in vielen Fällen nicht als durchgängig wirksam, sondern bleibt fragmentiert oder führt zu enttäuschenden Ergebnissen. Die Schwierigkeit, aus Daten belastbare Antworten auf komplexe Geschäftsfragen zu erhalten, liegt oft daran, dass zugrundeliegende Probleme oder Erfolgsmuster nicht direkt in den strukturierten Zahlen ablesbar sind. Es ist häufig ein indirekter Weg, der über Proxy-Metriken oder Annahmen führt und dabei anfällig für Verzerrungen und Interpretationsfehler bleibt. Zudem variieren die Datenquellen stark und sind nicht immer konsistent oder vollständig.

Unternehmen können mit den besten Analysetools und hochqualifizierten Teams arbeiten, doch ohne die passenden Daten mit ausreichend Aussagekraft bleibt ihr Potenzial begrenzt. Parallel zu den Weiterentwicklungen in der Datenbanktechnologie beobachten wir eine zunehmende Bedeutung unstrukturierter Daten. Mitarbeitergespräche, E-Mails, Meeting-Notizen und andere Dokumente enthalten oft Einblicke, die klassischen Datenbanken verborgen bleiben. Die Herausforderung lag lange darin, diese Informationen zugänglich, durchsuchbar und analysierbar zu machen. Doch mit dem Aufkommen leistungsfähiger Sprachmodelle und KI-gesteuerter Systeme wie Granola oder Notion AI wird erstmals möglich, unstrukturierte Daten in neuer Qualität zu nutzen.

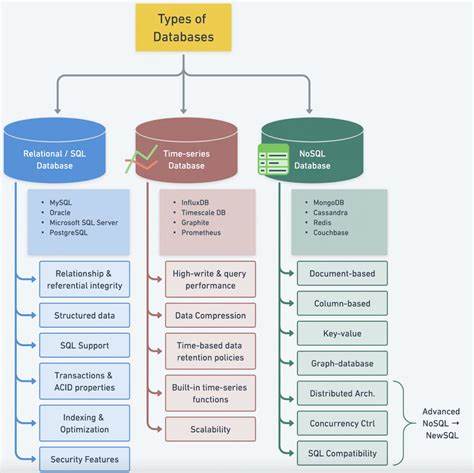

Diese Technologien transformieren Textinformationen in durchsuchbare Wissensquellen, die direkt abgefragt und interpretiert werden können, ähnlich wie bei klassischen Datenbankabfragen. Diese Verschiebung bedeutet, dass die Rolle der Datenbanken neu gedacht werden muss. Nicht nur numerische Tabellen und relationale Strukturen stehen im Fokus, sondern auch semantische Zusammenhänge, Kontextinformationen und dokumentbasierte Datenquellen werden essentiell. Das bisherige Modell eines Datenbanksystems als reine Speicherung und Abfrageplattform genügt zunehmend nicht mehr. Stattdessen sind hybride Systeme gefragt, die sowohl Tabellen als auch Texte, Gespräche und Bilder verarbeiten und miteinander vernetzen können.

Dabei gewinnen Techniken wie semantische Suche und KI-gestützte Verknüpfungen an Bedeutung, um Datenquellen intelligent zu analysieren. Die Integration von großen Sprachmodellen bietet weitere Potenziale: Sie können Informationen aus verschiedenen Datentöpfen zusammenführen, Muster erkennen und Fragen in natürlicher Sprache beantworten. Das ermöglicht eine neue Art von Dateninteraktion, die nicht länger auf komplexen SQL-Abfragen oder manueller Datenvorbereitung beruht. In der Praxis könnte dies bedeuten, dass Unternehmen ihre Marktentwicklungen oder internen Prozesse besser verstehen, indem sie beispielsweise Gesprächsnotizen, Verkaufszahlen und Kundenfeedback automatisch miteinander in Beziehung setzen. Trotz dieser vielversprechenden Entwicklungen gibt es auch Skepsis und Herausforderungen.

Nicht alle Antworten, die KIs liefern, sind automatisch korrekt oder aussagekräftig. Zusätzlich besteht das Risiko, sich zu sehr auf Technologielösungen zu verlassen, ohne das unternehmensstrategische Wissen und die menschliche Interpretation ausreichend einzubeziehen. Die richtigen Fragen zu stellen bleibt essentiell, denn KI-gestützte Systeme können nur auf den Input reagieren, der ihnen gegeben wird. Dazu kommt, dass viele Unternehmen noch nicht bereit sind, ihre Dateninfrastrukturen grundlegend umzubauen. Die etablierten Datenbanken bieten nach wie vor solide Leistungen für viele Anwendungsfälle, insbesondere bei mechanischem Reporting oder klassischen Business-Intelligence-Anwendungen.

Es ist also auch nicht von heute auf morgen notwendig, komplette Systeme zu ersetzen, sondern vielmehr eine evolutionäre Entwicklung hin zu hybriden Plattformen sinnvoll. Diese hybriden Plattformen bedienen die Bedürfnisse der Zukunft, in der strukturierte und unstrukturierte Daten verschmelzen. Sie ermöglichen Analysemöglichkeiten, die über den reinen Zahlenvergleich hinausgehen, und erleichtern den Zugang zu wertvollen Einsichten, die bisher verborgen blieben. Analysten und Entscheidungsträger profitieren von einer intuitiveren Datenlandschaft, die durch natürliche Sprache und KI-Erkenntnisse ergänzt wird. Gleichzeitig entstehen neue Herausforderungen für die Datenarchitektur, die Sicherheitsaspekte, Datenschutz und Skalierbarkeit abdeckt.

Im Kontext der Digitalisierung und des wachsenden Wettbewerbsdrucks wird die Beherrschung von Daten immer mehr zum entscheidenden Wettbewerbsvorteil. Unternehmen, die frühzeitig auf moderne Ansätze setzen, können nicht nur effizienter arbeiten, sondern auch schneller innovative Produkte und Services anbieten. Die Frage, ob wir eine neue Datenbank brauchen, sollte daher nicht nur technisch beantwortet werden, sondern auch strategisch und kulturell: Wie gestaltet sich die Beziehung zwischen Menschen, Daten und Technologien in der modernen Arbeitswelt? Letztlich zeigt sich, dass die Zukunft der Datenverarbeitung nicht allein in der Weiterentwicklung traditioneller Datenbanktechnologie liegt, sondern in der Kombination von vielfältigen Datenquellen, intelligenten Analyseverfahren und einer offenen Architektur. Es gilt, Daten nicht nur als isolierte Informationsfragmente, sondern als lebendige Wissenslandschaften zu begreifen. In diesem Sinne ist die Vorstellung einer neuen Datenbank eher eine Vision eines umfassenden, KI-integrierten Informations-Ökosystems, das den Bedürfnissen komplexer, digitaler Unternehmen gerecht wird.

Mit dem Fortschritt künstlicher Intelligenz, der Entwicklung leistungsfähiger Sprachmodelle und der Integration unstrukturierter Daten wandelt sich das Bild von Datenbanken grundlegend. Die Grenzen zwischen klassischen Datenbanken, Dokumentenspeichern, Kommunikationstools und Analyseplattformen verschwimmen zunehmend. Unternehmen sollten diese Entwicklung aufmerksam verfolgen und offen für neue Modelle sein, in denen Daten nicht nur gespeichert, sondern intelligent verstanden und genutzt werden. Daten sind zweifellos der Rohstoff der heutigen Wirtschaft, aber ihr Potenzial voll auszuschöpfen erfordert mehr als nur mächtige Datenbanken. Es braucht eine neue Denkweise, die den Menschen, den Kontext und die Technologie gleichermaßen berücksichtigt.

Ob die Zukunft nun von einer neuen Generation von Datenbanken geprägt ist oder von einem komplett anderen Konzept, ist noch offen. Klar ist jedoch, dass das Zeitalter der einfachen Tabellen und starren Datenmodelle einer neuen Ära Platz machen muss – einer Ära, in der Daten lebendig, flexibel und unmittelbar nutzbar sind.