Kubernetes hat sich in den letzten Jahren als eine der wichtigsten Plattformen für die Verwaltung von containerisierten Anwendungen etabliert. Als zweitgrößtes Open-Source-Projekt weltweit hat Kubernetes nicht nur die Art und Weise verändert, wie Unternehmen ihre Infrastruktur verwalten, sondern auch eine lebendige Entwickler-Community geschaffen, die kontinuierlich an der Weiterentwicklung arbeitet. Doch wie ist Kubernetes eigentlich aufgebaut? Welche architektonischen Prinzipien stecken dahinter und warum gilt es als Erfolgsprojekt in der Cloud Native Landschaft? Die Entstehung von Kubernetes beginnt bei Google, genauer gesagt bei deren intern eingesetztem System Borg. Borg wurde ursprünglich entwickelt, um die enorm komplexe Verwaltung von zehntausenden bis Millionen von Maschinen in Googles Rechenzentren zu ermöglichen. Die Herausforderungen, die Google hier zu bewältigen hatte, führten zur Konzeption einer effizienten und skalierbaren Orchestrierungsplattform.

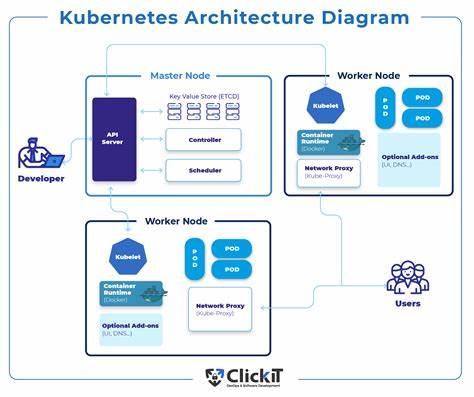

Kubernetes basiert direkt auf den Erkenntnissen aus Borg und wurde von Google als Open-Source-Projekt der Cloud Native Computing Foundation (CNCF) übergeben, um eine breite Akzeptanz und Weiterentwicklung zu ermöglichen. Die Architektur von Kubernetes ist modular und stark auf Skalierbarkeit ausgelegt. Im Kern besteht Kubernetes aus mehreren Schlüsselkomponenten, die zusammenarbeiten, um Container in sogenannten Pods zu verwalten. Ein Pod ist die kleinste deploybare Einheit und kann einen oder mehrere Container zusammenfassen, die Ressourcen teilen und gemeinsam auf einem Node laufen. Die Nodes sind die Rechenressourcen, auf denen die Container letztendlich ausgeführt werden.

Auf jedem Node läuft ein Agent namens Kubelet, der die direkte Steuerung, Überwachung und Kommunikation mit dem Kubernetes-Master sicherstellt. Der Kubernetes-Master ist das zentrale Steuerungselement und besteht aus verschiedenen Komponenten wie dem API-Server, Scheduler und Controller-Manager. Diese sorgen gemeinsam dafür, dass der gewünschte Zustand des Systems umgesetzt wird, zum Beispiel dass genügend Instanzen einer Anwendung laufen oder dass Ressourcen optimal zugeteilt werden. Kommuniziert wird im Cluster vor allem über den API-Server, der als Schnittstelle für Administratoren und Automatisierungstools dient. Kubernetes ist wesentlich mehr als nur ein technisches Werkzeug; es stellt ein gut organisiertes und strukturiertes Open-Source-Projekt dar.

Es gibt zahlreiche SIGs (Special Interest Groups), die verschiedene Aspekte des Projekts betreuen, von Sicherheit über Netzwerk bis hin zu Storage. Die Release-Zyklen sind strikt durchdacht und laufen in der Regel alle 14 bis 16 Wochen ab. Dabei gibt es ein ausgeklügeltes System für die Verantwortlichen im Release-Team, das sogenannte Lead- und Shadow-Konzept. Dieses Konzept erlaubt es auch neuen Mitgliedern, sich aktiv einzubringen, indem sie als Schatten („Shadow“) einem erfahrenen Lead über die Schulter schauen und so mittelfristig selbst Leitungsfunktionen übernehmen können. Dadurch wird Wissen weitergegeben und Burnout vorgebeugt.

Ein wichtiger Bestandteil von Kubernetes ist das sogenannte Kubernetes Enhancement Proposal (KEP). Dieses System orientiert sich am Python Enhancement Proposal (PEP) und ist maßgeblich für die Entwicklung neuer Funktionen verantwortlich. Für jede neue Funktion wird ein Antrag in Form eines KEP eingereicht, der sowohl technische Details als auch die Nutzerrelevanz dokumentiert. Eine der strengen Vorgaben ist, dass jede Änderung eine Nutzer-sichtbare Verbesserung mit sich bringen muss – zumindest in Form eines Feature Flags – und dass sie umfassend dokumentiert wird. Die exzellente Dokumentation von Kubernetes wird oft als entscheidender Faktor für den Erfolg und die breite Akzeptanz genannt.

Für viele Beiträge, insbesondere für Neueinsteiger im Projekt, ist die Dokumentation daher ein perfekter Einstiegspunkt. Der Wettbewerbsvorteil von Kubernetes lässt sich auch auf den guten Ruf von Google zurückführen. Die Assoziation mit dem Suchmaschinen-Giganten und der engen Verbindung zu Docker, das bereits viele Entwickler kannten, sorgten für eine initiale Hype-Phase. Kubernetes konnte jedoch vor allem durch seine solide technische Umsetzung, die hervorragende Dokumentation und eine lebendige Community punkten, die kontinuierlich an der Weiterentwicklung arbeitet. In der Praxis ermöglicht Kubernetes Unternehmen, große, komplexe Backend-Anwendungen effizient zu verwalten, unabhängig davon, ob es sich um kleinere Projekte oder massive Multi-Cluster-Umgebungen handelt.

Die Plattform abstrahiert dabei die eigentliche Infrastruktur und sorgt gleichzeitig für Ausfallsicherheit, automatische Skalierung und einfache Bereitstellung von Anwendungen. Dem Nutzer wird so ein hohes Maß an Flexibilität geboten, ohne sich unmittelbar mit der darunterliegenden Systemverwaltung beschäftigen zu müssen. Ein weiterer Aspekt, der Kubernetes von vielen anderen Open-Source-Projekten unterscheidet, ist die Art und Weise, wie das Projekt mit der Community umgeht. Es gibt klare Richtlinien, um Burnout zu verhindern und eine nachhaltige Beteiligung zu gewährleisten. Neue Mitwirkende werden aktiv ermutigt und erhalten Unterstützung, um Verantwortung schrittweise übernehmen zu können.

So entsteht eine Kultur des Miteinanders und Lernens, die das Projekt lebendig hält. Neben der technischen Komplexität ist auch die Dokumentation ein zentraler Baustein für den nachhaltigen Erfolg von Kubernetes. Von der ersten Installation eines Clusters bis hin zu komplexen Features sind alle relevanten Informationen ausführlich beschrieben. Die Dokumentation wird laufend aktualisiert, begleitet von regelmäßigen Reviews und Qualitätssicherungsprozessen, die im Rahmen des Release-Zyklus verpflichtend sind. Kubernetes hat zudem den Weg für eine Vielzahl von Cloud-Diensten und Plattformen geebnet, die Kubernetes als Grundlage nutzen.

Anbieter wie Google Cloud mit dem Google Kubernetes Engine (GKE), Microsoft Azure mit Azure Kubernetes Service (AKS) oder auch Red Hat mit Openshift bieten verwaltete Kubernetes-Dienste an, die den Einstieg in Kubernetes erheblich vereinfachen und dessen Skalierbarkeit weiter fördern. Die breite Akzeptanz und Skalierbarkeit von Kubernetes hat den Wettbewerb unter Cluster-Management-Lösungen maßgeblich beeinflusst. Während es Alternativen wie Mesos oder Docker Swarm gibt, konnte Kubernetes aufgrund seiner flexiblen Architektur und starken Community den Markt dominieren. Dies zeigt sich nicht nur in der Zahl der Nutzer, sondern auch in der Vielfalt der unterstützten Tools und Erweiterungen. Die Zukunft von Kubernetes wird auch durch technologische Trends wie Künstliche Intelligenz und Machine Learning geprägt sein.

Interessanterweise ist die Kubernetes-Community bei der Nutzung von generativer KI für Dokumentationszwecke skeptisch und setzt aktuell eher auf traditionelle Ansätze, um hohe Dokumentationsqualität sicherzustellen. Gleichzeitig gibt es großes Interesse daran, KI-gestützte Tools zu entwickeln, die den Entwicklungsprozess verbessern und die Effizienz in Cloud-Umgebungen erhöhen. Wer sich heute in den Bereich Container-Orchestrierung einarbeiten möchte, findet bei Kubernetes nicht nur eine innovative technische Plattform, sondern auch eine unterstützende Community, die viele Einstiegsmöglichkeiten bietet. Beiträge zur Dokumentation oder kleine Bugfixes sind oft die ersten Schritte, die zur aktiven Mitarbeit führen können. Neben den technischen Fähigkeiten bietet die Mitarbeit an Kubernetes auch erhebliche berufliche Vorteile, etwa ein starkes Netzwerk und Sichtbarkeit in der Open-Source-Welt.

Zusammenfassend ist Kubernetes nicht nur technologisch eine Meisterleistung, sondern auch organisatorisch ein Vorbild für moderne Open-Source-Projekte. Von der historischen Basis bei Google Borg über die modulare Architektur mit Containern, Pods und Kubelets bis hin zu strengen Prozessen für Releases und Contributions zeigt Kubernetes, wie komplexe Softwareprojekte erfolgreich gestaltet und nachhaltig betrieben werden können. Die Kombination aus technischer Exzellenz, hervorragender Dokumentation und einer offenen, inklusiven Community macht Kubernetes zu einem Paradebeispiel moderner Softwareentwicklung und Container-Orchestrierung.