Die rasante Entwicklung großer Sprachmodelle (Large Language Models, LLMs) hat in den letzten Jahren zahlreiche Wissenschaftsbereiche revolutioniert. Insbesondere in der Chemie eröffnen diese Modelle neue Perspektiven, da sie auf enormen Textdatensätzen trainiert wurden und dadurch ein breites Spektrum an Wissen und logischem Denken simulieren können. Doch wie gut sind diese künstlichen Intelligenzen im Vergleich zu erfahrenen Chemikern tatsächlich? Können sie die komplexen Anforderungen chemischer Fragestellungen bewältigen oder handelt es sich primär um eine beeindruckende Nachahmung, die bei genauerem Hinsehen an ihre Grenzen stößt? Diese Fragen sind essenziell, um das Potenzial und die Risiken der Integration von LLMs in die chemische Forschung und Ausbildung zu verstehen. Die Bedeutung von Chemie im Zeitalter der künstlichen Intelligenz lässt sich kaum überschätzen. Von der Medikamentenentwicklung über Materialforschung bis hin zur Sicherheitsbewertung chemischer Stoffe sind präzise Kenntnisse und fundierte Entscheidungsfähigkeiten unverzichtbar.

Traditionell beruhte das chemische Wissen auf der intensiven Ausbildung und praktischen Erfahrung von Experten, die jahrelang grundlegende Prinzipien, Laborpraxis und komplexe Problemlösungsstrategien erlernten. LLMs nähern sich diesem Wissensgebiet auf völlig andere Weise – indem sie Millionen wissenschaftlicher Texte analysieren und Muster erkennen. Sie geben Antworten in natürlicher Sprache, was den Zugang zu komplexem Wissen demokratisiert und potenziell Beschleunigung in der Forschung ermöglicht. Um jedoch valide Aussagen über die Leistungsfähigkeit von LLMs in der Chemie treffen zu können, bedarf es systematischer Evaluationsinstrumente. Ein Meilenstein stellt hierbei das Framework ChemBench dar, das als umfassendes Benchmarking-System entwickelt wurde, um chemisches Wissen, Denkvermögen und Intuition von großen Sprachmodellen gegenüber menschlichen Chemikern zu messen.

Mit mehr als 2700 Frage-Antwort-Paaren aus unterschiedlichsten Quellen deckt ChemBench eine breite Palette chemischer Disziplinen ab. Dabei reicht das Spektrum von Basiswissen über anspruchsvolle Berechnungen bis hin zu komplexen Schlussfolgerungen. Die Fragen sind sowohl als Multiple-Choice als auch offen formuliert, um authentische Herausforderungen abzubilden. Die Ergebnisse, die im Rahmen dieser Benchmarkingstudie erzielt wurden, sind faszinierend und zugleich provokativ. Einige der modernsten LLMs übertrafen im Durchschnitt die besten menschlichen Chemiker bei der Beantwortung der Fragen.

Dabei handelt es sich jedoch keineswegs um einen vollständigen Triumph der KI. Modelle zeigen nach wie vor Schwächen bei grundlegenden Aufgaben und neigen dazu, ihre Antworten übermäßig selbstsicher zu präsentieren – ein Phänomen, das mit Vorsicht interpretiert werden muss, besonders wenn es um sicherheitsrelevante Informationen geht. Eine detaillierte Analyse der Leistungsfähigkeit der Modelle offenbart, dass ihre Stärke stark vom Themengebiet abhängt. Während LLMs solide Ergebnisse in allgemeinen und technischen Fragen der Chemie erzielen, schwächeln sie in spezialisierten Gebieten wie Toxikologie, Sicherheitsrichtlinien und analytischer Chemie. Insbesondere das Erkennen komplexer molekularer Strukturen und deren Eigenschaften, beispielsweise bei der Vorhersage von Kernspinresonanzsignalen, bleibt eine Herausforderung.

Hier zeigt sich, dass die Modelle zwar über umfangreiche Textmengen verfügen, jedoch die Fähigkeit, molekulare Topologien und deren chemische Implikationen wirklich zu „verstehen“, limitiert ist. Interessant ist auch die Beobachtung, dass gute Leistungen bei standardisierten, prüfungsorientierten Fragen nicht automatisch auf innovativere oder intuitivere chemische Fragestellungen übertragen werden können. Während LLMs bei Fragen aus Lehrbüchern relativ gut abschneiden, fällt es ihnen schwer, bei Aufgaben, die tiefere Vernetzungen und kreatives Denken erfordern, zu brillieren – Faktoren, die für erfolgreiche Forschung und Entwicklung unabdingbar sind. Die Verschmelzung von Chemie und Künstlicher Intelligenz wirft ebenso essentielle Fragen der Sicherheit und Verantwortung auf. Die Daten sind eindeutig: LLMs liefern gelegentlich falsche oder irreführende Antworten, die insbesondere für Laien verheerende Folgen haben könnten.

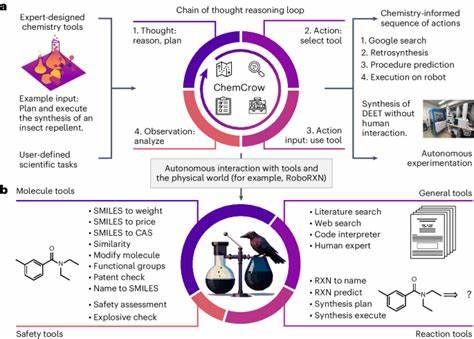

Dies gilt umso mehr, da die Verfügbarkeit solcher Modelle weltweit zunimmt und ihre Nutzung nicht mehr auf Fachkreise beschränkt ist. Deswegen ist es essentiell, dass die Modelle besser in der Selbsteinschätzung ihrer Unsicherheiten werden. Derzeit fehlt eine zuverlässige Kalibrierung der Vertrauenswerte, weshalb falsch beantwortete Fragen oft mit hoher Sicherheit präsentiert werden. Diese Limitationen spiegeln auch den momentanen Stand der Technik wider, denn LLMs sind in hohem Maße datengetriebene Systeme und kein Ersatz für kritisches menschliches Denken. Die Zukunft liegt vermutlich in hybriden Systemen, sogenannten Tool-Augmented Agents, die LLMs mit spezialisierten Datenbanken, Suchfunktionen und algorithmischen Modulen kombinieren.

Solche Systeme könnten die chemische Expertise erweitern, indem sie Menschen als wirkungsvolle Assistenten dienen, welche Informationen schnell zugänglich machen, aber zugleich die finale Bewertung und Verantwortung dem Fachwissen des Chemikers überlassen. Darüber hinaus fordern die Erkenntnisse aus Studien wie ChemBench eine Neuorientierung in der chemischen Ausbildung und Forschungskultur. Reines Faktenwissen und Routineaufgaben verlieren an Bedeutung, während das Verständnis komplexer Zusammenhänge, kritische Denkfähigkeit und die Bewertung von Unsicherheiten zentral werden. LLMs treiben diesen Wandel voran, indem sie das grundsätzliche Philosophie- und Methodenspektrum der Chemie infrage stellen. Das heißt jedoch nicht das Ende der menschlichen Chemiker, sondern vielmehr einen Wandel hin zu einer engeren Zusammenarbeit zwischen Mensch und Maschine.

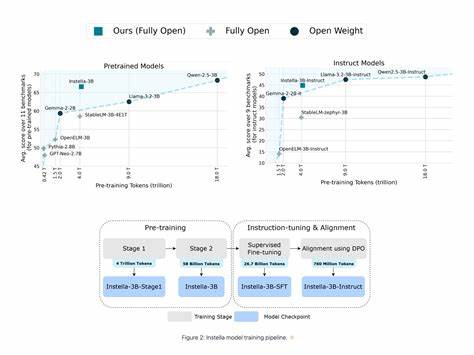

Zusätzlich bietet die Evaluierung von LLMs im Bereich Chemie wertvolle Hinweise für die weitere Entwicklung der Modelle selbst. Es zeigt sich, dass größere Modellsysteme tendenziell bessere Leistungen erbringen, was mit Skalierungsprinzipien der KI übereinstimmt. Jedoch genügt Größe allein nicht; die Integration domänenspezifischer Daten, etwa aus chemischen Datenbanken und Experimentiersammlungen, ist notwendig, um die Tiefe und Spezialisierung des Wissens zu verbessern. ChemBench adressiert außerdem die Herausforderung der Vielseitigkeit, indem es nicht bloß die reine Wissensabfrage, sondern auch reasoning-basierte Fragen sowie Präferenzentscheidungen in der Chemie (etwa bei der Auswahl von Molekülen in der Wirkstoffentwicklung) umfasst. Hierbei zeigen die Modelle noch deutliche Defizite, was den Bereich des maschinellen Lernens auf die Notwendigkeit hinweist, Präferenzlernen und menschliches Urteilsvermögen besser zu integrieren.

Nicht zuletzt kann die Chemieszene von offenen, wissenschaftlichen Benchmarking-Frameworks wie ChemBench profitieren, da diese transparente, vergleichbare und kontinuierliche Bewertungen von KI-Systemen ermöglichen. Die professionelle Community, einschließlich Hochschulen, Forschungseinrichtungen und Unternehmen, erhält so ein gemeinsames Instrument, um den Fortschritt zu messen und verantwortungsbewusst einzusetzen. Abschließend lässt sich festhalten, dass große Sprachmodelle große Fortschritte gemacht haben, um in den chemischen Wissenschaften mitzuhalten und teilweise sogar menschliche Experten zu übertreffen. Gleichzeitig darf man deren Grenzen nicht ignorieren. Die Verschmelzung von KI und Chemie ist eine spannende, dynamische Entwicklung, die das Potenzial hat, Forschung und Lehre grundlegend zu verändern.

Für eine erfolgreiche und sichere Integration braucht es weiterhin gemeinsames Engagement von Chemikern, Informatikern und Ethikern – damit die Zukunft der Chemie durch Technologie nicht nur beschleunigt, sondern auch verantwortungsbewusst gestaltet wird.