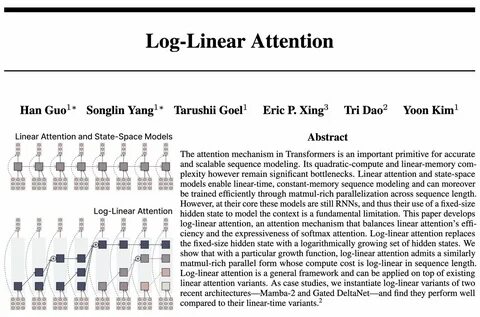

Die Entwicklung von Transformern hat in den letzten Jahren das Gebiet des maschinellen Lernens revolutioniert. Sie bilden die Grundlage für viele fortschrittliche Anwendungen, von der natürlichen Sprachverarbeitung über Bildverarbeitung bis hin zu Sequenzmodellierung in der Biotechnologie. Ein zentrales Element dieser Architektur ist der sogenannte Attention-Mechanismus, der es ermöglicht, relevante Informationen aus Sequenzen zu extrahieren und zu gewichten, um so genauere Vorhersagen zu treffen. Dennoch ist der klassische Attention-Mechanismus mit erheblichen Herausforderungen verbunden, insbesondere hinsichtlich seiner Rechenkomplexität und seines Speicherbedarfs bei sehr langen Sequenzen. Hier setzt die neuartige Methode der Log-Linear Attention an, die eine vielversprechende Brücke zwischen Effizienz und Ausdrucksstärke schlägt.

Der klassische Attention-Mechanismus in Transformern operiert mit einer quadratischen Rechenkomplexität in Bezug auf die Sequenzlänge. Dies bedeutet, dass die benötigte Rechenzeit und der Speicherbedarf mit der Länge der Eingabesequenz exponentiell zunehmen. Für Anwendungen, die sehr lange Sequenzen verarbeiten müssen, etwa in der Genomforschung oder bei langen Textpassagen, wird der Umgang mit diesem Aufwand schnell unpraktisch. Effizientere Ansätze wie Linear Attention und State-Space-Modelle haben versucht, dieses Problem zu mildern, indem sie eine lineare Zeitkomplexität und konstanten Speicherbedarf ermöglichen. Dabei werden oft rekurrente neuronale Netze (RNNs) genutzt, die durch ihre Wiederholungsstruktur skalierbar sind, aber dennoch Einschränkungen mit sich bringen, vor allem durch die Begrenzung auf einen festen, kleinen Hidden-State-Speicher.

Die innovative Log-Linear Attention zielt genau auf diese Einschränkung ab, indem sie den festen Hidden State durch eine logarithmisch wachsende Sammlung von Hidden States ersetzt. Dadurch wächst der repräsentative Kontext nicht linear mit der Sequenzlänge, sondern in einem günstigeren, log-linearen Verhältnis. Dies erhöht die Ausdruckskraft des Modells maßgeblich, da mehr Kontextinformationen erhalten und verarbeitet werden können, ohne dabei die Effizienz zu stark einzuschränken. Ein besonders bemerkenswerter Aspekt der Log-Linear Attention ist, dass sie sich nahtlos in die bisherige Infrastruktur der linearen Attention integrieren lässt. Das bedeutet, dass Modelle wie Mamba-2 oder Gated DeltaNet mit der Log-Linear Attention aufgerüstet werden können, um in ihrer Performance zu profitieren, ohne komplett neu entwickelt werden zu müssen.

In ersten Fallstudien konnte gezeigt werden, dass diese Varianten gegenüber ihren rein linearen Gegenstücken deutlich besser abschneiden, sowohl was Genauigkeit als auch Berechnungseffizienz betrifft. Die Grundlage für die Effizienzsteigerung liegt in der speziellen Wachstumsfunktion der Hidden States, die das Modell nutzt. Durch diese Funktion wird ermöglicht, dass die wichtigsten Kontextinformationen in einem logarithmisch wachsenden Speicher abgelegt werden können, während weniger wichtige Daten im Verlauf der Berechnung aggregiert werden. Dadurch entsteht ein eleganter Kompromiss zwischen der Notwendigkeit, möglichst viele Informationen aus der Eingabe zu erhalten, und dem praktischen Bedarf, Rechenressourcen zu schonen. Diese Idee spiegelt auch die generelle Tendenz wider, komplexe Systeme durch hierarchische und adaptive Speicherstrukturen leistungsfähiger und gleichzeitig effizienter zu gestalten.

Log-Linear Attention trägt so zu einem besser skalierbaren Paradigma bei, das für viele großangelegte Anwendungen des maschinellen Lernens relevant ist. Neben technischen Vorteilen hat Log-Linear Attention auch einen positiven Einfluss auf die Trainingsfähigkeit von Modellen. Durch die Reduzierung von Rechenkomplexität können Trainingsprozesse schneller durchgeführt werden, was wiederum zu einer leichteren Integration in praxisnahe Anwendungen führt. Dies ist besonders relevant, da die Trainingskosten für große Modelle eine der größten Herausforderungen in der aktuellen KI-Forschung darstellen. Darüber hinaus eröffnet die Log-Linear Attention interessante Möglichkeiten für neue Modellarchitekturen und hybride Ansätze, in denen die Vorteile von Transformer-Architekturen mit jenen rekurrenter Modelle kombiniert werden können.

Die dadurch erzeugte Flexibilität vereinfacht es, maßgeschneiderte Lösungen für spezielle Aufgaben zu entwickeln, bei denen eine Balance zwischen Computereffizienz und inhaltlicher Tiefe erforderlich ist. Insgesamt zeigt die Einführung von Log-Linear Attention einen wichtigen Schritt in Richtung effizienterer und leistungsfähigerer neuronaler Netze. Die Skalierbarkeit, die sie durch ihre besondere Speicher- und Berechnungsmethodik mitbringt, unterstützt die weitere Expansion von KI-Anwendungen in Bereiche mit extrem langen Datenreihen. Sei es bei der Analyse umfangreicher Textkorpora, bei der Modellierung komplexer zeitlicher Abläufe oder bei der Verarbeitung biologischer Sequenzen – die Möglichkeiten, die Log-Linear Attention bietet, sind vielfältig und vielversprechend. Die Weiterentwicklung dieser Technologie wird auch die Forschungsgemeinschaft nachhaltig beeinflussen, da neue Fragen hinsichtlich Optimierung, Parallelisierung und Anwendungsbreiten entstehen.

![Of all the AI Unicorns founded post transformer. [...] none have come out of YC](/images/90E6326E-2A5A-4B31-A796-C7AAEF37EB94)