Die Migration von Benutzerdaten stellt viele Unternehmen vor große Herausforderungen, insbesondere wenn Millionen von Nutzern betroffen sind und das System während der Migration aufrechterhalten bleiben muss. Insbesondere bei der Ablösung einer Altsystemplattform durch ein neues System ist es unerlässlich, einen unterbrechungsfreien Übergang zu gewährleisten und Datenverluste zu vermeiden. Die erfolgreiche Bewältigung einer solchen Aufgabe erfordert den Einsatz moderner Technologien und durchdachter architektonischer Lösungen. Im Zentrum der Betrachtung steht dabei die Kombination aus Debezium, Apache Kafka und einem ausgeklügelten Synchronisationsalgorithmus mit Zykluserkennung, die eine zielgerichtete und konsistente Datenmigration ermöglicht. Anhand eines Großprojekts bei Kleinanzeigen, einer der führenden Online-Kleinanzeigenplattformen in Deutschland, lassen sich praxisnahe Einblicke in die konkreten Herausforderungen und Lösungsansätze bieten, die für eine erfolgreiche Benutzerdatenmigration unerlässlich sind.

Kleinanzeigen verarbeitet monatlich über 30 Millionen einzigartige Nutzer und muss entsprechend mit massiven Datenmengen umgehen, was die Migration in ein neues System besonders komplex macht. Vor dem Hintergrund umfangreicher technischer Altlasten wurde der Migrationsprozess so konzipiert, dass sowohl die alten als auch die neuen Systeme parallel betrieben werden können. Auf diese Weise kann eine schrittweise Migration einzelner Nutzer erfolgen mit der Option zur Rückkehr auf das Altsystem bei Fehlern. Das Prinzip der gleichzeitigen Systembetreibung sorgt für Sicherheit und minimiert das Risiko eines vollständigen Systemausfalls. Die Koordination der Migration der verschiedenen Nutzerdaten ist eine zentrale Herausforderung.

Nutzerdaten bestehen häufig aus verschiedenen, voneinander abhängigen Entitäten wie Profilinformationen, Anzeigen, Transaktionen oder Nachrichten. Die korrekte Reihenfolge der Migration wird durch diese Abhängigkeiten festgelegt, damit keine inkonsistenten oder funktionsuntüchtigen Daten entstehen. Zum Beispiel kann eine Anzeige nicht migriert werden, bevor das zugehörige Nutzerprofil übertragen wurde. Die Strategie setzt daher auf eine abgestimmte Sequenz: Zuerst die Kern-Nutzerdaten wie Identifikatoren und Authentifizierungsinformationen, anschließend die abhängigen Daten. Für die technische Umsetzung wurde eine asynchrone Streaming-Architektur mit Kafka als zentralem Nachrichtenbus gewählt.

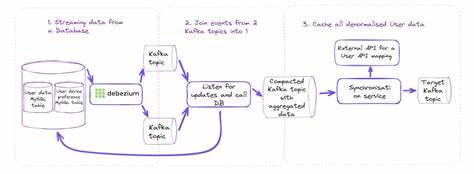

Im Gegensatz zu einem einfachen, synchronen Dual-Write-Ansatz, der auf parallele synchronisierte Schreibvorgänge in beide Systeme setzt, bietet die asynchrone Lösung höhere Ausfallsicherheit und Flexibilität. Netzwerkausfälle oder Verzögerungen lassen sich besser abfedern, und die Vergabe von Verantwortlichkeiten für Daten-Transformationen entfällt nicht auf einzelne Systeme, sondern kann in der Streaming-Pipeline umgesetzt werden. Die Umsetzung der eigentlichen Datenerfassung neuer oder geänderter Nutzerdaten aus dem Altsystem erfolgte durch die Change Data Capture (CDC)-Technologie von Debezium. Debezium liest Änderungen direkt aus den binären Transaktionsprotokollen der Datenbank (z.B.

MySQL Binlog) aus und sendet diese in Echtzeit an Kafka-Topics. Die gewonnene Event-Stream-Datenbasis ermöglicht eine unmittelbare Reaktion auf Änderungen und liefert somit die Grundlage für die inkrementelle Migration und Synchronisation. Dabei galt es zunächst, technische Voraussetzungen zu klären und pragmatische Lösungen für Limitierungen zu finden. Beispielsweise verwendete das bestehende MySQL-Cluster eine nicht geeignete Log-Formatierung und war nicht für Global Transaction Identifier (GTID) konfiguriert, was die Nutzung von Debezium erschwerte. Durch das Anlegen zusätzlicher MySQL-Instanzen mit row-basiertem Binlog und den Einsatz eines Reverse Proxys als Single Point of Entry konnte die Infrastruktur für Debezium zugänglich gemacht werden, ohne das bestehende Cluster maßgeblich zu verändern.

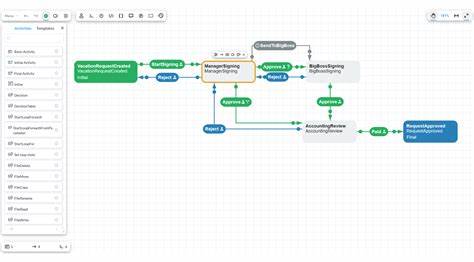

Dies zeigt, dass pragmatische Kompromisse oft mehr Wert bringen als risikoreiche, umfassende Infrastrukturänderungen im laufenden Betrieb. Neben der Erfassung von Nutzeraktualisierungen stand die Steuerung und Nachverfolgung des Migrationsfortschritts im Fokus. Hierfür wurde ein eigener Entitätstyp namens „Emigrant“ eingeführt, der die Migration der Nutzer als Zustandsmaschine modelliert. Von anfänglicher Identifizierung, über Berechtigung zur Migration, Anfragen bis hin zur endgültigen Migration und Übergabe an das neue System – jeder Schritt wird in klaren Zustandsübergängen abgebildet. Diese differenzierte Modellierung erleichtert nicht nur die Nachvollziehbarkeit, sondern erlaubt auch die einfache Wiederaufnahme und Fehlerbehandlung bei fehlgeschlagenen Migrationen.

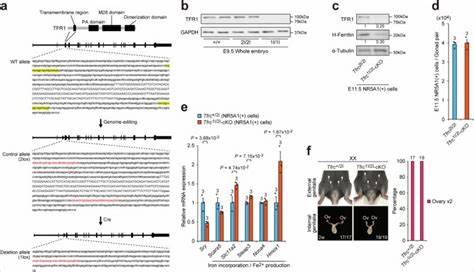

Debezium spielt hier eine zentrale Rolle, indem es nicht nur Nutzerdaten, sondern auch alle Änderungen am Emigrant-Zustand in Kafka abbildet. Die hohe Integrationsdichte und Konsistenz zwischen Nutzerdaten und Migrationsstatus ist damit gesichert. Ein kritischer Aspekt bei der parallelen Systemnutzung ist die Vermeidung von Dateninkonsistenzen durch widersprüchliche oder zyklische Aktualisierungen zwischen dem alten und neuen System. Es droht das Risiko von unendlichen Update-Schleifen, wenn dieselben Daten in beiden Systemen wechselseitig immer wieder aktualisiert werden. Die Lösung liegt in der Einführung eines logischen Synchronisationsmechanismus, der auf dem typischen @Version-Feld basiert, das in JPA/Hibernate für Optimistic Locking verwendet wird.

Dieses Versionsfeld verhält sich wie eine monotone logische Uhr und kann als Bezugsgröße dienen, um festzustellen, ob ein Update bereits verarbeitet wurde oder neu ist. Das Mapping zwischen Nutzerentität und Emigrant spielt für die Versionierung eine wichtige Rolle. Updates mit niedrigerer oder gleicher Version werden ignoriert, wodurch ein Rückkopplungskreislauf unterbrochen wird. Ergänzend dazu wurde die Systemarchitektur so konzipiert, dass vor der Migration alle Nutzerupdates im Altsystem stattfinden, ab dem Übergangspunkt (Transition) nur noch im neuen System. Trotzdem gibt es Exceptions, wie beispielsweise Passwort-Zurücksetzungen oder Sperrungen, die auch nach dem Übergang im Altsystem erlaubt sind und synchronisiert werden müssen.

Mit der Implementierung des Synchronisationsalgorithmus auf Basis des Versionsfelds werden solche Ausnahmen sicher abgebildet, ohne endless loops zu erzeugen. Die gesamte Architektur erinnert damit an die Funktionsweise verteilter Datenbanken, die mit Partitionstoleranz und Ausfallresistenz arbeiten. So ist auch unter komplexen Betriebsbedingungen sowohl die Verfügbarkeit als auch eine eventual konsistente Datenhaltung gewährleistet. Die Nutzer erleben einen nahtlosen Wechsel, da ihre Daten kontinuierlich synchronisiert werden und es keine Downtime gibt. Auch im Fehlerszenario bleibt die Datenintegrität erhalten.

Zusammenfassend wird offensichtlich, dass moderne Datenmigrationsprojekte weit über eine einfache Datenkopie hinausgehen müssen. Die Kombination aus Kafka, Debezium und einer intelligenten Steuerungslogik verhilft Unternehmen dazu, komplexe Migrationsszenarien mit minimalem Risiko umzusetzen. Das Beispiel von Kleinanzeigen verdeutlicht, wie technische Innovation, pragmatisches Infrastructure Engineering und eine sorgfältige Zustandsverwaltung zusammenwirken, um eine stabile und skalierbare Datenmigration zu realisieren. Unternehmen, die vor ähnlichen Herausforderungen stehen, sollten diese Architekturprinzipien adaptieren und Technologien wie Change Data Capture und verteilte Streaming-Plattformen nutzen, um zukünftige Migrationen erfolgreich zu meistern. So bleibt die Datenintegrität über Systemgrenzen hinweg garantiert, Datenverluste und Downtimes werden vermieden und die Nutzererfahrung durchgehend positiv gestaltet.

Die Investition in eine moderne, eventbasierte Migrationsarchitektur lohnt sich damit nicht nur kurz-, sondern auch langfristig, da sie gleichzeitig auch als Basis für weitere Datenintegrations- und Replikationsszenarien dienen kann.