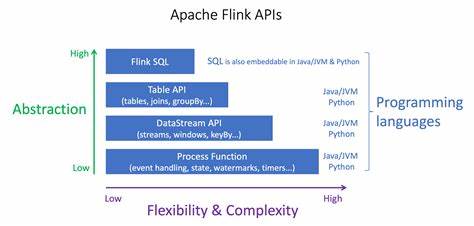

Die Welt des Stream-Processings entwickelt sich kontinuierlich weiter. Technologien wie Apache Flink spielen dabei eine zentrale Rolle, um Echtzeit-Datenströme effizient zu verarbeiten. Flink SQL stellt dabei eine deklarative Schnittstelle dar, die auf bewährten Datenbanktechniken basiert und komplexe Pipelines auf einfache Weise ermöglicht. Doch obwohl SQL mächtig ist, stößt es bei komplexeren Anforderungen, etwa beim Umgang mit verschachtelten Datenstrukturen oder dem Einsatz bewährter Bibliotheken, oft an Grenzen. Hier kommen die Benutzerdefinierten Funktionen, kurz UDFs, ins Spiel und ermöglichen die Integration imperativer Logik in die deklarative Welt von Flink.

Die Erweiterung Iron Functions erweitert diese Möglichkeiten nochmals erheblich und schafft neue Freiräume für Entwickelnde verschiedenster Fachrichtungen. Iron Functions basiert auf WebAssembly und ermöglicht so die sichere und performante Ausführung von UDFs in mehreren Programmiersprachen wie TypeScript, Rust und Go, die üblicherweise nicht direkt in Flink unterstützt werden. Gerade für Teams, in denen neben Java und Python auch andere Sprachen zum Einsatz kommen, eröffnet dies ungeahnte Flexibilität. Die Polyglottes Programmieren der UDFs sorgt dafür, dass Spezialwissen in bestimmten Sprachen und Ökosystemen genutzt werden kann, um maßgeschneiderte Funktionen zu entwickeln und in Flink-Pipelines einzubinden. Der Entwicklungsprozess ist angenehm und einsteigerfreundlich gestaltet.

Mit dem ironfun CLI-Tool kann man einfach ein Projekttemplate generieren, das bereits vorkonfigurierte Schnittstellen und Typannotationen enthält. Diese sind notwendig, um Eingabe- und Ausgabeparameter der UDFs klar zu definieren und sicherzustellen, dass Flink diese korrekt interpretiert. Beispielsweise verwendet TypeScript dekorative Annotationen, um Array-Typen oder komplexere Strukturen zu beschreiben, während Rust intelligent Attribute und Trait-Derivierungen nutzt. In Go geschieht die Typisierung über strukturierte Kommentare, die automatisch verarbeitet werden. Nach der Implementierung des UDF-Logikcodes wird die Funktion mittels ironfun kompiliert und als JAR-Paket für Flink bereitgestellt.

Dabei sind verschiedene Optionen verfügbar, die gerade bei Einsatz in verwalteten Umgebungen wie Confluent Flink oder Ververica von Vorteil sind, etwa das Erstellen eines sogenannten "Uber-JARs" inklusive aller notwendigen Abhängigkeiten und Lizenzinformationen. Ein herausragender Vorteil der Verwendung von WebAssembly bei Iron Functions ist die Sicherheit und Isolation. WebAssembly-Code läuft in einer Sandbox und kann standardmäßig weder Dateien lesen noch Netzwerkverbindungen aufbauen oder auf den Host-Speicher zugreifen. Das minimiert Risiken durch fehlerhafte oder bösartige Codeausführung erheblich. Gleichzeitig gibt es gezielte Möglichkeiten, kontrollierten Zugriff auf Zusatzfunktionen wie HTTP-Clients oder Speicherschnittstellen bereitzustellen.

So entstehen sichere Ausführungsumgebungen, die sich sogar für Szenarios eignen, in denen externe Benutzer eigene Funktionen einspeisen dürfen. Ein weiterer Pluspunkt betrifft die Portabilität der UDFs. Dank der kompakten und systemunabhängigen Natur von WebAssembly können die erzeugten Artefakte auf vielfältigen Plattformen ausgeführt werden, von lokalen Entwicklungsumgebungen über On-Premise-Flint- oder Kubernetes-Deployments bis hin zu vollständig verwalteten Cloud-Diensten. Die Flexibilität erstreckt sich auch auf verschiedene Anwendungsszenarien, wie etwa Standortbestimmung anhand von Koordinaten. Ein Beispiel in TypeScript zeigt, wie mit externen Bibliotheken wie geolib präzise Distanzen berechnet werden können.

Dabei werden Eingangsparameter als Arrays definiert, eine optionale Präfixzeichenkette ergänzt das Ergebnis, das anschließend als String zurückgegeben wird. Solche praxisnahen Beispiele zeigen, wie leicht sich komplexe Berechnungen und Datenmanipulationen in UDFs umsetzen lassen. Für das Blockchain-Umfeld bietet Rust dank seiner hohen Effizienz und der starken Typisierung optimale Voraussetzungen. Mit Iron Functions lassen sich Ethereum-Logs entschlüsseln und verarbeiten, indem gängige Rust-Crates wie ethabi-decode eingebunden werden. So können Event-Logs direkt innerhalb einer Flink-Pipeline dekodiert und analysiert werden, was neue Einsichten in hochdynamische Blockchain-Daten erlaubt.

Ein weiteres Beispiel ist die Verarbeitung von OpenTelemetry-Logs mit Go, wo strukturierte Logdaten in Form von JSON geparst und umformatiert werden. Die Integration in die Flink Table API erfolgt nahtlos, sodass Nutzer innerhalb ihrer Streaming-Umgebung flexibel und performant mit unterschiedlichsten Datenformaten und Logs arbeiten können. Die Kombination der verschiedenen Programmiersprachen und der einfachen Bereitstellungsmöglichkeiten schließt eine wichtige Lücke in der Anwendungspalette von Apache Flink. Sie erlaubt insbesondere nicht nur data-lastigen Entwicklern, sondern auch Data Scientists, Machine Learning Engineers und Application Engineers den Zugriff auf Flink-Pipelines mit vertrauten Werkzeugen. Dies ist ein bedeutender Schritt hin zu einer breiteren Akzeptanz und Nutzung, die über traditionelle, rein Java-basierte Umgebungen hinausgeht.

Zusammenfassend bietet Iron Functions eine leistungsstarke Erweiterung der UDF-Funktionalität in Apache Flink. Die Fähigkeit, sichere, portable und mehrsprachige Funktionen zu erstellen, eliminiert Einschränkungen und fördert die Innovation im Bereich des Stream-Processing. Entwickler profitieren von einer vereinfachten Entwicklung, erweiterten Sicherheitsmechanismen und nahtloser Integration in unterschiedliche Flink-Ökosysteme. Die vielfältigen praktischen Anwendungsfälle zeigen, dass Iron Functions bereit ist, den nächsten Schritt in der Evolution moderner Datenströme zu begleiten und neue Einsatzgebiete zu erschließen. Bei Interesse stehen umfassende Dokumentationen sowie kostenlose Testlizenzen bereit, um den schnellen Einstieg zu ermöglichen und individuelle Anforderungen zu adressieren.

So können Teams jeder Größe und jedes Erfahrungsniveaus Flink als solides Fundament für hochgradig flexible, skalierbare und sichere Echtzeitdatenverarbeitung einsetzen.

![Running AI coding agents locally with container use [video]](/images/A1EEC865-16F0-42C8-A0B4-2006821DDE9F)