Die künstliche Intelligenz hat in den letzten Jahren enorme Fortschritte gemacht. Systeme wie ChatGPT haben beeindruckende Fähigkeiten im Verstehen und Generieren von Texten entwickelt, was die Nutzung von KI in allen möglichen Bereichen stark vorangetrieben hat. Doch trotz dieser Erfolge gibt es eine ernsthafte Schwäche, die zunehmend größere Aufmerksamkeit erfährt: Das Problem der sogenannten Halluzinationen. Diese beschreiben Situationen, in denen KI-Modelle falsche oder erfundene Informationen ausgeben, die nicht auf realen Daten oder Fakten basieren. Und nach neuesten Berichten von OpenAI scheint das Halluzinieren von ChatGPT sogar schlimmer zu werden – ein Phänomen, das selbst Experten vor Rätsel stellt.

Dieses Problem könnte die Vertrauenswürdigkeit von KI-Systemen massiv beeinträchtigen und stellt damit eine große Herausforderung für die weitere Entwicklung dar. Das Phänomen der Halluzination bei KI bedeutet nicht etwa, dass Maschinen ein bewusstes Erleben haben, wie Menschen es kennen. Vielmehr handelt es sich darum, dass ein KI-Modell, basierend auf seinen Trainingsdaten und Wahrscheinlichkeitsberechnungen, falsche oder unzutreffende Antworten generiert, die sehr plausibel klingen können. Dabei kann es sich um erfundene Fakten, falsche Zitate oder komplett erfundene Zusammenhänge handeln. Für Anwender führt dies dazu, dass das Vertrauen in die externe Quelle, also die KI, stark abnimmt, weil die gelieferten Informationen nicht ohne weiteres überprüfbar oder gar grob falsch sind.

Neueste Untersuchungen von OpenAI, dem Unternehmen hinter ChatGPT, haben gezeigt, dass die neuesten Modelle, darunter GPT o3 und GPT o4-mini, deutlich anfälliger für Halluzinationen sind als ihre Vorgänger. Laut Tests des Unternehmens lag die Halluzinationsrate bei GPT o3 im sogenannten PersonQA-Benchmark bei rund 33 Prozent, während das ältere Modell o1 nur etwa 15 Prozent aufwies. Sogar noch alarmierender ist die Quote bei GPT o4-mini, das in einigen Tests bis zu 48 Prozent falsche Antworten lieferte. Diese Zahlen verdeutlichen einen Trend, der auf den ersten Blick paradox erscheint: Obwohl die neueren Versionen der Sprachmodelle komplexere Fähigkeiten und verbesserte Denkprozesse zeigen, nehmen die Fehler in Form von Halluzinationen zu. Ein möglicher Grund für diese Zunahme liegt im Wandel der Modellarchitektur und der Trainingsmethoden.

Moderne Sprachmodelle setzen zunehmend auf sogenannte reasoning models, also Systeme, die nicht nur auf Wahrscheinlichkeiten basieren, sondern versuchen, komplexe Aufgaben durch eine kaskadierende Zerlegung in Teilschritte zu lösen – ähnlich wie ein Mensch, der nachdenkt. Diese sogenannte Chain-of-Thought-Technik soll eigentlich zu präziseren Ergebnissen führen. Die Realität scheint aber eine andere zu sein: Die erhöhte Komplexität und das Zusammenspiel vieler Zwischenschritte können auch Fehlerquellen erhöhen und die generierten Antworten anfälliger für falsche Schlussfolgerungen machen. Die Problematik hat tiefere technische Ursachen. Sprachmodelle wie GPT basieren auf einer enormen Menge an Trainingsdaten, die aus dem Internet, Büchern, Artikeln und anderen Quellen stammen.

Dabei sind viele dieser Quellen nicht immer wahre oder verlässliche Informationen. Die KI „lernt“ also auch, zwischen verlässlichen und unzuverlässigen Informationen zu unterscheiden, ist aber keine perfekte Fähigkeit dieser Systeme. Im Endeffekt generiert das Modell auf Basis der erlernten Muster Antworten, die zwar oft überzeugend klingen, aber inhaltlich falsch sind. Das Paradox, dass leistungsfähigere Modelle mehr halluzinieren, stellt die Entwickler vor eine große Herausforderung. Es gibt derzeit keinen einfachen Weg, Halluzinationen vollständig zu vermeiden, da sie eng mit der Funktionsweise von Sprachmodellen verbunden sind.

OpenAI selbst räumt ein, dass weitere Forschung nötig ist, um zu verstehen, warum die neuesten Modelle häufiger falsche Informationen erzeugen. Neben technischen Schwierigkeiten spielen auch ethische Implikationen eine bedeutende Rolle: Ist es vertretbar, KI-Systeme mit potenziell gefährlichen Fehlinformationen zu betreiben, wenn daraus zum Beispiel rechtliche, medizinische oder politische Konsequenzen entstehen können? Ein Ansatz zur Reduzierung von Halluzinationen liegt in der Verbesserung der Trainingsdatenqualität. Eine sauberere, besser kuratierte Datenbasis könnte helfen, Korrektheit und Verlässlichkeit der Modelantworten zu erhöhen. Gleichzeitig ist es wichtig, verstärkte Prüfmechanismen einzubauen, bei denen KI-Modelle ihre eigenen Antworten verifizieren oder auf externe vertrauenswürdige Quellen zurückgreifen. Solche Hybridlösungen, die maschinelles Lernen mit klassischer Wissensdatenbank kombinieren, werden als vielversprechend angesehen.

Auch bei den Endnutzern selbst besteht Verbesserungsbedarf. KI-Systeme sollten mit klaren Warnhinweisen auf Unsicherheiten arbeiten. Anwender müssen darüber informiert werden, dass nicht alle Antworten zuverlässig sind, und bei kritischen Entscheidungsprozessen eine manuelle Prüfung ratsam ist. Dadurch könnte das Vertrauen bedacht und gleichzeitig die Verantwortung klar geregelt werden. Die damit verbundenen Herausforderungen sind auch ein Mahnmal für die KI-Branche insgesamt.

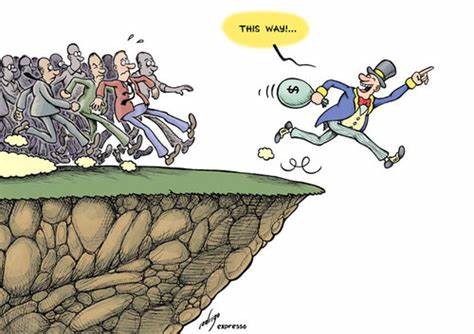

Der rasante Fortschritt führt häufig zu einem Wettbewerb um immer stärkere und leistungsfähigere Systeme. Dabei geraten fundamentale Qualitätsaspekte und Sicherheit mitunter in den Hintergrund. Der Fall der zunehmenden Halluzinationen verdeutlicht, dass Quantität und Komplexität der KI nicht automatisch mit besserer Verlässlichkeit gleichzusetzen sind. Weltweit forschen deshalb Experten nach Wegen, das Halluzinationsproblem einzudämmen. Dabei wird häufig auf interdisziplinäre Ansätze gesetzt: Neben technischer Forschung sind auch Sprachwissenschaftler, Ethiker und Juristen an der Entwicklung beteiligt, um eine allumfassende Perspektive zu gewährleisten.

Nur so kann sichergestellt werden, dass zukünftige KI-Modelle nicht nur leistungsfähig, sondern auch vertrauenswürdig und verantwortungsvoll eingesetzt werden können. Zusammenfassend lässt sich sagen, dass das Halluzinieren von ChatGPT und ähnlichen KI-Systemen eine der größten Hürden für den dauerhaften Erfolg und die breite Akzeptanz darstellt. Die Ursachen sind vielschichtig und reichen von der Architektur der Modelle über die Datenbasis bis hin zur Anwendungspraxis und ethischen Bewertung. Trotz der derzeit schwierigen Lage sind Forscher und Entwickler voller Zuversicht, dass Fortschritte erzielt werden können. Bis dahin bleibt eine kritische Haltung der Nutzer und eine offene Diskussion innerhalb der Gesellschaft wichtig, um Chancen und Risiken der künstlichen Intelligenz gleichermaßen zu beachten.

Die Zukunft der KI wird maßgeblich davon abhängen, inwieweit es gelingt, die Balance zwischen Leistungsfähigkeit, Sicherheit und Verlässlichkeit zu finden. ChatGPT und seine Nachfolger werden weiterhin einen bedeutenden Platz im Alltag vieler Menschen einnehmen, allerdings nur wenn die problematische Tendenz zu Halluzinationen eingedämmt wird. Die kommenden Jahre werden zeigen, ob das tiefgreifende Verständnis der Mechanismen dieses Phänomens gelingen wird und ob die KI-Branche gestärkt aus dieser Herausforderung hervorgeht.