Die Chemie als Wissenschaft ist bekannt für ihre Komplexität und Tiefe, die ein tiefes Verständnis von Fachwissen, analytischem Denken und praktischer Erfahrung erfordert. Mit dem Aufkommen großer Sprachmodelle wie GPT-4, Claude oder Galactica ist ein neuer Akteur auf der Bühne der chemischen Forschung erschienen. Diese Modelle haben das Potenzial, die Art und Weise zu verändern, wie chemisches Wissen erfasst, verarbeitet und angewendet wird. Doch wie stehen diese künstlichen Systeme im Vergleich zu menschlichen Chemikern da? Können sie die Expertise von Fachleuten ersetzen oder zumindest sinnvoll ergänzen? Diese Fragen sind zentral, um die Rolle von LLMs in der Chemie zu verstehen. Ein aktuelles Forschungsprojekt namens ChemBench bietet eine umfassende Benchmarking-Plattform, auf der die Fähigkeiten modernster Sprachmodelle gegenüber erfahrenen Chemikern systematisch untersucht werden.

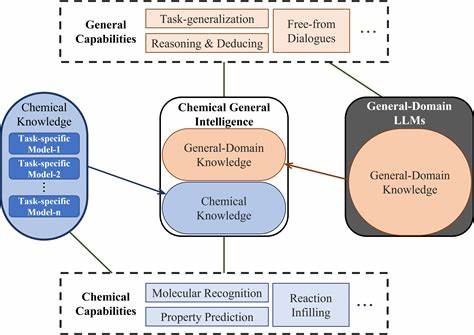

Dabei zeigt sich ein faszinierendes Bild voller Potenziale, aber auch signifikanter Herausforderungen. Im Folgenden werden die wichtigsten Erkenntnisse, Hintergründe und Perspektiven zu diesem spannenden Thema vorgestellt. Große Sprachmodelle – Grundlagen und Besonderheiten Große Sprachmodelle sind auf Basis von maschinellen Lernverfahren entwickelte Systeme, die durch das Trainieren mit enormen Textkorpora menschliche Sprache verstehen und generieren können. Ursprünglich für allgemeine Zwecke konzipiert, werden viele LLMs heute mit spezifischen Domänendaten oder Zusatzwerkzeugen erweitert, um auch in Fachgebieten wie Medizin, Recht oder eben Chemie fundierte Antworten zu geben. Ihre enorme Rechenleistung und Umfang ermöglicht ihnen ein Spektrum von Kompetenzen, das von einfachen Faktenabbrufen bis zu komplexen Schlussfolgerungen reicht.

Trotz der hohen Leistungsfähigkeit bestehen jedoch weiterhin grundlegende Zweifel an ihrer Fähigkeit, tiefergehende, kritische und praktische Chemiekenntnisse wie ein erfahrener Humanexperte abzubilden. Warum? Weil LLMs im Kern auf statistischen Mustern und Wahrscheinlichkeiten basieren und mitunter als „stochastische Papageien“ bezeichnet werden, die Informationen reproduzieren, statt wirkliches Verständnis zu besitzen. Der Chemie-Expertenvergleich: ChemBench als neues Standardwerkzeug Um Klarheit zu gewinnen, wurde das Projekt ChemBench ins Leben gerufen. Es bietet eine umfangreiche Sammlung von mehr als 2700 Frage-Antwort-Paaren, die verschiedene Gebiete und Schwierigkeitsstufen der Chemie abdecken. Die Fragestellungen sind darauf ausgelegt, nicht nur reines Faktenwissen abzufragen, sondern auch komplexes Denken, Problemlösen, Intuition und Berechnungen zu testen.

Dabei umfasst die Bandbreite Themen aus der allgemeinen, anorganischen, technischen und analytischen Chemie. Das Besondere an ChemBench ist die Möglichkeit, sowohl Multiple-Choice-Fragen als auch offene Fragestellungen zu verwenden, wodurch die Vielfalt der Prüfungsformate im Studium und der realen Forschung reflektiert wird. Parallel zur Bewertung der LLMs wurden auch Chemiker mit unterschiedlichem Hintergrund und Erfahrungsgrad befragt, wodurch ein direkter Leistungsabgleich möglich wurde. Ergebnisse verblüffen: LLMs auf Augenhöhe mit Chemikerexperten Die Tests mit führenden Modellen wie GPT-4 oder dem Open-Source-Modell Llama-3.1-405B-Instruct offenbarten überraschende Ergebnisse.

In vielen der abgefragten Bereiche erzielten die Modelle nicht nur gute, sondern oft bessere Ergebnisse als die getesteten menschlichen Experten. Besonders bei traditionellen Wissensfragen oder solchen, die laut Textbüchern gelehrt werden, lagen die automatisierten Systeme oft vorn. Dies verweist auf ihre Fähigkeit, große Mengen an Wissen im Gedächtnis zu speichern und blitzschnell abzurufen. Allerdings zeigen sich bei den Modellen Schwächen, wenn es um mehrere logische Schlussfolgerungsschritte, die Bewertung komplexer Molekülstrukturen oder das Einschätzen von chemischer Präferenz geht. Beispielsweise fiel es den LLMs schwer, in der analytischen Chemie die korrekte Anzahl von Signalen in einem Kernspinresonanzspektrum vorherzusagen, was bei den Menschen besser gelang.

Ebenso konnten die KI-Systeme die menschliche Intuition bei der Auswahl bevorzugter Moleküle in der Wirkstoffforschung nicht zuverlässig nachbilden. Sicherheit und Fehleinschätzungen bleiben zentrale Risiken Im Gegensatz zu einem erfahrenen Chemiker, der Unsicherheiten oder fehlendes Wissen meist kennt und entsprechend kommuniziert, neigen einige LLMs dazu, mit übertriebener Zuversicht falsche Antworten zu geben. Dieses Verhalten birgt Risiken, insbesondere wenn die Modelle von Studenten oder Laien für sicherheitsrelevante Fragen verwendet werden. Trotz des Einsatzes von Werkzeugen wie Websuche oder Datenbankintegrationen sind die LLMs noch nicht konkurrenzfähig bei der Beschaffung und Interpretation spezialisierter Informationen aus Chemiesicherheitsdatenbanken. Das zeigt sich auch in den relativ schwachen Ergebnissen bei Fragen zum Thema Toxizität oder chemischer Sicherheit.

Experten plädieren deshalb für eine kritische Nutzung und die Kombination von Modellantworten mit menschlicher Aufsicht. Perspektiven für Ausbildung und Forschung Die rasanten Fortschritte der KI in der Chemie werfen auch Fragen hinsichtlich der Ausbildung zukünftiger Chemiker auf. Traditionelles Lernen, das hauptsächlich auf Auswendiglernen basiert, wird durch die Fähigkeiten von LLMs in den Hintergrund rücken. Stattdessen rückt die Förderung eines tieferen Verständnisses, kritischer Denkfähigkeiten und die Fähigkeit zum Hinterfragen automatisierter Ausgaben in den Fokus. Die Erkenntnisse von ChemBench verdeutlichen, dass Chemiker verstärkt zum Kurator, Kritiker und Anwender von KI-Systemen werden müssen, um von deren Geschwindigkeit und Umfang zu profitieren und gleichzeitig Fehlentwicklungen vorzubeugen.

Gleichzeitig stellt die Forschungsarbeit an solchen Modellen und Benchmark-Frameworks auch eine Chance dar, die Werkzeuge zielgerichtet zu verbessern – zum Beispiel durch Training mit spezialisierteren Datensätzen oder durch die Weiterentwicklung von Modellen, die besser einschätzen können, wann sie keine verlässliche Antwort liefern können. Hierbei ist die Entwicklung vertrauenswürdiger Mensch-Maschine-Interaktionen von großer Bedeutung. Auch das Thema Sicherheit und verantwortungsvoller Umgang mit potenziell missbräuchlichen Anwendungen bleibt ein Schwerpunkt, denn viele der eingesetzten Technologien können sowohl für harmlose als auch für problematische Zwecke genutzt werden. Im Ergebnis verspricht die enge Zusammenarbeit von KI-Entwicklern, Chemikern und Ausbildnern eine produktive Symbiose, die Beiden Seiten neue Möglichkeiten eröffnet. Fazit Die Bewertung großer Sprachmodelle im chemischen Kontext zeigt, dass diese Systeme in vielen Bereichen erstklassige Leistungen erbringen und sogar Expertenwissen übertreffen können.

Dennoch sind sie noch keine vollwertigen Ersatzlösungen für erfahrene Chemiker. Besonders wenn es um komplexe Schlussfolgerungen, Intuition und Sicherheitsfragen geht, sind menschliches Urteilsvermögen und kritisch-reflektierende Fähigkeiten unerlässlich. Die Chemiemodelle unterstützen und ergänzen heute schon die Arbeit von Chemikern, die sich zunehmend als Partner mit der KI verstehen müssen – eine Entwicklung, die Fachwissen auf eine neue Ebene hebt. Die kontinuierliche Entwicklung von etwaigen Benchmark-Frameworks wie ChemBench wird zudem dazu beitragen, Fortschritte systematisch zu erfassen, die Technik zu verbessern und Risiken zu minimieren. So entsteht ein innovatives Spannungsfeld, in dem Technologie und menschliches Wissen gemeinsam die Zukunft der Chemie gestalten.

Die Grenzen zwischen maschineller und menschlicher Intelligenz werden zunehmend verwischt – und genau darin liegt ein großes Potenzial für die wissenschaftliche Entdeckung von morgen.