Die rapide Entwicklung großer Sprachmodelle (Large Language Models, LLMs) wie GPT, BERT und anderer KI-basierter Systeme hat die technologische Landschaft und damit auch das Site Reliability Engineering (SRE) nachhaltig verändert. Die traditionelle SRE-Perspektive basierte bisher auf etablierten Metriken wie Verfügbarkeit, Latenz und Fehlerquoten. Doch in einer Welt, in der KI-Systeme immer stärker in geschäftsrelevante Prozesse integriert werden, genügt das herkömmliche Monitoring nicht mehr. Die Zukunft von SRE hängt zunehmend vom tiefen Verständnis und der effektiven Evaluierung von LLM-Metriken ab. Ohne diese Fähigkeit droht nicht nur ein technologischer Rückstand, sondern auch das Risiko, gravierende Leistungs- und Sicherheitsprobleme zu übersehen.

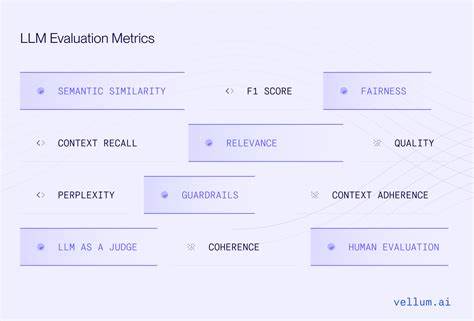

Dieses Szenario macht klar, warum SRE-Teams heute schon den nächsten Schritt gehen und sich intensiver mit dem Thema LLM Evaluation auseinandersetzen müssen. Die Integration von LLMs in produktive Systeme bringt neue Herausforderungen mit sich, die weit über die klassischen Metriken hinausgehen. Ein Sprachmodell generiert keine festen Outputs; seine Leistung ist probabilistisch und schwankt je nach Kontext und Anwendungsfall. Deshalb muss SRE 2.0 neue, spezialisierte Metriken verstehen, die nicht nur technische Aspekte erfassen, sondern auch Qualität, Kohärenz sowie ethische und sicherheitsrelevante Faktoren bewerten.

Dazu zählen unter anderem Maßzahlen für Genauigkeit, Kontextverständnis, Bias-Detektion, Fehlerarten und Robustheit gegenüber adversarialen Eingaben. Ohne gezielte Messstrategien wird die Überwachung von LLM-Systemen zu einem Blackbox-Problem mit potenziell katastrophalen Folgen für die Systemstabilität und Nutzerzufriedenheit. Die Notwendigkeit, LLM-Metriken zu adaptieren, wird auch durch den ständig steigenden Einsatz von KI in kritischen Geschäftsbereichen verstärkt. Firmen setzen zunehmend auf KI-gesteuerte Chatbots, automatisierte Entscheidungsunterstützung, Content-Erstellung und vieles mehr. Die Zuverlässigkeit dieser Systeme hat direkten Einfluss auf Kundenbindung, Sicherheit und den Ruf des Unternehmens.

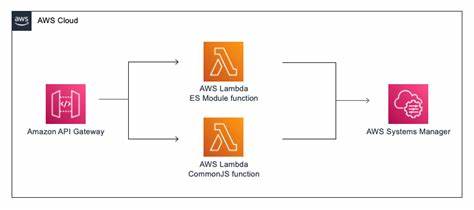

Site Reliability Engineers stehen nun vor der Aufgabe, nicht mehr nur Netzwerk- und Systemparameter zu messen, sondern auch die semantische und funktionale Qualität der KI-Ausgaben einzuschätzen. Dabei spielen insbesondere messbare Kennzahlen zu Fehlerraten, Generierungsqualität und Reaktionszeit eine wichtige Rolle. SRE-Teams müssen hierfür eng mit Data Scientists und ML-Experten zusammenarbeiten, um sinnvolle Metriken auszuwählen und in bestehende Monitoring-Pipelines zu integrieren. Die praktische Implementierung einer LLM-Metrik-Strategie erfordert zudem eine Erweiterung der Tooling-Landschaft. Klassische Überwachungssysteme wie Prometheus, Grafana oder ELK Stack bieten zwar eine gute Basis, können aber die komplexen Anforderungen von KI-Modellen nur eingeschränkt abdecken.

Innovative Lösungen, die speziell auf ML-Modelle zugeschnitten sind, gewinnen deshalb zunehmend an Bedeutung. Diese ermöglichen die automatische Erfassung von Qualitätsindikatoren, die Analyse von Verhaltensabweichungen im laufenden Betrieb und das frühzeitige Erkennen von Konzeptdrift. Für ein nachhaltiges SRE 2.0 ist die Kombination traditioneller Observability-Mechanismen mit fortschrittlichen LLM-spezifischen Monitoring-Tools unabdingbar. Ein weiterer relevanter Aspekt ist die Sicherheit und Governance im Umgang mit LLM-Systemen.

Hochentwickelte KI-Modelle können nicht nur durch ungenaue Daten oder Fehlkonfigurationen beeinträchtigt werden, sondern auch Ziel von Manipulationen wie Data Poisoning oder adversarialen Angriffen sein. Die Evaluierung von Sicherheitsmetriken für LLMs muss Teil des SRE-Verantwortungsbereichs werden. Hierzu zählen beispielsweise Hybridmetriken, die Performance und Angriffserkennung gleichzeitig erfassen, sowie Qualitätskontrollen, die konsequent die Vertrauenswürdigkeit der generierten Texte prüfen. Eine solche ganzheitliche Betrachtung von Stabilität, Qualität und Sicherheit ebnet den Weg für robuste KI-Systeme im produktiven Umfeld. Neben technischer und sicherheitsrelevanter Komplexität hat die Bewertung von LLMs auch eine ethische Dimension.

Bias und Diskriminierung in Sprachmodellen können schwerwiegende gesellschaftliche Folgen haben. Deshalb muss SRE 2.0 auch soziale Verantwortung im Rahmen von Evaluationsmetriken übernehmen. Die Integration von fairness-orientierten Indikatoren in Überwachung und Reporting schafft Transparenz und erlaubt gezielte Eingriffe bei problematischen Verhaltensweisen. Unternehmen profitieren dadurch nicht nur wirtschaftlich, sondern erfüllen gleichzeitig politische und regulatorische Vorgaben zunehmend selbstbestimmt.

Die Zukunftsfähigkeit moderner IT-Infrastrukturen hängt damit eng mit der Fähigkeit zusammen, LLM-Metriken aktiv zu messen, zu analysieren und darauf zu reagieren. SRE-Teams, die frühzeitig das Zusammenspiel von klassischem Systemmonitoring und KI-Performance-Messung verstehen, sichern sich einen technologischen Wettbewerbsvorteil. Darüber hinaus profitieren Organisationen von verbesserter Systemstabilität, höheren Servicequalitäten und nachhaltiger Compliance. Die Herausforderungen sind zwar groß, doch der Mehrwert eines ganzheitlichen SRE 2.0 ist beachtlich.