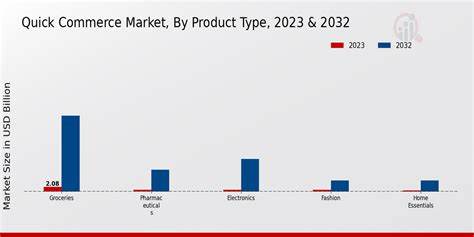

Im Zeitalter der Digitalisierung und schnellen Marktentwicklungen wird die Bedeutung von Daten für den Erfolg von Marken im Quick Commerce immer größer. Quick Commerce, oder auch Schnelllieferdienste bezeichnet, hat sich in den letzten Jahren rasant entwickelt und fordert Unternehmen dazu auf, schneller und flexibler als je zuvor auf Kundenwünsche und Marktveränderungen zu reagieren. In dieser dynamischen Umgebung sind Echtzeit-Daten und deren intelligente Analyse von zentraler Bedeutung, um Marken nicht nur relevant zu halten, sondern auch nachhaltig zu wachsen. Marken spielen eine entscheidende Rolle im Ökosystem des Quick Commerce. Eine breite und vielfältige Produktpalette ermöglicht es, verschiedene Kundenbedürfnisse optimal zu bedienen und gleichzeitig in mehreren Städten präsent zu sein.

Dabei fallen enorme Mengen an Daten an – von Produktansichten über verkaufte Einheiten bis hin zu regionalen Absatztrends. Millionen von Datenpunkten werden jeden Tag verarbeitet, was Unternehmen tiefe Einblicke in die Performance ihrer Produkte auf unterschiedlichen Märkten liefert. Die größte Herausforderung besteht dabei nicht in der Verfügbarkeit der Daten, sondern in deren Nutzbarkeit. Nur wenn Daten in verwertbare, handlungsorientierte Informationen umgewandelt werden, können Marken ihre Strategien effektiv anpassen. Hier kommt die Brand Analytics im Quick Commerce ins Spiel.

Diese Technologie wurde speziell entwickelt, um schnelle und intuitive Einblicke zu liefern. Marken können damit Trends erkennen, die Leistung ihrer Angebote optimieren und fundierte Entscheidungen in Echtzeit treffen. In einem so schnelllebigen Marktumfeld ergibt sich daraus ein entscheidender Wettbewerbsvorteil. Der Wunsch, Partnermarken mit Echtzeit-Einblicken zu versorgen, ohne dabei wichtige Details zu verwässern oder unnötige Verzögerungen zu verursachen, war treibende Kraft hinter der Entwicklung einer spezialisierten Analytics-Plattform. Diese Plattform bietet umfassende Daten, darunter Verkaufsentwicklungen, Lagerbestände, Suchtrends sowie die Conversion-Raten von Nutzern.

Auch die Performance auf Subkategorie-Ebene wird transparent dargestellt und ermöglicht so gezielte Optimierungen. In der Anfangsphase eines Start-ups ist Geschwindigkeit oft wichtiger als komplexe Technik. So setzte man zunächst auf PostgreSQL als Datenbanklösung, weil diese weit verbreitet und zuverlässig ist. Mit einigen Millionen Datensätzen war dieses System ausreichend für die ersten Analysen und zur Generierung von Feedback aus dem Kreis der ersten Partner. Die Datenbasis umfasste Umsätze, verkaufte Einheiten und ähnliche Kennzahlen auf Ebene von Marken, Städten und Produkten.

Im Hintergrund sorgt eine Analytics-Abteilung für die Verwaltung und Pflege der Datentabellen mithilfe von Databricks. Diese Kombination bietet einerseits die Flexibilität von Datennotebooks und andererseits die Skalierbarkeit für große Datenmengen. Databricks arbeitet mit Delta Lake als Speicherlösung zusammen, was eine sogenannte Lakehouse-Architektur ermöglicht – eine Kombination aus Data Lake und Data Warehouse, die effiziente Datenspeicherung und -abfragen gewährleistet. Das ursprüngliche Architekturmodell basierte auf mehreren Tabellen für Bestellungen, Imperssionen, Produktinformationen und anderen Daten, die zu einer einheitlichen Umsatztabelle zusammengeführt wurden. Diese Struktur, die an das Sternschema aus Data-Warehouse-Designs erinnert, diente als Grundlage für die Analyse.

Ein täglich ausgeführter Cron-Job sorgte für die Synchronisation der Daten in PostgreSQL, was schnell genug für erste Zwecke war. Jedoch zeigte sich bald, dass sich die Anforderungen rasant entwickelten. Immer mehr Marken starteten die Nutzung der Plattform, das Produktangebot wuchs exponentiell und die Nutzer auf der Plattform vermehrten sich drastisch. Die Zahl der Datensätze stieg auf über 200 Millionen an, wodurch die damals eingesetzte Datenbank an ihre Grenzen stieß. PostgreSQL ist primär für Online Transaction Processing (OLTP) optimiert und konnte die komplexen analytischen Abfragen nicht mehr zuverlässig und schnell ausführen.

Aus diesem Grund entschied man sich für den Wechsel zu einem speziellen Online Analytical Processing (OLAP)-System, das für schnelle Analyse großer Datensätze konzipiert ist. Die Suche nach einem geeigneten System führte zu einer Bewertung verschiedener Technologien, darunter ClickHouse, Apache Pinot und StarRocks. Während ClickHouse bei Geschwindigkeit punktete, hatte es kleine Schwächen bei komplexen Joins. Apache Pinot punktete mit niedriger Latenz beim Datenimport, zeigte jedoch Grenzen bei komplexen Abfragen. StarRocks erfüllte alle Anforderungen und überzeugte durch besonders effiziente Join-Operationen, schnelle Antwortzeiten und einfache Integration in bestehende Datenpipelines.

StarRocks bietet eine außergewöhnlich schnelle Verarbeitung großer Datenmengen, mit P99-Latenzen unter 500 Millisekunden bei über 300 Millionen Datensätzen. Dies macht es möglich, Benutzern von Analyse-Dashboards nahezu in Echtzeit Ergebnisse zu liefern, was im Quick Commerce elementar ist. Die Integration von StarRocks erfolgt über native Schnittstellen zu Kafka und S3, was den Datenimport aus bestehenden Quellen wie Databricks und Echtzeit-Streaming aus Kafka vereinfachte. Zwei Hauptmethoden kommen zum Einsatz: Pipe Load lädt Parquet-Dateien aus einem S3-Bucket kontinuierlich in StarRocks, während Routine Load für das Streaming aus Kafka verwendet wird. In der Praxis hat sich die Shared-Nothing-Architektur von StarRocks als ideal erwiesen.

Dabei werden Daten lokal gespeichert und verarbeitet, was zu einer spürbaren Reduktion der Latenz führt. Für Datenvolumina im niedrigen zweistelligen Terabytebereich ist diese Lösung performant genug, um den Anforderungen des Quick Commerce gerecht zu werden. Die Pipeline zur Echtzeit-Analyse umfasst mehrere Schritte. Eingehende Events, die täglich über 60.000 pro Sekunde erreichen, werden von einer Unternehmensplattform verarbeitet, die für hohe Skalierbarkeit ausgelegt ist.

Anschließend übernimmt Apache Flink die Echtzeit-Verarbeitung und Aggregation der Ereignisse in kurzen Zeitfenstern, was eine effiziente Speicherung und Abfrage ermöglicht. Die aggregierten Daten werden in einem Ziel-Kafka-Topic hinterlegt, von wo StarRocks sie nahezu verzögerungsfrei übernimmt. Das Ergebnis ist ein Analytics-System, das es Marken ermöglicht, Verkaufszahlen, Nutzerinteraktionen und andere wichtige KPIs mit nahezu Echtzeit-Genauigkeit einzusehen. Diese Transparenz und Schnelligkeit erlaubt eine schnellere Reaktion auf Marktveränderungen, ein besseres Bestandsmanagement und präzise Marketing-Entscheidungen. Der Übergang von tagesaktuellen auf nahezu Echtzeit-Datenanalysen hat die Planungsqualität und die Wettbewerbsfähigkeit der Marken auf der Plattform deutlich verbessert.

Es vereinfacht die Identifikation von aufkommenden Trends und hilft, auf Nachfrageveränderungen proaktiv zu reagieren. Erfolgreiche Marken nutzen diese Daten, um Sortimente sinnvoll zu erweitern, Werbekampagnen gezielter zu steuern und den Kundenservice zu verbessern. Letztlich zeigen die Erfahrungen mit der modernen Datenarchitektur, wie wichtig es ist, die richtigen Technologien in einem sich schnell entwickelnden Markt frühzeitig einzusetzen. Die Kombination aus stabilen Datenpipelines, leistungsfähigen Verarbeitungssystemen und intuitiven Analysewerkzeugen bildet die Basis für nachhaltigen Erfolg im Quick Commerce. Für die nähere Zukunft sind weitere Optimierungen geplant.

Neben vertiefenden Benchmark-Studien und der Lösung technischer Herausforderungen, stehen auch Verbesserungen in der Datenworkflow-Effizienz und der Nutzererfahrung auf der Agenda. Unternehmen, die diese Entwicklungen aufmerksam verfolgen und umsetzen, sichern sich einen festen Platz in einem zukünftigen digitalen Einzelhandel, in dem Tempo und präzise Informationen über Erfolg oder Misserfolg entscheiden. Insgesamt zeigen die praxisnahen Ansätze für datengetriebene Echtzeit-Einblicke, wie bahnbrechend moderne Datenarchitekturen den Marken im Quick Commerce den Weg ebnen. Die kontinuierliche Arbeit an skalierbaren, performanten und intelligenten Systemen wird auch künftig die Schlüsselrolle für Wachstum und Spitzenpositionen im Markt spielen.

![Nvidia CEO Huang Says UK in 'Goldilocks' Position for AI [video]](/images/610C0C2A-C44B-4E72-A7E2-13CF3C62E207)