In den letzten Jahrzehnten hat die Künstliche Intelligenz (KI) enorme Fortschritte gemacht und ist in vielen Lebensbereichen zu einem unverzichtbaren Werkzeug geworden. Doch trotz dieser Fortschritte bleibt ein zentrales Anliegen die Interpretierbarkeit und Sicherheit solcher Systeme. Der jüngste Artikel „Google Eats Rocks, A Win for A.I. Interpretability and Safety Vibe Check“ der New York Times thematisiert genau diese Herausforderungen und Errungenschaften im Bereich der KI, insbesondere wie Google an den Lösungen arbeitet, die für mehr Transparenz und Sicherheit sorgen.

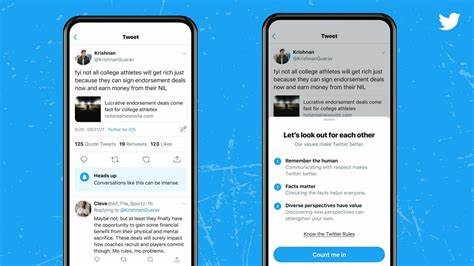

Die Aktualisierung der KI-Modelle von Google spiegelt ein wachsendes Bewusstsein in der Tech-Branche wider. Immer mehr Unternehmen erkennen, dass künftige Entwicklungen nicht nur leistungsstark, sondern auch transparent und nachvollziehbar sein müssen. Dies bedeutet, dass nicht nur die Ergebnisse eines KI-Modells wichtig sind, sondern auch die Entscheidungsprozesse, die zu diesen Ergebnissen führen. KI-Modelle, die als „Black Boxes“ fungieren, haben in der Vergangenheit Bedenken hinsichtlich der Fairness, ethischen Nutzung und Verantwortung aufgeworfen. Wenn ein System nicht erklärt werden kann, kann es Misstrauen und, im schlimmsten Fall, Missbrauch hervorrufen.

Der Artikel hebt hervor, dass die neuen Entwicklungen von Google darauf abzielen, diese Black-Box-Natur der Künstlichen Intelligenz zu schließen. Durch die Einführung von Technologien zur besseren Erklärung und Nachvollziehbarkeit von Daten und Ergebnissen will Google sicherstellen, dass sowohl Entwickler als auch Endanwender ein besseres Verständnis dafür haben, wie Entscheidungen getroffen werden. Dies ist besonders wichtig in kritischen Bereichen wie dem Gesundheitswesen, der Strafrechtspflege und im Finanzwesen, wo falsche Entscheidungen erhebliche negative Auswirkungen haben können. Ein weiterer wichtiger Punkt, der in der New Yorker Times thematisiert wird, ist die Rolle der Künstlichen Intelligenz in der Gesellschaft. Während kommerzielle Anwendungen von KI oft im Mittelpunkt stehen, gibt es auch ethische und gesellschaftliche Fragen, die geklärt werden müssen.

Die Sicherheitsvorkehrungen, die Google implementiert, sollen dazu beitragen, KI-Modelle weniger anfällig für manipulierte Daten oder Angriffe zu machen. In einer Welt, die zunehmend von digitalen Entscheidungen abhängig ist, ist es unerlässlich, die Integrität und Sicherheit dieser Systeme zu gewährleisten. Die Entwicklungen bei Google sind Teil eines breiteren Trends in der Technologiebranche. Unternehmen setzen zunehmend auf KI-Interpretationswerkzeuge, um Transparenz zu gewährleisten und die Benutzerfreundlichkeit zu fördern. Diese Werkzeuge bieten Einblicke in die Daten, die von KI-Modellen verarbeitet werden, und ermöglichen es den Nutzern, den Entscheidungsprozess nachzuvollziehen.

Darüber hinaus wird in dem Artikel auch auf die Relevanz und Auswirkungen solcher Technologien auf die Zukunft der Arbeit eingegangen. Mit der Einführung von interpretierbaren KI-Modellen können Unternehmen effizientere Arbeitsmethoden entwickeln, die nicht nur produktiv sind, sondern auch die Zusammenarbeit zwischen Mensch und Maschine fördern. Die Koexistenz von Mensch und KI könnte künftig harmonischer gestaltet werden, da eine Interpretation und Erklärung der KI-Entscheidungen die Akzeptanz der Technologie in verschiedenen Sektoren erhöhen könnte. Aber nicht nur die Unternehmen profitieren von diesen Fortschritten. Auch die Verbraucher werden durch sicherere und transparentere Systeme begünstigt.