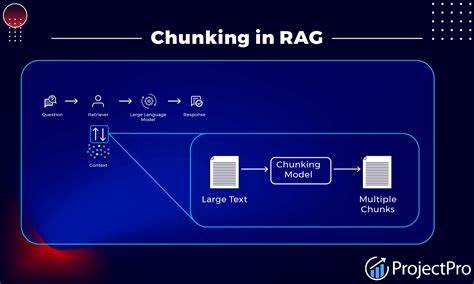

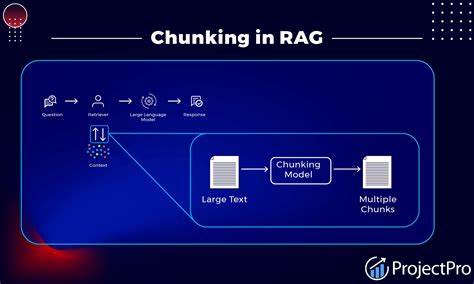

Retrieval-Augmented Generation, kurz RAG, ist eine wegweisende Technologie, die die Stärken großer Sprachmodelle mit effizienten Informationsabrufmethoden kombiniert. Der Kern nahezu jedes RAG-Systems liegt in der Art und Weise, wie die zugrunde liegenden Dokumente verarbeitet und in handhabbare Abschnitte, sogenannte Chunks, zerlegt werden. Die Entwicklung und Auswahl der richtigen Chunking-Strategie kann dabei über den Erfolg oder Misserfolg eines Projekts entscheiden. Doch wie kann man die vielen unterschiedlichen Ansätze vergleichen und bewerten, um die passende Methode für den jeweiligen Anwendungsfall zu finden?Chunking bezeichnet im Kontext von RAG die Zerlegung großer Textbestände in kleinere Segmente, die dann als Kontext für die Antwortgenerierung dienen. Obwohl viele Entwickler davor zurückschrecken, viel Zeit in dieses Detail zu investieren und stattdessen auf immer größere Kontextfenster von Modellen setzen, ist Chunking nach wie vor unverzichtbar.

Der Grund liegt darin, dass die meisten Modelle, trotz wachsender Kontextlängen, bestimmte Grenzen haben und zu lange oder zu unspezifische Textabschnitte eher negative Auswirkungen auf die Qualität der generierten Antworten haben können.Bei der Evaluierung von Chunking-Strategien gilt es, äußerst systematisch vorzugehen. Denn die oft geäußerte Meinung, man könne einfach erraten, welcher Ansatz am besten funktioniert, führt nicht selten dazu, dass wertvolle Zeit und Budgets verschwendet werden. Stattdessen empfiehlt sich ein strukturierter Prozess, welcher mit einer repräsentativen Stichprobe der vorhandenen Dokumente beginnt. Gerade in produktiven Umgebungen, wo häufig mehrere hundert Gigabyte an Daten vorliegen, ist es schlicht nicht praktikabel oder sinnvoll, alle Daten für Tests heranzuziehen.

Die Stichprobe sollte so gewählt werden, dass sie alle wichtigen Dokumententypen und -kategorien umfasst, um Rückschlüsse auf die Gesamtstruktur ziehen zu können.Im nächsten Schritt ist es notwendig, geeignete Testfragen vorzubereiten. Diese dienen als Prüfstein für die Leistungsfähigkeit der einzelnen Chunking-Methoden. Hier zeigt sich die Bedeutung menschlicher Expertise, denn idealerweise sollte ein Fachmann die Fragen inhaltlich erstellen. Ist dies nicht möglich, bieten moderne große Sprachmodelle eine wertvolle Unterstützung, indem sie aus den ausgewählten Dokumenten selbst Fragen generieren können.

Wichtig hierbei ist, ein Modell mit ausgeprägten logischen Fähigkeiten zu wählen, um die Qualität der Fragen sicherzustellen. Ein bewährter Ansatz ist es, kurze Ausschnitte der Dokumente zu extrahieren und darauf basierend eine Vielfalt von Fragen zu erzeugen, die unterschiedliche Aspekte der Texte abdecken.Hat man diese Grundlage geschaffen, beginnt die eigentliche Evaluierung. Dabei wird jede Chunking-Strategie auf die zuvor ausgewählten Dokumente angewandt, um daraus Chunks zu erstellen. Die Art und Weise des Chunkings kann stark variieren – von festen Zeichen- oder Wortgrenzen über semantische Ansätze, die inhaltliche Kohärenz einbeziehen, bis hin zu agentenbasierten oder clusteringbasierten Methoden.

Mit den entstandenen Chunks wird ein Vektor-Datenbankindex aufgebaut. Dieser ermöglicht die schnelle und effiziente Ähnlichkeitssuche bei Anfragen.Wichtig für die Bewertung sind verschiedene Kennzahlen. Dazu zählen unter anderem die Relevanz der Antworten, ihre Wahrhaftigkeit, die Präzision und Vollständigkeit des verwendeten Kontextes sowie die Korrektheit der bereitgestellten Antworten. Diese Metriken können mit Hilfe spezialisierter Frameworks, wie beispielsweise RAGAS, automatisiert erfasst und gewichtet werden, um ein Gesamtbild der Leistungsfähigkeit zu erhalten.

Ergänzend zur Qualität sind auch quantitative Faktoren wie die durchschnittliche Chunkgröße, Anzahl der Chunks und die Dauer von Abruf- und Generationsprozessen entscheidend. Solche Werte helfen dabei, Einschätzungen hinsichtlich Performance, Kosten und Umsetzungstauglichkeit zu treffen.Die Visualisierung der Evaluationsergebnisse stellt ein unverzichtbares Werkzeug dar, um fundierte Entscheidungen zu treffen. Von einer einfachen Rangordnung, welche Strategie am besten abschneidet, bis hin zu detaillierten Analysen über Chunkgrößenverteilung und Zeitaufwände für verschiedene Prozessschritte. Insbesondere Radar-Diagramme bringen einzelne Metriken zusammen und machen abhängig von den Anforderungen des Projekts deutlich, welche Aspekte priorisiert werden sollten.

So können etwa Anwendungen mit strengen Anforderungen an Fakten-Treue eine andere Strategie bevorzugen als Systeme, bei denen Schnelligkeit oder Relevanz im Vordergrund stehen.Die Praxis zeigt, dass keine einzelne Chunking-Methode universell optimal ist. So haben beispielsweise einfache feste Chunkgrößen oft eine hohe Relevanz und gute Verarbeitungsgeschwindigkeit, können aber unter Umständen zu großen Chunks führen, die das Kontextfenster schnell auffüllen. Semantische Chunking-Verfahren liefern häufig bessere inhaltliche Kohärenz, sind aber performanceintensiver. Recursive oder agentenbasierte Ansätze finden oft eine gute Balance, erfordern aber mehr Entwicklungsaufwand.

Kosten-Nutzen-Analysen und konkrete Anwendungsfälle müssen deshalb stets berücksichtigt werden.Ein wichtiger Aspekt, der in vielen Projekten unterschätzt wird, ist die Qualität der Samplingstrategie zu Beginn. Nur mit einer ausreichend gut gewählten Stichprobe lassen sich verlässliche Schlüsse ziehen. Stratifiziertes Sampling bietet sich an, um unterschiedliche Dokumenttypen angemessen zu repräsentieren. Dadurch wird verhindert, dass beispielsweise eher kleine und unstrukturierte Meeting-Transkripte überproportional Einfluss auf die Bewertung erhalten und dadurch das Ergebnis verzerren.

Gerade bei heterogenen Datenbeständen sichert dies eine fundierte Entscheidungsbasis.Im praktischen Workflow empfiehlt es sich, die Evaluierung automatisiert und reproduzierbar aufzusetzen. Mit Tools wie Langchain zur Pipelineerstellung, ChromaDB als Vektordatenbank und RAGAS für die Metriken können verschiedene Strategien mit gleichem Setup verglichen werden. Eine konsequente Bereinigung der Umgebung vor jedem Test, etwa durch das Löschen der Datenbank-Collections, verhindert unerwünschte Beeinflussungen. Automatisierte Berichte und Dashboards ermöglichen ein schnelles Erkennen erfolgreicher Kombinationen und solcher, die weniger geeignet sind.

Neben objektiven Kennzahlen sollte auch der Betrieb und die Skalierbarkeit berücksichtigt werden. Wenn eine Chunking-Methode herausragende Ergebnisse liefert, aber zu lange dauert oder zu hohen Ressourcenverbrauch erfordert, kann sie in der Produktion schnell unpraktisch werden. Hier gilt es, Kompromisse zu finden, womöglich durch eine Kombination aus schneller Chunking-Methode mit nachgelagerter, präziserer Re-Ranking-Phase. So lassen sich hohe Qualität mit akzeptabler Performance verbinden.Schließlich bleibt der Faktor Updates.

Dokumente ändern sich, neue Datenquellen kommen hinzu, und Anforderungen entwickeln sich weiter. Evaluierungen der Chunking-Strategien sollten deshalb als wiederkehrender Prozess verstanden werden. Periodische Neubewertungen und Anpassungen an geänderte Rahmenbedingungen garantieren, dass das RAG-System dauerhaft effektiv und effizient bleibt.Zusammenfassend lässt sich festhalten, dass das Evaluieren von Chunking-Strategien für RAG keine triviale Aufgabe ist, sondern einen durchdachten, mehrstufigen Prozess erfordert. Mit der richtigen Methodik – von repräsentativer Stichprobenahme über automatisierte Fragengenerierung bis hin zur umfassenden Bewertung der Qualität und Performance – gelingt es, datengestützte Entscheidungen zu treffen.

Nur so lässt sich das volle Potenzial von RAG-Systemen ausschöpfen und der Nutzer mit präzisen, schnellen und verlässlichen Antworten versorgen. Das Herzstück der Technologie – das Chunking – verdient damit besondere Aufmerksamkeit und kontinuierliche Optimierung, um das bestmögliche Ergebnis in der Praxis zu erzielen.