Die Welt der Big Data entwickelt sich rasant und erfordert immer ausgeklügeltere Ansätze, um Datenmengen effizient zu verarbeiten. Unternehmen stehen vor der Herausforderung, ihre Big Data Workloads so zu dimensionieren, dass Ressourcen optimal genutzt werden und zugleich Performance und Kosten im Gleichgewicht bleiben. Dabei spielen wesentliche Kennzahlen eine zentrale Rolle, um eine fundierte Architekturentscheidung treffen zu können und Engpässe frühzeitig zu identifizieren. Beim Sizing von Big Data Workloads geht es im Kern darum, die benötigten Ressourcen an Compute-Kapazität, Speicherplatz und IO-Leistung passend zum jeweiligen Anwendungsfall zu bestimmen. Jedes Projekt weist dabei unterschiedliche Anforderungen auf – sei es die Verarbeitung von hundert Milliarden Events in einem System mit Kafka, das Schreiben dieser Daten in skalierbare Objektspeicher wie Amazon S3, oder der Fokus auf Echtzeit-Abfragen bei geringeren Datenvolumen.

Die Dimensionierung einer solchen Umgebung basiert daher auf einem Verständnis der zugrundeliegenden Workloads und deren charakteristischen Metriken. Ein bewährter Ansatz ist es, eine Referenzinstanz heranzuziehen, die exemplarisch eine typische Big Data Aufgabe abbildet. Im professionellen Umfeld hat sich beispielsweise ein 64 vCPU AWS Graviton-Server als solide Basis erwiesen. Diese Instanz bietet eine gute Balance zwischen Rechenleistung, Arbeitsspeicher und Speicheranbindung. Doch allein die Anzahl der virtuellen CPU-Kerne oder der Speicherplatz reichen nicht aus, um die Leistung genau abzuschätzen.

Ebenso entscheidend sind die Identifikation der Flaschenhälse, die den gesamten Prozess stark beeinträchtigen können – seien es I/O-Beschränkungen, Netzwerklatenzen oder Speicherzugriffe. Storage ist eine besondere Herausforderung im Big Data Kontext. Gerade bei der Arbeit mit Objektspeichern wie S3 ist nicht nur die Kapazität von Bedeutung, sondern auch die Effizienz, mit der Daten gelesen und geschrieben werden können. Große Datenmengen, die beispielsweise in Terabyte gemessen werden, erfordern eine passende Infrastruktur, die einerseits kosteneffizient ist und andererseits schnelle Abfragen ermöglicht. Dabei stellt sich die Frage, ob Daten eher sequentiell verarbeitet oder häufig randomisiert abgefragt werden.

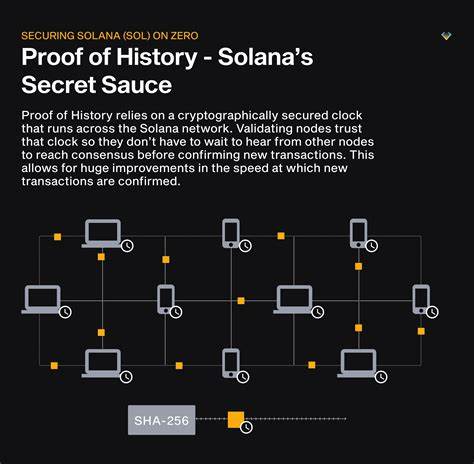

Die Speichermedien und deren Schnittstellen müssen auf diese Anforderungen sorgfältig abgestimmt sein. Ein weiterer kritischer Aspekt ist die Ein- und Ausgabe (I/O). In vielen Big Data Use Cases werden Datenströme in Echtzeit verarbeitet, was minimale Latenzen und hohe Durchsatzraten zur Folge hat. Zum Beispiel kann der kontinuierliche Ingest von Milliarden von Ereignissen pro Tag enorme Anforderungen an die Netzwerk- und Speicherhardware stellen. Die Implementierung von Systemen wie Kafka als Messaging-Lösung ist weit verbreitet, um diese Anforderungen zu bedienen.

Dabei darf nicht übersehen werden, dass die reine Rechnerleistung ohne adäquate I/O-Kapazitäten nicht zu den gewünschten Ergebnissen führt. Der Kostenfaktor spielt selbstverständlich ebenfalls eine maßgebliche Rolle. Die Dimensionierung von Big Data Systemen sollte nicht nur auf Leistungskennzahlen basieren, sondern auch die wirtschaftliche Komponente berücksichtigen. Insbesondere in Cloud-Umgebungen, in denen Ressourcen nutzungsabhängig abgerechnet werden, gilt es eine Balance zu finden. Zu überspezifizierte Systeme führen zu unnötigen Kosten, während eine zu klein dimensionierte Architektur Performanceprobleme und Skalierungsengpässe mit sich bringt.

Die Praxis zeigt, dass ein Allheilmittel für die Dimensionierung von Big Data Workloads nicht existiert. Vielmehr empfiehlt es sich, Benchmarks und Tests auf dem jeweiligen Datensatz und Anwendungsszenario durchzuführen. Nur so lassen sich wirklich belastbare Aussagen treffen und eine solide Grundlage für die finale Architektur schaffen. Dies ist besonders wichtig, da sich Technologien und verfügbare Instanztypen fortlaufend weiterentwickeln und sich damit auch die optimalen Parameter immer wieder verändern. Darüber hinaus entwickelt sich auch die Hardwarelandschaft ständig weiter.

Neben klassischen EBS-Volumes stehen mittlerweile schnellere NVMe-Interfaces zur Verfügung, die speziell für datenintensive Prozesse optimiert sind. Die Wahl zwischen diesen Speichermedien hängt stark vom Datenzugriffsmuster und der geplanten Skalierung ab. Ein ähnliches Bild zeigt sich bei den Instanztypen. Moderne CPU-Architekturen wie AWS Graviton bieten oft ein hervorragendes Preis-Leistungs-Verhältnis, weshalb sie im Big Data Umfeld zunehmend an Bedeutung gewinnen. Für Unternehmen ist es essenziell, ihre Big Data Workloads dynamisch an die sich ändernden Anforderungen anzupassen.

Ein statischer Ansatz kann schnell zu Ineffizienzen führen, wenn etwa ein Anstieg im Datenvolumen nicht rechtzeitig berücksichtigt wird. Cloud-basierte Infrastrukturen bieten hier den Vorteil, dass Ressourcen flexibel skaliert werden können – sowohl vertikal in Form stärkeren Rechenkapazitäten als auch horizontal durch Hinzufügen weiterer Knoten. Nicht zuletzt muss auch die Komplexität der Daten selbst in die Dimensionierungsüberlegung einfließen. Unterschiedliche Datenformate, etwa strukturierte versus unstrukturierte Daten, sowie die Nutzung von Data Lakes oder Data Warehouses können unterschiedliche Anforderungen an Speicher und Verarbeitung stellen. Technologien wie Apache Iceberg vereinfachen zunehmend das Management großer Datensätze und ermöglichen es, das passende Compute-Umfeld gezielter auszuwählen.

Zusammenfassend lässt sich festhalten, dass die Schlüssel zum erfolgreichen Sizing von Big Data Workloads in einer ausgewogenen Betrachtung von Compute-Leistung, Speicheroptionen und I/O-Kapazitäten liegen. Ein ganzheitliches Verständnis des Workloads und seiner Anforderungen bildet die Grundlage für fundierte Architekturentscheidungen und effiziente Ressourcennutzung. Durch iterative Tests und kontinuierliche Anpassungen kann garantiert werden, dass Systeme nicht nur performant bleiben, sondern auch wirtschaftlich betrieben werden. In einer Zeit, in der die Datenmengen exponentiell wachsen und Unternehmen immer mehr auf datengetriebene Entscheidungen setzen, ist die richtige Dimensionierung von Big Data Workloads ein entscheidender Wettbewerbsvorteil. Es lohnt sich daher, in eine detaillierte Analyse zu investieren und stets die neuesten Technologien und Methoden in Betracht zu ziehen.

Nur so kann die volle Kraft der Daten effektvoll genutzt werden, um Innovationen voranzutreiben und nachhaltigen Erfolg zu sichern.