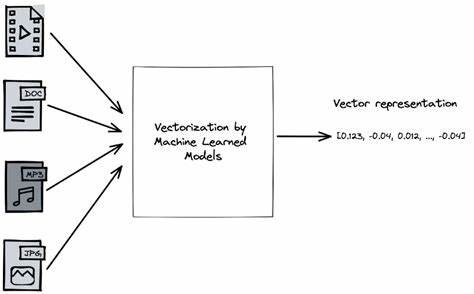

Machine Learning ist derzeit eine der aufregendsten und am schnellsten wachsenden Technologien in der Softwareentwicklung. Besonders das Training und die Berechnung von Modellen stellt eine enorme Herausforderung dar – nicht nur was Rechenleistung betrifft, sondern auch in puncto Effizienz des zugrundeliegenden Codes. Eine innovative Methodik, die immer mehr an Bedeutung gewinnt, ist die Vektorisierung der Modelle und Algorithmen. Doch was verbirgt sich hinter dieser Technik und warum kann die Umwandlung von skalaren Berechnungen in vektorbasierte Operationen wie Dot-Products oder Matrixmultiplikationen so großen Einfluss auf die Leistung haben? Hier beginnt die Reise in eine spannende Schnittstelle zwischen maschinellem Lernen und Compilertechnologie. Viele populäre Machine Learning Frameworks arbeiten auf Tensor-Ebene, importieren tief gestapelte Vektor- und Matrixoperationen in ihre Architektur und nutzen diese, um komplexe Berechnungen effizienter auszuführen.

Doch einige zugrundeliegende Systeme greifen für die kleinsten Operationen auf skalare Werte zurück – das bedeutet, dass Rechenoperationen wie Addition oder Multiplikation auf einzelne Zahlen angewendet werden, anstatt auf ganze Vektor- oder Matrizenstrukturen. Diese Herangehensweise hat den großen Nachteil, dass sie für komplexe, hochdimensionale Daten sehr ineffizient arbeitet. Die einzelnen Operationsknoten im Berechnungsgraphen sind fein säuberlich auf scalarer Ebene eingeteilt und das lässt sich meistens nur durch aufwändige manuelle Optimierungen verbessern. Der entscheidende Durchbruch in der Vorbereitung dieser skalaren Graphen für eine effizientere Ausführung liegt in der automatischen Vektorisierung beziehungsweise im sogenannten Autovectorization-Ansatz. Das Ziel ist es, alle einfachen Operationsknoten – insbesondere die zahlreichen Additions- und Multiplikationsoperationen – so zusammenzufassen, dass sie als umfangreichere Vektoroperationen auftreten.

Konkret bedeutet das, dass eine Kette verschachtelter Additionsoperationen, die häufig bei der Berechnung von Skalarprodukten vorkommt, zusammengefasst wird und als einzelner Dot-Product Knoten im Rechenablauf abgebildet werden kann. Diese Idee ist keineswegs brandneu, aber die Umsetzung in kleinen, übersichtlichen DSLs (Domain Specific Languages) oder minimalistischen Machine Learning Frameworks gestaltet sich als äußerst lehrreich. Wer etwa mit der minimalistischen "micrograd"-Bibliothek arbeitet, findet hier eine spannende Basis, um solche Optimierungen durchzuführen und das Verhalten im Rechengraphen direkt nachvollziehen zu können. "micrograd" verwendet ursprünglich eine Klasse namens Value, um skalare Rechenoperationen zu repräsentieren. Jede Operation – etwa eine Addition oder Multiplikation – ist ein Knoten in einem gerichteten azyklischen Graphen.

Das Problem: Diese Knoten sind extrem granular und spiegeln nicht die Vektoroperationen wider, wie wir sie von moderneren numerischen Bibliotheken kennen. Die Lösung ist die Einführung eines Algorithmus und einer Datenstruktur, die das Zusammenfassen von Operationen erlaubt, ohne den bisherigen Rechengraphen komplett neu aufbauen zu müssen. Dabei kommt die sogenannte Union-Find- oder Disjoint-Set-Datenstruktur zum Einsatz. Diese Struktur erlaubt es, Äquivalenzklassen von Knoten zu bilden und repräsentative Knoten auszuwählen, die für ganze Sets von ähnlichen Operationen stehen. Für die Optimierung bedeutet das konkret, dass sobald die Addition von mehreren Skalarprodukten oder verschachtelte Additionen im Graph erkennbar werden, man diese Knoten zu einem neuen, gemeinsam genutzten Knoten zusammenfassen kann.

Union-Find funktioniert hierbei, indem es für jede Operation einen Zeiger auf einen sogenannten Repräsentanten hält. Dieser Repräsentant steht für die optimierteste, bestmögliche Darstellung eines Äquivalenzsets. Wenn also zwei Knoten dieselbe, optimierte Repräsentation bekommen, werden sie über diesen Zeiger verbunden. Für den Programmierer bleibt so der ursprüngliche Rechengraph erhalten, gleichzeitig entsteht aber eine gemeinsame, abstrahierte Ebene von Vektoroperationen. Ein besonders eleganter Nebeneffekt dieser Technik ist, dass man endlich einen flachen Additionsbaum erhält, im Gegensatz zu einer verschachtelten tiefen Struktur.

Statt also etwa tausend Additionen hintereinander auszuführen, erkennt das System eine breite Addition über viele Elemente hinweg. So lässt sich beispielsweise ein Punktprodukt vieler Elemente nicht mehr als tiefe Verschachtelung aus Additionen und Multiplikationen darstellen, sondern als einzige Dot-Product-Operation mit zwei Vektorargumenten. Die Ausführung auf modernen Hardwarearchitekturen profitiert dadurch enorm, da Vektorberechnungen und SIMD (Single Instruction, Multiple Data) Operationen deutlich effizienter sind. Der Schritt von skalaren Werten zu Vektoroperationen ist in Micrograd durch die Einführung einer neuen Klasse namens Array repräsentiert. Diese Klasse stellt die Verbindung zwischen einzelnen Wertknoten und Vektoren her und markiert die Daten als Erstklassige Objekte für vektorbasierte Berechnungen.

Zusammen mit einer Dot-Klasse, die explizit das Punktprodukt darstellt, wird der Rechengraph so um eine neue Operationsebene erweitert. Diese erweitert die Kompaktheit des Graphen deutlich und senkt die Anzahl der nötigen Operationsknoten um ein Vielfaches. Doch warum ist das so wichtig? Denn maschinelles Lernen, speziell das Training von neuronalen Netzen, basiert auf unzähligen Matrixmultiplikationen und Vektoroperationen. Gerade beim Durchlauf von Netzwerken mit versteckten Schichten oder bei der Rückpropagation werden unzählige einzelne Additions- und Multiplikationsoperationen ausgeführt. Wenn diese skalaren Operationen unoptimiert übereinander liegen, entsteht ein riesiger Graph mit möglichst vielen Knoten.

Eine automatische Vektorisierung sorgt nicht nur für eine radikale Reduktion der Komplexität solcher Graphen, sondern auch für deutlich schnellere Ausführung durch besser genutzte Hardwarekapazitäten. Ein weiterer schöner Aspekt des vorgestellten Verfahrens ist, dass es die Umwandlung nicht invasiv, sondern über Weiterleitungen und Äquivalenzklassen realisiert. So bleibt die Möglichkeit erhalten, alte Graphenstrukturen beizubehalten oder sogar unterschiedliche Optimierungslevel gleichzeitig vorzuhalten. Das ist besonders für experimentelle Einstellungen und der Entwicklung eigener Optimierungsalgorithmen ein großer Vorteil. Darüber hinaus eröffnet diese Herangehensweise spannende Perspektiven für zukünftige Forschungsbereiche.

Eine davon betrifft die automatische Herleitung von Backpropagation-Schritten. Aktuell müssen solche Ableitungsfunktionen für neue Operationen, wie etwa den Dot-Product, noch manuell definiert werden. Im Rahmen einer tieferen Integration von Compilertechniken könnte es gelingen, komplexe Ableitungen von Vektoroperationen automatisch zu generieren und dadurch Fehlerquellen zu minimieren sowie den Entwicklungsaufwand zu senken. Auch die Idee, Dot-Produkte noch weiter zu komplexeren Matrixmultiplikationen (Matmul) umzuwandeln, bietet enormes Potenzial. Matrixmultiplikationen sind der Kern von vielen neuronalen Netzwerkarchitekturen und damit eine der wichtigsten und meistrechnerisch aufwendigen Operationen überhaupt.

Optimiert man die Graphen so, dass viele Dot-Produkte zu einer einzigen Matmul-Operation zusammengefasst werden können, ergeben sich weitere Effizienzgewinne. Neben der reinen Softwareoptimierung ist das Scheduling von Operationen auf der CPU oder GPU ein weiterer wichtiger Punkt. Auch wenn moderne Prozessoren SIMD-Befehle bereitstellen, ist es nicht trivial, diese optimal auszunutzen. Komplexe Graphoptimierungen und Schedulingalgorithmen, potentiell umgesetzt mithilfe von e-Graphen, könnten das Herausholen dieser Hardwareleistung erheblich vereinfachen und beschleunigen. Die praktische Anwendung der vorgestellten Konzepte zeigt beeindruckende Erfolge.

Beispielsweise konnte die Anzahl der Additionsknoten in einem modellhaften neuronalen Netz von rund 39.000 auf nur noch etwa 51 reduziert werden. Eine drastische Reduzierung, die demonstriert, wie ertragreich Vektorisierungs- und Union-Find-basierte Optimierungen sein können. Dies wirkt sich nicht nur auf die Geschwindigkeit aus, sondern auch auf Speicherbedarf und Wartbarkeit der Modelle. Jedoch sollte man stets kritisch reflektieren, wie Machine Learning eingesetzt wird.

Die Optimierung der zugrundeliegenden Rechenmodelle dient dazu, den Nutzern echte, praktische Vorteile zu bringen – höhere Geschwindigkeit, geringere Kosten, verbesserte Genauigkeit. Es gilt, Ansätze zu favorisieren, die realen Problemen dienen und ethisch verantwortungsvoll umgesetzt werden. Abschließend lässt sich festhalten, dass im Zusammenspiel von Compilertechniken und Machine Learning noch viel ungehobenes Potenzial steckt. Die Integration von optimierenden Datenstrukturen wie Union-Find, graphbasierten Transformationen und Vektorisierung ist ein Schritt in diese Richtung. Wer die Grenzen traditioneller, skalarer Berechnungen sprengen will, findet in diesen Methoden einen neuen und effektiven Weg, um Machine Learning Modelle nicht nur schneller, sondern auch eleganter und besser skalierbar zu gestalten.

Die Zukunft der ML-Optimierung wird vermutlich davon geprägt sein, wie gut wir es schaffen, solche niedrigen, skalaren Rechenoperationen hochzuskalieren, zu abstrahieren und flexibel auf verschiedene Hardwarearchitekturen zu adaptierten. Erste experimentelle Ansätze wie in Micrograd legen den Grundstein, doch viele spannende Forschungsfragen bleiben noch offen. Es bleibt also spannend, wie und wo sich solche autovektorisierten Ansätze in kommerziellen und wissenschaftlichen Frameworks bald etablieren werden.