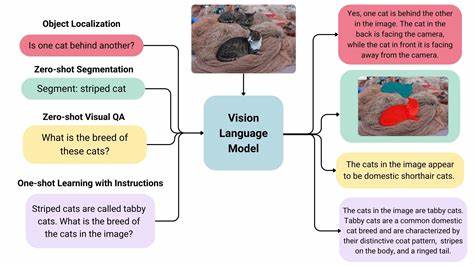

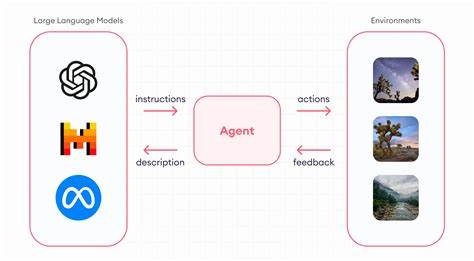

In der schnelllebigen Welt der Künstlichen Intelligenz (KI) spielt die Integration von visuellen und sprachlichen Informationen eine immer bedeutendere Rolle. Vision Language Modelle (VLMs) ermöglichen es, Bilder und Texte miteinander zu verknüpfen und so komplexe Aufgaben wie Bildbeschreibung, visuelle Fragebeantwortung und multimodale Inhalte zu meistern. Apple hat mit FastVLM eine innovative Lösung entwickelt, die nicht nur die Genauigkeit, sondern vor allem die Geschwindigkeit der Bildverarbeitung bei Vision Language Modellen erheblich verbessert. Diese neue Technologie setzt neue Maßstäbe für Effizienz und Performance und könnte die Art und Weise, wie Geräte mit visuellen Daten umgehen, grundlegend verändern. FastVLM zeichnet sich insbesondere durch einen neuartigen hybriden Vision Encoder aus, das FastViTHD, der darauf ausgelegt ist, weniger Tokens zu generieren und somit die Kodierungszeit von hochauflösenden Bildern drastisch zu reduzieren.

Dies führt zu einer wesentlichen Beschleunigung der Zeit bis zum ersten Token (Time-to-First-Token, TTFT), die bei den kleinsten Modellen um den Faktor 85 schneller ist als bei vergleichbaren Lösungen. Zudem ist der eingesetzte Vision Encoder um das 3,4-fache kleiner, was die Ressourcennutzung optimiert und die Skalierbarkeit verbessert. Ein weiterer Pluspunkt ist die Kompatibilität mit leistungsstarken Sprachmodellen wie Qwen2-7B. Die größeren Varianten von FastVLM konnten so mit nur einem einzigen Bild-Encoder die Performance anderer fortgeschrittener Modelle wie Cambrian-1-8B übertreffen und dabei eine fast achtmal schnellere Zeit für die erste Ausgabe erreichen. Dies bedeutet, dass Anwendungen, die auf schnelle und präzise Bild-Text-Interaktionen angewiesen sind, mit FastVLM deutlich flüssiger und effizienter laufen können.

Neben den technischen Fortschritten hebt sich Apple durch praktische Demonstrationen auf mobilen Geräten hervor. Besonders bemerkenswert ist die Verfügbarkeit einer Demo-App für iOS, welche die Leistungsfähigkeit von FastVLM auf iPhone und iPad zeigt. Die Fähigkeit, hochqualitative Bild-Sprach-Verarbeitung direkt auf mobilen Geräten durchzuführen, ohne auf externe Server angewiesen zu sein, eröffnet völlig neue Möglichkeiten für den Alltag der Nutzer und für Entwickler, die mobile KI-Lösungen erstellen wollen. Die technische Basis von FastVLM baut auf dem bewährten LLaVA-Code auf, einem Framework, das bereits vielseitig in der Forschung und Entwicklung von Vision Language Modellen eingesetzt wird. Von dort aus wurden die Modelle weiter optimiert und ergänzt.

Für Interessierte und Entwickler stehen diverse Versionen von FastVLM in verschiedenen Größen zur Verfügung – von kleineren Modellen mit 0,5 Milliarden Parametern bis hin zu größeren mit 7 Milliarden Parametern. Die vortrainierten Checkpoints können unkompliziert heruntergeladen und in gängigen Machine-Learning-Umgebungen genutzt werden. Durch die Bereitstellung von Tools und Skripten zur Modellkonvertierung und -inferenz auf Apple Silicon ist gewährleistet, dass die Technologie perfekt auf die Hardware zugeschnitten ist, die in Apples Ökosystem eingesetzt wird. Dadurch lassen sich beispielsweise Mac-Computer mit M-Chips effizient für Deep Learning Aufgaben im Bereich Vision Language verwenden, was vor allem in Hinblick auf Energieeffizienz und Echtzeitanwendungen von großer Bedeutung ist. Die Bedeutung von FastVLM ist vor dem Hintergrund der stetig wachsenden Datenmengen und der Forderung nach schneller, präziser Verarbeitung kaum zu überschätzen.

Während viele bestehende Lösungen enorme Rechenressourcen benötigen und oft nur in Rechenzentren effektiv einsetzbar sind, bietet FastVLM die Möglichkeit, komplexe Bild-Sprach-Interaktionen erheblich ressourcenschonender und näher am Endgerät durchzuführen. Dies hat Auswirkungen auf verschiedene Bereiche: Von der Verbesserung von Assistenzsystemen, die visuelle Signale erkennen und interpretieren, bis hin zu industriellen Anwendungen wie der automatisierten Qualitätskontrolle oder innovativen Suchfunktionen in großen Bildarchiven. Darüber hinaus ist die Skalierbarkeit von FastVLM ein großer Vorteil. Entwickler können je nach Anwendungsfall zwischen unterschiedlichen Modellgrößen und Leistungsstufen wählen, ohne Kompromisse bei der Integration eingehen zu müssen. Dies erleichtert es, den richtigen Kompromiss zwischen Rechenaufwand und Genauigkeit zu finden und fördert die schnelle Adaption in vielfältigen Umgebungen.

Apples Ansatz, den Fokus neben der Forschung auch auf praktische Implementierungen und nutzbare Tools zu legen, spiegelt sich auch im Engagement wider, umfassende Dokumentationen, Anleitungen und Beispielanwendungen bereitzustellen. Dies unterstützt Entwickler dabei, die Technologie schnell zu verstehen, eigene Modelle zu trainieren oder bestehende vortrainierte Modelle effizient einzusetzen. Ein zentraler Aspekt von FastVLM ist die Kombination aus hoher Geschwindigkeit und kleiner Modellgröße, die durch die innovative FastViTHD-Kodierung ermöglicht wird. Dabei wird die visuelle Information so verarbeitet, dass unnötige Datenredundanz vermieden wird, was sowohl Speicher als auch Rechenzeit spart. Die schnelle Time-to-First-Token bedeutet, dass eine Reaktion auf ein vorgelegtes Bild fast sofort erfolgt – eine Voraussetzung für viele interaktive Anwendungen, bei denen Verzögerungen zu schlechter Nutzererfahrung führen würden.

Die Tatsache, dass FastVLM seine Stärken besonders bei hochauflösenden Bildern ausspielt, ist vor allem für Anwendungen in der Computer Vision und multimodalen KI von großer Bedeutung, da die Qualität und Detailgenauigkeit der Bilddaten hier oft entscheidend ist. Apples Forschungsergebnis unterstreicht somit die Wichtigkeit, Präzision und Geschwindigkeit gleichermaßen zu adressieren und dabei eine herausragende Hardware-Software-Synergie zu schaffen. Die breite Akzeptanz und das große Interesse in der Entwickler-Community sind auch anhand der hohen Anzahl von GitHub-Sternen und Forks abzulesen, die das FastVLM-Repository verzeichnet. Dieses Engagement zeigt, dass die bereitgestellten Ressourcen nicht nur theoretisches Forschungswerkzeug sind, sondern tatsächlich in der Praxis Anwendung finden und weiterentwickelt werden. Gleichzeitig beachtet Apple die ethischen Aspekte und Verantwortlichkeiten, die mit der Veröffentlichung solcher Technologien einhergehen.