In der heutigen schnelllebigen Welt der Softwareentwicklung ist die Bedeutung von Tests nicht zu unterschätzen. Unternehmen stehen unter ständigem Druck, qualitativ hochwertige Software schneller als je zuvor auf den Markt zu bringen. Dabei ist es entscheidend, Testprozesse zu etablieren, die nicht nur schnell, sondern auch zuverlässig und hochpräzise sind. Wie jedoch lassen sich diese widersprüchlichen Anforderungen in Einklang bringen? Schnell, zuverlässig und hoch fidel – das klingt fast wie ein Widerspruch, ist aber durchaus erreichbar, wenn man gezielt an den richtigen Stellschrauben arbeitet. Zuallererst muss das Verständnis von Testgeschwindigkeit erweitert werden.

Geschwindigkeit bedeutet nicht zwangsläufig, Tests so rasch wie möglich durchlaufen zu lassen, sondern die gesamte Testpipeline so zu optimieren, dass sie effizient funktioniert und ressourcenschonend arbeitet. Bei der Definition eines effizienten Testprozesses spielt die Auswahl der richtigen Tests eine zentrale Rolle. Automatisierte Tests können hierbei in vielen Fällen enorme Zeitersparnisse bieten, weil manuelle Testdurchläufe entfallen. Dennoch dürfen automatisierte Tests nicht auf bloße Quantität setzen. Eine Qualitätssicherung, die nur auf Masse beruht, kann zu Fehlalarmen, unzuverlässigen Ergebnissen und damit zu Vertrauensverlust führen.

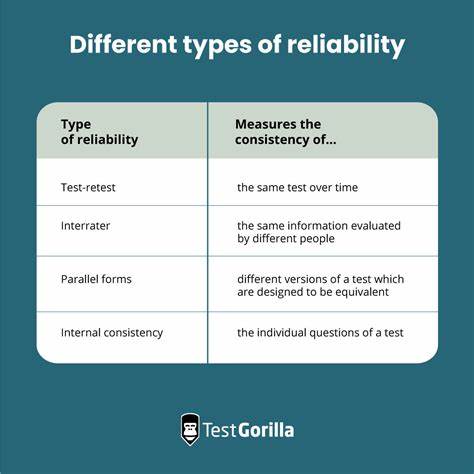

Verlässlichkeit in Tests entsteht durch Stabilität und Wiederholbarkeit. Stabil bedeutet, dass Tests unabhängig von äußeren Faktoren immer dasselbe Ergebnis liefern. Dies setzt eine saubere und konsistente Testumgebung voraus. So müssen beispielsweise Abhängigkeiten auf externe Systeme oder Datenquellen entweder simuliert oder kontrolliert werden, damit zufällige Ausfälle vermieden werden. Wiederholbarkeit ergibt sich daraus, dass Tests unter den gleichen Bedingungen beliebig oft durchgeführt werden können, was insbesondere bei kontinuierlicher Integration und kontinuierlichem Deployment unverzichtbar ist.

Nur wenn Entwickler und Tester sich auf die Testergebnisse zu 100 Prozent verlassen können, ist eine schnelle und zielgerichtete Fehlerbehebung möglich. Hohe Fidelity beschreibt die Genauigkeit und Aussagekraft der Tests in Bezug auf die realen Einsatzbedingungen der Software. Tests mit hoher Fidelity simulieren echte Nutzerinteraktionen authentisch und erfassen dabei auch komplexe Abläufe, die in der Praxis auftreten könnten. Dies ist besonders wichtig bei End-to-End-Tests oder Integrationstests, die die gesamte Anwendung in einem realistischen Szenario evaluieren. Die Herausforderung dabei liegt darin, dass Tests mit hoher Fidelity oft komplex und zeitintensiv sind und somit die Geschwindigkeit verringern können.

Dem kann man allerdings mit einer sinnvollen Schichtung von Testmethoden begegnen, etwa durch Kombination aus schnellen Unit Tests und selektiven Integrationstests, die nur die wirklich kritischen Pfade prüfen. Eine wesentliche Maßnahme zur Verbesserung von Geschwindigkeit, Zuverlässigkeit und Fidelity ist die Automatisierung von Testabläufen. Hierbei ist jedoch die Qualität der Testskripte entscheidend. Gut strukturierte und wartbare Tests reduzieren Fehleranfälligkeit und erlauben einfachere Anpassungen bei sich ändernden Anforderungen. Zudem ist die Nutzung moderner Testframeworks und Continuous Integration Pipelines essenziell.

Durch automatisierte Trigger von Testläufen bei jedem Code-Commit lassen sich Fehler früh und zuverlässig identifizieren. Damit wird auch die Feedback-Zeit für Entwickler drastisch verkürzt, was wiederum die gesamte Entwicklungszeit verringert. Nicht zu vernachlässigen ist die Einbindung von Mocking und Stubbing, um externe Abhängigkeiten zu isolieren und Tests stabiler zu machen. Diese Techniken sorgen dafür, dass Teile der Software, die von externen Systemen oder Netzwerken abhängig sind, simuliert werden. So wird verhindert, dass Probleme außerhalb der eigenen Anwendung das Testergebnis verfälschen oder Testläufe blockieren.

Ein weiterer Vorteil ist die bessere Kontrolle über die Testdaten, was zu wiederholbaren und aussagekräftigen Testergebnissen führt. Ein weiteres kritisches Thema ist die Auswahl geeigneter Testdaten. Die Verwendung realistischer und vielfältiger Daten gewährleistet, dass Tests verschiedene Nutzungsszenarien und Randbedingungen abdecken. Daten mit zu geringer Varianz oder unzureichendem Umfang können dazu führen, dass Fehler übersehen werden und die Tests damit unzuverlässig werden. Gleichzeitig müssen Testdaten so verwaltet werden, dass sensible Informationen geschützt bleiben und Datenschutzbestimmungen eingehalten werden.

Automatisierte Testdaten-Generatoren und Anonymisierungstools können hier eine nützliche Hilfe bieten. Schnelle Tests profitieren zudem von einer Optimierung der Testumgebung selbst. Virtualisierung und Containerisierung erlauben es, für jeden Testlauf eine saubere und reproduzierbare Umgebung bereitzustellen. So werden Wechselwirkungen mit anderen Anwendungen oder sonstigen Systemzuständen ausgeschlossen. Automatisierte Setups und Teardowns helfen dabei, den Zustand vor und nach den Testläufen zu organisieren und so unnötige Verzögerungen zu vermeiden.

Neben der technischen Optimierung spielen auch organisatorische Faktoren eine wichtige Rolle. Ein konsequentes Testmanagement und eine enge Zusammenarbeit zwischen Entwicklern, Testern und anderen beteiligten Teams fördern die Qualität und Geschwindigkeit der Tests. Regelmäßige Code-Reviews, gemeinsame Standards für Testskripte und transparente Kommunikation helfen dabei, Fehler früh zu erkennen und unnötige Wiederholungen oder doppelte Testarbeit zu vermeiden. Ein weiterer Ansatz zur Beschleunigung und Verbesserung der Testqualität ist die Implementierung von Risikobasiertem Testen. Dabei werden Ressourcen gezielt auf die kritischsten und fehleranfälligsten Komponenten konzentriert.

Dies ermöglicht es, mit begrenzten Mitteln eine hohe Testabdeckung und Aussagekraft zu erzielen, ohne zeitaufwändige Volltests durchzuführen. Risiken können anhand von Vorfällen, Komplexität oder Änderungsfrequenz bewertet und entsprechende Prioritäten gesetzt werden. Langfristig führt der Einsatz von künstlicher Intelligenz und Machine Learning im Testbereich zu weiteren Verbesserungen bei Tempo, Zuverlässigkeit und Fidelity. Intelligente Testplanung, automatisierte Fehlerdiagnose oder adaptives Testen ermöglichen es, Testressourcen optimal einzusetzen und Tests dynamisch an neue Gegebenheiten anzupassen. Auch wenn diese Technologien momentan noch in der Entwicklung und Erprobung stehen, zeichnen sich bereits deutliche Vorteile für die Zukunft ab.