In der Welt des maschinellen Lernens spielt die Differentiation eine zentrale Rolle. Besonders bei der Optimierung komplexer Modelle sind Ableitungen wie Gradienten, Jacobians oder Hessians unverzichtbar. Dabei zeigen viele Anwendungen nicht nur dichte, sondern vor allem spärliche Strukturen in diesen Ableitungen. Das bedeutet, dass viele Elemente in Jacobian- oder Hessian-Matrizen den Wert Null haben und damit keine relevante Information enthalten. Dieses Phänomen lässt sich gezielt nutzen, um Rechenzeit und Speicherbedarf erheblich zu reduzieren.

Die automatische Sparse-Differentiation (ASD) ist eine Technik, die genau das ermöglicht und damit hohe Effizienzgewinne mit sich bringt. Obwohl automatische Differentiation (AD) im maschinellen Lernen weit verbreitet ist, ist ASD bislang weniger bekannt. Dabei bietet diese Methode gerade bei großen, komplexen Modellen mit spärlichen Ableitungen einen enormen Vorteil. Die Grundlagen der automatischen Differentiation beruhen auf der Kettenregel der klassischen Analysis. Wenn eine Funktion aus mehreren Teilfunktionen zusammengesetzt ist, erlaubt AD die strukturierte und systematische Berechnung ihrer Ableitungen, ohne explizit jeden einzelnen Term zu differenzieren.

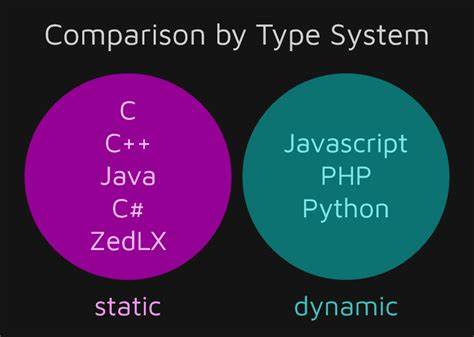

Dabei arbeitet AD meist „matrixfrei“ und verwendet sogenannte Jacobian-Operatoren anstelle von gespeicherten Jacobian-Matrizen. Das heißt, statt eine komplette Matrix im Speicher abzulegen, wird das Produkt mit Vektoren berechnet. Dies spart nicht nur viel Speicher, sondern verringert auch die Komplexität der Berechnungen. Es gibt zwei Hauptmodi der AD: den Vorwärtsmodus und den Rückwärtsmodus. Im Vorwärtsmodus propagiert man Ableitungen entlang der Funktionscomposition nach vorn, was insbesondere bei Funktionen mit wenigen Eingabedimensionen effizient ist.

Im Rückwärtsmodus, der vor allem im maschinellen Lernen für Gradientenberechnungen populär ist, läuft der Ableitungsdurchlauf rückwärts, was besonders bei Funktionen mit wenigen Ausgabedimensionen und vielen Eingabedimensionen sinnvoll ist. Beide Modi haben ihre Stärken und Schwächen, jedoch teilen sie das Prinzip, dass sie Jacobian-Operatoren effizient verwenden, ohne komplette Jacobian-Matrizen zu speichern. Die Herausforderung entsteht, wenn vollständige Jacobian- oder Hessian-Matrizen benötigt werden, beispielsweise bei der Lösung von Gleichungssystemen, Newton-Verfahren oder impliziten Differentiationsproblemen. Eine direkte Berechnung dieser Matrizen ist oft wegen hoher Rechenzeit und großem Speicherbedarf nicht praktikabel, besonders wenn die Dimensionen steigen. Doch genau hier setzt ASD an.

Durch die Nutzung der Sparsität in den Ableitungen ist es möglich, mehrere Spalten oder Zeilen der Jacobian- oder Hessian-Matrix gleichzeitig zu berechnen, vorausgesetzt sie sind „strukturell orthogonal“. Das bedeutet, dass sich Spalten oder Zeilen nicht überlappen, also keine gemeinsamen Nicht-Null-Elemente besitzen. Wenn solche Gruppen gefunden werden, können sie bei einem einzigen Differenzierungsdurchlauf zusammenberechnet werden, was erhebliche Einsparungen bringt. Bevor man jedoch mehrere Spalten oder Zeilen zusammenfassen kann, muss man die Struktur der Sparsität erkennen. Das ist nicht banal, da die automatische Differentiation als Blackbox oft keine Informationen über die genaue Position der Nicht-Null-Elemente liefert.

Deshalb beinhaltet ASD zuerst eine sogenannte Mustererkennung oder Sparsitätsmuster-Detektion. Diese ermittelt, welche Elemente tatsächlich von Eingaben abhängen und somit potenziell Nicht-Null sind. Die Erkennung erfolgt typischerweise mittels Indexmengen, die die Positionen von Einflussfaktoren auf jeden Ausgang repräsentieren. Diese Indexmengen können effizient propagiert werden, ohne vollständige numerische Ableitungen zu berechnen. Mit dem Sparsitätsmuster ist der nächste Schritt die sogenannte „Färbung“ (Coloring).

Dabei wird ein Graph konstruiert, in dem jeder Knoten eine Spalte oder Zeile der Ableitungsmatrix darstellt, und Kanten zwischen Knoten gesetzt werden, wenn deren Spalten oder Zeilen sich in einem Nicht-Null-Eintrag überschneiden. Eine geeignete Färbung des Graphen stellt sicher, dass miteinander verbundene Knoten unterschiedliche Farben erhalten. So können Spalten oder Zeilen mit der gleichen Farbe ohne Überlappung zusammengefasst berechnet werden. Optimale oder heuristische Algorithmen sorgen dabei für ein möglichst kleines Farbspektrum, was die Anzahl der notwendigen AD-Durchläufe reduziert. Diese Kombination aus Mustererkennung und Färbung bildet das Fundament der ASD.

So lässt sich zum Beispiel in einem Szenario mit einer bandförmigen Jacobian-Matrix, wie sie bei wiederholten Differenzen entsteht, eine geringe Anzahl an Farben bestimmen, die unabhängig von der Gesamtgröße der Matrix bleibt. Der Vorteil: Für sehr große Dimensionen skaliert ASD bedeutend besser als klassische AD. Während die Erstbeschreibung von ASD oft anhand des Jacobians erfolgt, ist das Verfahren ebenso für den Hessian anwendbar. Der Hessian, der die zweiten partiellen Ableitungen zusammenfasst, ist insbesondere für second-order Optimierungsalgorithmen relevant. Auch hier entfaltet ASD große Wirkung, denn Hessians sind meist noch spärlicher als Jacobians, allerdings ist ihre Mustererkennung technisch anspruchsvoller.

Zudem nutzt ASD bei Hessians Symmetrie-Eigenschaften zur weiteren Effizienzsteigerung durch symmetrisches Färben. Die praktische Relevanz zeigt sich unter anderem in Optimierungsverfahren wie dem Newtonverfahren, bei dem Hessians in jedem Iterationsschritt benötigt werden. Statt teure Iterative Löser mit vielen Hessian-Vektorprodukten einzusetzen, kann ASD das komplette spärliche Hessian bereitstellen. Das spart viele Rechenoperationen und erhöht die Genauigkeit, insbesondere wenn direkte lineare Lösungsverfahren verwendet werden sollen. Weitere potentielle Anwendungen sind implizite Differentiation, Differentialgleichungs-Solver, und Algorithmen, die vollständig differenzierbare Lösungen von Gleichungen erfordern.

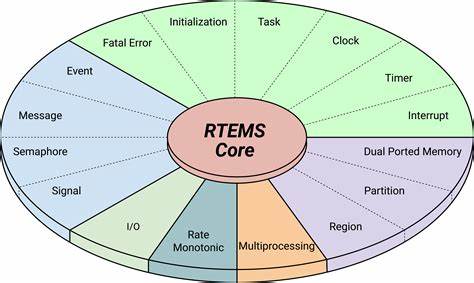

Die Umsetzung von ASD erfordert eine modularisierte Pipeline, welche die Mustererkennung, die Färbung, das Komprimieren der AD-Schritte und die anschließende Dekompression kombiniert. In modernen Programmierumgebungen wird diese Pipeline zunehmend unterstützt. Besonders in der Julia-Programmiersprache gibt es umfassende Pakete, die ASD leistungsstark und zugänglich machen. Julia bietet aufgrund ihrer hohen Leistungsfähigkeit sowie der engen Integration von Differentiationstools und Sparse-Matrix-Bibliotheken ideale Voraussetzungen für die Entwicklung solcher Systeme. Mit Julia-Paketen wie SparseConnectivityTracer.

jl zur Mustererkennung, SparseMatrixColorings.jl für effiziente Färbungsverfahren sowie ForwardDiff.jl als AD-Backend lassen sich Jacobians und Hessians automatisch und spärlich ableiten. Die Benutzung ist dabei so einfach, dass sich bestehender Code nur durch das Wechseln der Backend-Implementierung ändern muss. Dies ermöglicht große Flexibilität bei der Nutzung von AD oder ASD, je nach Bedarf.

Erfahrungen zeigen, dass ASD bei sehr kleinen Problemgrößen zunächst nicht schneller ist als klassische AD, da die Kosten für Mustererkennung und Färbung vergleichsweise hoch sind. Mit zunehmender Dimension und stärkerem Sparsitätsgrad hingegen lohnt sich ASD deutlich. Die Anzahl der notwendigen Differenzierungen sinkt von linear zur Eingabedimension auf eine deutlich geringere Anzahl, entsprechend der Farbenanzahl. Das führt zu einem asymptotischen Geschwindigkeitsschub mit wachsender Problemgröße, was bei großen neuronalen Netzen oder wissenschaftlichen Anwendungen von Bedeutung ist. Für Nutzer stellt sich damit die Frage, wann ASD verwendet werden sollte.

Gradienten von skalaren Funktionen profitieren meist nicht von ASD, da für sie im Rückwärtsmodus nur eine Vektor-Jacobian-Produktion notwendig ist. Im Gegensatz dazu lohnen sich ASD-Techniken für vollständige Jacobian- oder Hessian-Matrizen, beispielsweise in Optimierungen höherer Ordnung oder bei Problemen, die explizit mit diesen Matrizen rechnen. Die Funktion selbst muss zudem komplex genug sein, dass sich die Kosten einer normalen AD lohnen, um durch ASD reduziert zu werden. Die Wahl des richtigen Tools ist entscheidend, um den Rechenaufwand und Speicherverbrauch zu optimieren. Die automatische Sparse-Differentiation eröffnet hier neue Möglichkeiten, die in vielen bisher ungelösten oder ineffizienten Szenarien eine effizientere Lösung bieten.

Mit zunehmender Bekanntheit und technischen Weiterentwicklungen wird die Integration von ASD in bestehende maschinelle Lernframeworks und differenzierbare Programmierumgebungen weiter voranschreiten. Abschließend lässt sich sagen, dass ASD das Potenzial besitzt, die Effizienz differenzierbarer Programme sowohl im maschinellen Lernen als auch in wissenschaftlichen Anwendungen grundlegend zu verbessern. Indem es die inhärente Sparsität von Jacobian- und Hessian-Matrizen ausnutzt, ermöglicht es die Berechnung komplexer Ableitungen mit deutlich geringerem Aufwand. Zunehmende Entwicklung von benutzerfreundlichen Implementierungen und die Integration in Programmiersprachen wie Julia machen es zu einer wichtigen Technik für Forscher und Entwickler, die große und komplexe Modelle differenzierbar machen wollen.