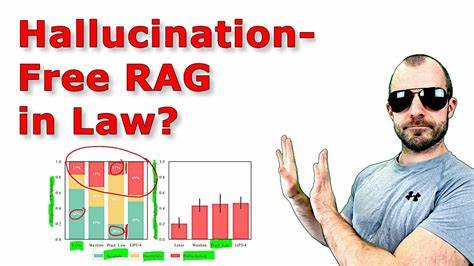

Die Digitalisierung hat die Art und Weise, wie juristische Recherchen durchgeführt werden, grundlegend verändert. Künstliche Intelligenz (KI) ist mittlerweile ein fester Bestandteil vieler Rechtsabteilungen und Kanzleien, da sie verspricht, zeitintensive Rechercheprozesse zu beschleunigen und mit einer bisher unerreichten Präzision zu unterstützen. Doch trotz dieser Fortschritte steht ein zentrales Thema im Mittelpunkt der Diskussion: Sind die führenden KI-basierten Legal Research Tools wirklich frei von Halluzinationen – also von fehlerhaften oder erfundenen Informationen? Die Verlässlichkeit dieser Tools ist entscheidend, denn im Rechtswesen kann bereits eine kleine Ungenauigkeit schwerwiegende Folgen für die Mandanten und die Rechtsprechung haben. In diesem Kontext lohnt sich eine eingehende Analyse, die sowohl die Stärken als auch die Schwächen der aktuellen Rechtsforschungstechnologien beleuchtet. Künstliche Intelligenz im Rechtsbereich ist vor allem darauf ausgelegt, große Datenmengen an rechtlichen Dokumenten, Urteilen und Gesetzestexten zu durchsuchen und relevante Informationen schnell zu extrahieren.

Dabei kommen komplexe Algorithmen zum Einsatz, die Muster erkennen und juristische Zusammenhänge interpretieren. Darüber hinaus nutzen viele Anbieter Natural Language Processing (NLP), um natürliche Sprache zu verstehen und auf Anfragen präzise Antworten zu liefern. Die Effizienzsteigerung durch solche Technologien ist unbestreitbar: Anwälte können binnen Sekunden einschlägige Präzedenzfälle, Gesetzesänderungen oder Kommentare abrufen, die früher stunden- oder sogar tagelang recherchiert werden mussten. Allerdings werfen Kritiker immer wieder die Frage auf, ob die gelieferten Ergebnisse tatsächlich korrekt und vollständig sind. Halluzinationen – in der KI-Sprache das Erfinden von Informationen, die nicht existieren oder falsch sind – sind ein bekanntes Problem bei vielen generativen Modellen.

Auch wenn derartige Funktionen in Legal Research Tools nicht immer als KI-Generatoren wie Chatbots auftreten, können fehlerhafte Verweise oder ungenaue Interpretationen von Gesetzestexten passieren. Die Konsequenzen reichen von einer falschen juristischen Einschätzung bis zu komplett irrelevanten Empfehlungen, was im schlimmsten Fall zu Fehlentscheidungen und Haftungsfragen führen könnte. Ein Grund für diese Schwäche liegt oft in der Datenbasis und den Trainingsmethoden der KI-Systeme. Juristische Texte sind komplex strukturiert, enthalten Nuancen und widersprüchliche Interpretationsmöglichkeiten. Zudem ändern sich Gesetze ständig durch neue Urteile und Legislative.

Wer hier auf veraltete oder unvollständige Datensätze zurückgreift, riskiert ungenaue oder überholte Ergebnisse. Ein weiterer Aspekt ist die mangelnde Transparenz einiger Anbieter, die ihre Algorithmen als Geschäftsgeheimnis behandeln. Das erschwert es Fachanwälten und Datenschutzexperten, die Funktionsweise der Systeme zu durchschauen oder den Ursprung einzelner Empfehlungen nachzuvollziehen. Vertrauen in KI-Systeme wird somit nicht nur durch deren Genauigkeit geprägt, sondern auch durch deren Nachvollziehbarkeit. Dennoch gibt es positive Entwicklungen: Einige Anbieter investieren stark in Validierungsmechanismen, bei denen die KI-Ausgabe durch menschliche Experten überprüft wird, vor allem in sensiblen Rechtsgebieten.

Zudem verbessern fortlaufende Updates der Datenbank die Aktualität der verwendeten Informationen. Der Trend geht zudem hin zu hybriden Modellen, die KI mit klassischen Suchmethoden kombinieren, um Risiken durch Halluzinationen zu minimieren. Diese Ansätze sollen sicherstellen, dass die Vorschläge nicht nur schnell, sondern auch fundiert sind. Für Rechtsanwälte und Kanzleien ist es daher wichtig, nicht blind auf KI-Werkzeuge zu vertrauen, sondern deren Ergebnisse kritisch zu hinterfragen. Die Technologien sind wertvolle Hilfsmittel, sollten aber immer durch das Fachwissen und die Erfahrung eines Juristen ergänzt werden.

Die Haftungsfrage bei fehlerhaften Empfehlungen ist dabei nicht zu unterschätzen – wer sich ausschließlich auf KI-Research verlässt, könnte sich rechtlich angreifbar machen. Für die Zukunft ist mit einer immer besseren Integration von KI in die Rechtsarbeit zu rechnen. Fortschritte in Bereichen wie Explainable AI (XAI) und innovativen Trainingsstrategien versprechen, Halluzinationen weiter zu reduzieren und die Verlässlichkeit entscheidend zu erhöhen. Dennoch bleibt der Mensch am Ende des Entscheidungsprozesses unersetzlich. Abschließend lässt sich festhalten, dass die führenden KI-Legal Research Tools zweifellos enorme Vorteile hinsichtlich Geschwindigkeit und Effizienz bieten.

Die Herausforderung besteht aber darin, ihre Zuverlässigkeit und Glaubwürdigkeit ständig zu verbessern und die Gefahr von Halluzinationen zu minimieren. Nur so kann der Einsatz künstlicher Intelligenz im Rechtswesen tatsächlich dazu beitragen, die Qualität juristischer Beratung zu steigern und zugleich Risiken für Mandanten und Anwälte zu verringern. Daher bleibt ein kritischer und verantwortungsvoller Umgang mit solchen Technologien unerlässlich, um den hohen Anforderungen des Rechtsmarktes gerecht zu werden.