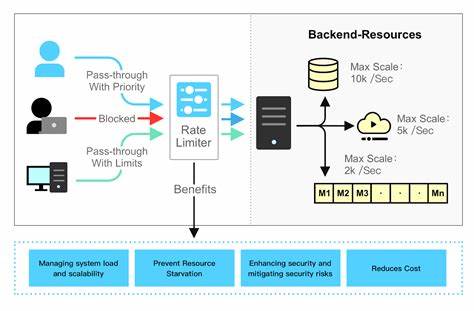

Im digitalen Zeitalter, in dem immer mehr Anwendungen und Services online betrieben werden, gewinnt die effiziente Verwaltung von Ressourcen zunehmend an Bedeutung. Dabei steht besonders die Frage im Vordergrund, wie sich Systeme vor Überlastungen schützen und gleichzeitig eine gleichbleibende Servicequalität bieten können. Eine grundlegende Strategie, um solchen Herausforderungen zu begegnen, ist die sogenannte Rate Limiting. Obwohl dieser Begriff in der Welt der Softwareentwicklung weit verbreitet ist, fällt es oft schwer, die zugrundeliegenden Mechanismen und deren Vorteile vollständig zu erfassen. Rate Limiting beschreibt die Begrenzung der Anzahl an Anfragen oder Operationen, die ein Nutzer oder Client in einem definierten Zeitfenster ausführen darf.

Das verhindert nicht nur Überlastung einzelner Ressourcen, sondern dient auch als Schutzmechanismus gegen Angriffe wie Distributed Denial of Service (DDoS). Zudem hilft Rate Limiting, die Betriebskosten von Servern zu senken, indem unnötige Anfragen begrenzt und die Auslastung optimiert wird. Um die Umsetzung und Wirkung von Rate Limiting besser nachvollziehen zu können, bieten verschiedene Algorithmen unterschiedliche Ansätze und Charakteristiken. Ein Klassiker unter diesen ist der Token Bucket Algorithmus. Hierbei wird das Prinzip eines Eimers mit einer festen Anzahl an Tokens angewandt.

Tokens werden kontinuierlich mit einer definierten Rate in den Bucket gegeben, und jede ankommende Anfrage muss einen Token entnehmen, um verarbeitet zu werden. Sobald der Bucket leer ist, werden weitere Anfragen entweder abgelehnt oder verzögert. Dieses Modell erlaubt sogenannte Bursts – also kurzzeitige Zugriffsspitzen – solange genug Tokens im Bucket vorhanden sind. Dadurch bietet der Token Bucket eine flexible Möglichkeit, unregelmäßige Traffic-Muster zu handhaben, ohne die Gesamtleistung zu gefährden. Neben dem Token Bucket gibt es den Leaky Bucket Algorithmus, der auf einem ähnlichen Bild basiert, jedoch mit einem anderen Fokus.

Vorstellbar ist eine Schale, die kontinuierlich an einem fixen Loch Wasser verliert. Anfragen fließen in diese Schale wie Wasserströme hinein. Die Verarbeitung erfolgt stets mit einer konstanten Rate – vergleichbar mit dem Leck der Schale. Wenn die Schale vollständig gefüllt ist und weitere Anfragen eintreffen, werden diese verworfen. Dieses Modell glättet Traffic-Spitzen, indem es eingehende Anfragen in einem stetigen Strom verarbeitet und somit eine gleichmäßige Belastung des Systems sicherstellt.

Die Strategie der festen Zeitfenster oder Fixed Window Counter ist eine weitere verbreitete Methode. Zeit wird in fest definierte Intervalle unterteilt, beispielsweise eine Minute. Innerhalb dieses Fensters werden die eingehenden Anfragen gezählt. Überschreitet ein Nutzer die maximal erlaubte Anzahl von Anfragen, werden alle weiteren Anfragen im laufenden Fenster abgelehnt. Diese Methode ist einfach zu implementieren und sehr performant, hat jedoch den Nachteil, dass am Ende eines Zeitfensters ein großer Peak an Anfragen auftreten kann, wenn die Zählung zurückgesetzt wird.

Für präzisere und smootheres Rate Limiting kommt der Sliding Window Counter Algorithmus zum Einsatz. Hierbei werden nicht nur starr fixierte Fenster betrachtet, sondern für jede Anfrage geprüft, wie viele Anfragen in einem gleitenden Zeitrahmen zuletzt erfolgt sind. So kann etwa überprüft werden, wie viele Anfragen ein Nutzer innerhalb der letzten 60 Sekunden gesendet hat – unabhängig davon, wann genau das Zeitfenster begonnen hat. Diese Methode verhindert Lastspitzen, die durch das plötzliche Rücksetzen eines festen Fensters entstehen können, und sorgt für eine feinere Kontrolle der Anfragefrequenz. Der Einsatz dieser Algorithmen ist nicht nur bei einfachen API-Servern oder Webanwendungen relevant.

Gerade bei Anwendungen mit hoher Nutzerzahl und freien Zugängen ist es wichtig, missbräuchliche Nutzung oder technische Probleme schnell einzudämmen. Rate Limiting schafft dabei nicht nur einen fairen Zugriff für alle Nutzer, sondern verhindert auch, dass Angreifer übermäßige Last erzeugen, die zum Ausfall oder zur Verlangsamung von Diensten führen könnte. Die Implementierung entsprechender Rate Limiting Mechanismen erfordert eine sorgfältige Abwägung zwischen Benutzerfreundlichkeit und Sicherheit. Eine zu strenge Begrenzung kann legitime Nutzer frustrieren, wohingegen zu lockere Regeln nicht ausreichend schützen. Dabei helfen interaktive Tools und simulierte Umgebungen, die Wirkung der verschiedenen Algorithmen verständlich zu demonstrieren und passende Einstellungen zu finden.

Zudem gibt es zahlreiche freie und kommerzielle Lösungen, die Rate Limiting in unterschiedlichen technischen Stacks einfach integrieren können. Ob in Cloud-Diensten, Mikroservice-Architekturen oder großen Content-Delivery-Netzwerken – überall dort sorgt Rate Limiting dafür, dass Dienste zuverlässig, performant und sicher bleiben. Es lohnt sich daher, bereits bei der Entwicklung von Anwendungen Rate Limiting als integralen Bestandteil zu planen und entsprechend zu testen. Zusammenfassend lässt sich sagen, dass Rate Limiting unerlässlich ist, um heute skalierbare und stabile Backend-Systeme zu schaffen. Die Wahl des richtigen Algorithmus hängt dabei vom Anwendungsfall, der Lastcharakteristik und den Sicherheitsanforderungen ab.

Von den klassischen Methoden wie Fixed Window Counter bis hin zu ausgefeilteren Ansätzen wie Sliding Window und Token Bucket ermöglicht der gezielte Einsatz von Rate Limiting eine optimale Verteilung von Ressourcen, verbesserte Benutzererfahrung und langfristige Kosteneffizienz. Die stetige Weiterentwicklung und Integration interaktiver Lernplattformen unterstützt Entwickler dabei, Rate Limiting besser zu verstehen und erfolgreich einzusetzen.