Die Wahl der richtigen Datenbank ist eine strategische Entscheidung, die Unternehmen langfristig beeinflusst. Insbesondere bei wachsendem Datenvolumen und steigendem Nutzeraufkommen kann die Entscheidung für eine Datenbanktechnologie entscheidend für Performance, Skalierbarkeit und Kosten sein. Ein Beispiel dafür ist die Migration von CockroachDB zu PostgreSQL, die Motion, ein auf KI-gestützte Workflow-Lösungen spezialisiertes Unternehmen, erfolgreich durchgeführt hat. Die Erfahrungen und Erkenntnisse aus diesem Prozess bieten wertvolle Einblicke für alle, die eine vergleichbare Umstellung in Betracht ziehen. Ursprünglich begann Motion im Jahr 2022 mit CockroachDB.

Die Wahl fiel auf diese verteilte SQL-Datenbank aufgrund ihrer Stärken: automatische horizontale Skalierung, hohe Verfügbarkeit sowie Compliance-Vorteile durch einfache Multi-Region-Setups – besonders relevant für Datenschutzanforderungen wie die DSGVO. Doch mit wachsendem Datenvolumen und höheren Anforderungen stiegen auch die Herausforderungen und Kosten rapide an. Bis 2024 hatten sich die Ausgaben für CockroachDB auf fünfstellige bis mittlere sechsstellige Beträge verfünffacht, ohne dass die Vorteile einer verteilten Datenbank voll ausgeschöpft wurden. Die Nutzung beschränkte sich auf einfache transaktionale Abfragen in einer einzelnen Region, womit das Potenzial für verteilte Systeme kaum zur Geltung kam. Eine direkte Vergleichsmöglichkeit bot die Verwendung eines Object-Relational Mappers (ORM), konkret Prisma, der die Abstraktion gegenüber der Datenbank vereinfachte und es erlaubte, Migrationen zwischen verschiedenen Systemen relativ problemlos zu testen.

Die Migration von einer großen CockroachDB-Instanz mit etwa 100 Millionen Datensätzen zu einem vollständig anders aufgebauten PostgreSQL-System stellte jedoch eine komplexe Herausforderung dar. Vor allem die Anwendung von Datenbankmigrationen bereitete zunehmend Kopfschmerzen. Mit der Zeit kam es immer häufiger zu Timeout-Problemen bei Prisma, die den Deployment-Prozess blockierten und sogar erfahrene Entwickler zwangen, Migrationen manuell und einzeln auf der CockroachDB-Konsole durchzuführen. Die Auflösung der Deadlocks oder Wartezeiten brauchte mitunter mehrere Stunden, was den Entwicklungsworkflow stark beeinträchtigte. Für PostgreSQL hingegen zeigte sich eine deutlich höhere Stabilität: Migrationen, die auf cockroach-Basis mehrfach scheiterten, konnten bei Postgres auf einem vergleichbaren Datenbanksnapshot binnen Sekunden durchgeführt werden – ein klarer Vorteil in puncto Agilität und Effizienz.

Diese Limitierungen wirkten sich auch auf das übergreifende Datenmanagement aus, insbesondere bei der ETL-Prozesskette (Extract, Transform, Load). Die Anbindung von CockroachDB an ETL-Lösungen wie Airbyte war im Jahr 2024 noch extrem rudimentär, da die vorhandenen Connectoren sich im Alpha-Stadium befanden und Performanceprobleme sowie Speicherlecks aufwiesen. Solche Engpässe führten zu häufigen Ausfällen und hoher Zeitverzögerung bei der Datenintegration – ein Zustand, der für ein wachsendes Unternehmen langfristig nicht tragbar ist. Im Gegensatz dazu bot PostgreSQL eine ausgereifte und breite Tool-Landschaft zur Datenintegration, was den Betrieb deutlich vereinfacht und zuverlässiger gestaltet. Interessant waren die Performance-Tests bei klassischen Abfragen.

CockroachDB zeigte sich in einigen Spezialfällen schneller, dank eines ausgefeilten Query Optimizers, der komplexe Aggregationen effizienter umsetzen konnte. Jedoch waren diese Fälle eher die Ausnahme. Viele Alltagsabfragen, wie sie über das ORM Prisma generiert wurden, führten CockroachDB mit langen Laufzeiten aus, vor allem wenn komplexe Joins und Subqueries beteiligt waren. PostgreSQL konnte hier regelmäßig bessere Ergebnisse erzielen, teilweise mit bis zum zwanzigfach schnelleren Antwortzeiten. Die Ursache lag unter anderem darin, dass CockroachDB SQL-Anfragen oft mit redundanten und ineffizienten Abfragen ausführte, etwa durch überflüssige Tabellen-Scans, während PostgreSQL die Abfragen intelligenter optimierte.

Auch das Nutzererlebnis für Entwickler litt unter einigen Mängeln und Einschränkungen beim Umgang mit CockroachDB. Das Management-Interface zeigte oft eine unklare oder irreführende Darstellung von verwendeten und ungenutzten Indizes, die für Fehlinterpretationen sorgen konnte. Zudem gestaltete sich das Abbrechen lästiger oder zu langer Abfragen auf CockroachDB wesentlich komplizierter als bei PostgreSQL, wo einfache Abbruchbefehle in SQL-Clients wie TablePlus schnell Wirkung zeigten. Die verteilte Architektur von CockroachDB erforderte dagegen manuelle Eingriffe auf mehreren Ebenen mit dem Risiko, dass nicht alle Knoten rechtzeitig reagieren. Auch die Support-Erfahrung war alles andere als optimal, bedingt durch lange Reaktionszeiten und getrennte Zugangsportale.

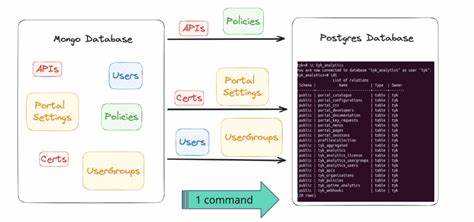

Eine weitere technische Herausforderung waren zeitweise auftretende Verbindungsprobleme im Netzwerk, insbesondere bei der Verwendung von Tailscale für das Private Networking. Diese zufälligen Ausfälle unterbrachen Anbindungen sowohl in Entwicklungsumgebungen als auch bei der Datenmigration. Mit PostgreSQL konnten vergleichbare Situationen nicht beobachtet werden, was die Zuverlässigkeit der Infrastruktur weiter erhöhte. Der eigentliche Migrationsvorgang wurde mit einem eigens entwickelten ETL-Tool umgesetzt, das den Datentransfer von CockroachDB nach PostgreSQL plante und ausführte. Dabei kamen innovative Technologien wie Bun, eine moderne JavaScript Runtime, zum Einsatz, die das Streaming großer Datenmengen effizient abwickelte.

Der komplexe Unterschied in der Kodierung von JSON- und Array-Datentypen zwischen beiden Systemen stellte jedoch eine unerwartete Hürde dar und erforderte umfangreiche Konvertierungsmaßnahmen. Durch die Entwicklung eines angepassten CSV-Verarbeitungsprozesses konnte eine kompatible und konsistente Datenübertragung sichergestellt werden. Der eigentliche Cut-over wurde sorgfältig vorbereitet und in einer systematischen Wartungsphase spät in der Nacht vollzogen, um Ausfallzeiten möglichst gering zu halten. Dank einer leistungsstarken VM und optimierten Prozessen verlief die Migration innerhalb von etwa 15 Minuten, mit einer Gesamt-Downtime von unter einer Stunde. Dabei kam es zu keinerlei Datenverlusten.

Nach dem finalen Umstieg führte die Umstellung auf PostgreSQL zu einer messbaren Verbesserung der Systemperformance. Die aggregierten Latenzzeiten bei API-Anfragen sanken sofort um ein Drittel, und innerhalb weniger Stunden konnten weitere ineffiziente Abfragen mit Werkzeugen wie PGAnalyze erkannt und optimiert werden. Nicht zuletzt ermöglichte die Migration eine erheblich Kostenreduktion. Trotz einer konservativen Überdimensionierung der neuen PostgreSQL-Instanz sparte das Unternehmen jährlich über 110.000 US-Dollar allein durch reduzierte Betriebskosten und Lizenzgebühren.

Die Einsparungen dürften mit weiterem Wachstum sogar steigen, was die wirtschaftliche Nachhaltigkeit unterstreicht. Für Entwicklungs- und Betriebsteams zeigt das Beispiel von Motion, wie wichtig es ist, technische Entscheidungen laufend zu überprüfen und an praktischen Erfahrungen auszurichten. Während verteilte Datenbanken wie CockroachDB im Szenario von echten Multi-Region-Anforderungen mit komplexen Datenschutzauflagen große Stärken spielen, sind diese Vorteile nicht per se für jedes Geschäftsszenario notwendig oder wirtschaftlich sinnvoll. PostgreSQL bietet eine bewährte, performante und kosteneffiziente Alternative für viele Anwendungen, besonders wenn einfache Skalierung und Stabilität im Vordergrund stehen. Für Entwickler bedeutet das außerdem, dass das Verständnis für SQL-Optimierung, das Verhalten von ORMs sowie die System-Grenzen der genutzten Datenbanken entscheidend sind.