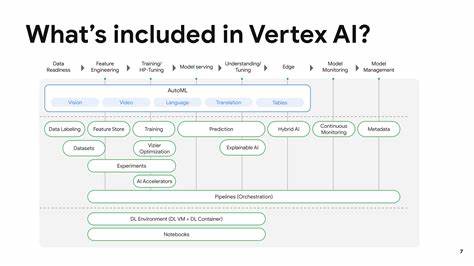

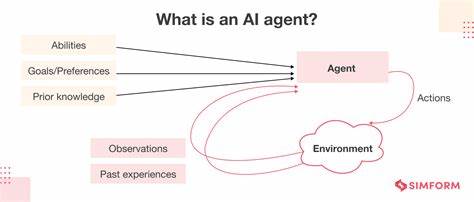

In der modernen Welt der Cloud-basierten Machine Learning-Plattformen spielt Google Cloud Platform mit seinem Vertex AI Angebot eine bedeutende Rolle. Insbesondere Vertex AI Managed Notebooks bieten Data Scientists und Entwicklern eine einfache Möglichkeit, Arbeitsumgebungen für KI-Projekte zu erstellen und zu verwalten. Doch was passiert, wenn ein Managed Notebook scheinbar unsterblich wird – also sich nicht mehr abschalten oder kontrollieren lässt? Dieser Artikel widmet sich genau diesem Phänomen, das von Nutzern gelegentlich auf Hacker News und anderen Foren beschrieben wird, und gibt praxisorientierte Hinweise zur Problemlösung und Vermeidung hoher Kosten durch unkontrollierte Ressourcen-Nutzung. Die Ausgangssituation ist einfach, aber dennoch verheerend: Ein Nutzer mietet ein Vertex AI Managed Notebook und bezahlt etwa neun US-Dollar pro Tag – eine Summe, die sich schnell summiert. Doch plötzlich lässt sich das Notebook nicht mehr über die Google Cloud Console verwalten.

Das User Interface zeigt keine Instanzdetails mehr an, direkte Zugriffe erfolgen mit Authentifizierungsfehlern, etwa einem „Error 400: invalid_request“. Genau hier beginnt die eigentliche Herausforderung: Die eigene virtuelle Maschine scheint unausweichlich weiterzulaufen und verursacht trotz mangelnder Zugänglichkeit weitere Kosten. Die Ursachen für diese sogenannte „Unsterblichkeit“ eines Vertex AI Notebooks können vielfältig sein. In manchen Fällen handelt es sich um temporäre Probleme mit den Google Cloud-Diensten selbst, etwa Authentifizierungs- oder Berechtigungsfehler, die das normale Management unmöglich machen. Andernorts können zugrunde liegende Netzwerkprobleme oder Cache-Daten im Browser die Verbindung zum Managed Notebook blockieren.

Auch fehlerhafte IAM-Rollen oder inkonsistente Einstellungen in der Projektkonfiguration können den Zugriff unmöglich machen. Darüber hinaus gibt es Berichte von Konflikten zwischen der Cloud-Shell, lokalen Firewalls und den vom Notebook verwendeten Ports. Ein besonders nervenaufreibender Aspekt ist, dass Nutzer im Pay-as-you-go-Modell von GCP häufig keinen unmittelbaren Zugang zu persönlichem Google Support besitzen. Somit bleibt zur Problemlösung oft nur das Abwarten auf automatisierte Systeme oder Community-gestützte Hilfen. Wenn die Abrechnung aber weiterläuft, summieren sich die Kosten schnell zu ungewollten Rechnungen – eine Situation, die viele als eine Art „Geistermaschine“ beschreiben.

Um solchen Schwierigkeiten vorzubeugen, ist es wichtig, schon vor dem Start eines Managed Notebooks bewährte Vorgehensweisen einzuhalten. Eine gründliche Überprüfung der Zugriffsrechte und -rollen stellt sicher, dass alle nötigen Berechtigungen vorhanden sind. Zusätzlich lohnt es sich, die Netzwerksicherheit und Firewall-Regeln auf Projekt- oder Organisationsebene zu überprüfen, um Verbindungsabbrüche zu vermeiden. Nutzer sollten sich auch mit den von GCP empfohlenen Tools vertraut machen, z. B.

gcloud CLI, um alternative Management-Methoden zu haben, falls das Webinterface versagt. Wenn die Unsterblichkeit eines Notebooks bereits eingetreten ist, lohnt es sich, folgende Schritte auszuprobieren: Zunächst sollte man versuchen, die entsprechende Instanz über die Google Cloud Console oder mittels Befehl „gcloud notebooks instances delete [INSTANCE_NAME]“ direkt zu löschen. Reagiert die Konsole jedoch nicht oder liefert Fehler, kann das Leeren von Browser-Cache oder das Nutzen eines anderen Browsers helfen. Zusätzlich empfiehlt es sich, über die Google Cloud Console die IAM- und Admin-Rollen zu prüfen und gegebenenfalls neu zuzuweisen. Manchmal behebt schon eine Erneuerung der Zugriffs-Token oder ein Logout/Login in der Cloud Console das Problem.

Ist auch das nicht zielführend, bietet sich das Diagnostizieren der Logs mit Stackdriver Logging an, um Hintergrundprozesse oder Fehlermeldungen zu identifizieren. In manchen Ausnahmefällen kann es helfen, über die API oder mittels REST-Aufrufen direkt auf die verwaltete Notebook-Instanz zuzugreifen und sie zu deaktivieren. Nautische Manöver wie der Versuch, temporäre Netzwerkeinstellungen rückgängig zu machen oder Konfiguration von Authentifizierungsanbietern (OAuth, SAML) zu überprüfen, sind ebenfalls eine Option. Zu bedenken ist auch, dass die Google Cloud Plattform viele mechanische Schutzmechanismen anbietet, die eine Fortsetzung der Rechnung bei nicht zugänglichen Ressourcen verhindern sollen. Dennoch können Fehler oder Inkonsistenzen im Backend dazu führen, dass die Maschine faktisch weiterläuft, ohne dass manzugreifen kann.

Die Empfehlung lautet hier, in kritischen Fällen eine Budgetbenachrichtigung einzurichten, um vor Kostenexplosionen rechtzeitig gewarnt zu sein und bei Bedarf temporär Ressourcen zu sperren. Aus Sicht der Entwickler und Systemadministratoren ist die Automatisierung und Dokumentation aller erstellten Ressourcen essentiell. Automatisierte Skripte zur Ressourcenverwaltung mit Terraform oder Deployment Manager bieten die Möglichkeit, Ressourcen zu überwachen und kontrolliert löschen zu können. Auch das Einsetzen von Labels und Tags ermöglicht eine bessere Übersicht, welche Notebooks produktiv, testweise oder verwaist sind. Abschließend bleibt festzuhalten, dass eine „unsterbliche“ Maschine in der Google Cloud zwar frustrierend und kostspielig sein kann, jedoch durch das Verstehen der Plattformmechanismen sowie durch konsequente Verwaltung und Prävention beherrschbar ist.

Im Zweifelsfall bieten Community-Plattformen wie Hacker News, Stack Overflow und die Google Cloud Community häufig Hilfestellungen an, die häufiger auftretende Probleme mit Vertex AI Managed Notebooks behandeln. Das wichtigste Learning ist, bei jedem Schritt Transparenz und Kontrolle über Ressourcen zu bewahren, damit man nicht unerwartet der Kostensteigerung oder unzugänglichen Umgebungen ausgeliefert ist. Cloud Computing mag kompliziert sein, aber mit dem richtigen Mindset und den passenden Werkzeugen lässt sich selbst die stärkste „Geistermaschine“ wieder zur Ruhe bringen.