In der heutigen digitalen Welt akzeptieren Nutzer täglich eine Vielzahl von Nutzungsbedingungen und Datenschutzerklärungen, ohne diese jemals wirklich zu lesen oder zu verstehen. Diese Dokumente sollen eigentlich offenlegen, wie persönliche Daten verarbeitet, gespeichert und geschützt werden, doch die Realität sieht oft anders aus. Die Texte sind überladen mit juristischem Fachchinesisch oder so umfangreich, dass das Lesen allein schon eine große Hürde darstellt. Genau hier setzt der technologische Fortschritt mit Machine Learning (ML) an, um die Informationsflut zu bewältigen und Nutzern endlich Klarheit zu verschaffen. Die Herausforderung beim Umgang mit Datenschutzbestimmungen liegt darin, den komplizierten juristischen Text in verständliche und konkrete Aussagen zu verwandeln.

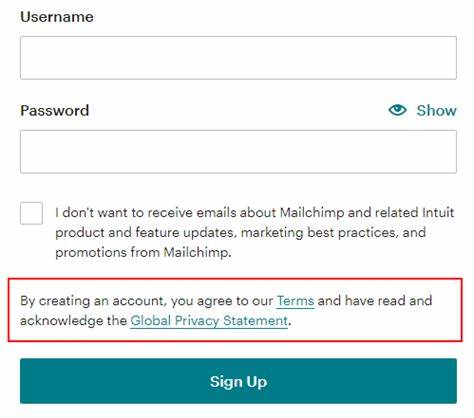

Viele Menschen klicken einfach blind auf das „Akzeptieren“-Feld, ohne zu wissen, welche Rechte sie aufgeben oder welche Daten über sie gesammelt werden. Unternehmen wiederum haben meist keinen Anreiz, solche Dokumente lesefreundlich zu gestalten, da die Dokumente vor allem eine rechtliche Absicherung darstellen. Das hat die Initiativen wie Terms of Service; Didn’t Read (ToS;DR) hervorgerufen – ein Projekt, das es sich zum Ziel gesetzt hat, Datenschutzerklärungen zu analysieren und in klar verständliche, ja/nein-Kommentare zu übersetzen. ToS;DR bietet einen innovativen Ansatz, indem es Statements formuliert, die Antworten auf datenschutzrechtliche Fragen geben, zum Beispiel „Werden Ihre personenbezogenen Daten verkauft?“ oder „Kann das Verweigern von Tracking-Cookies die Nutzung der Webseite beeinflussen?“. Solche Aussagen werden durch freiwillige Helfer überprüft und bewertet.

Allerdings stößt das Projekt an seine Grenzen, denn bei Zehntausenden von Webseiten und Diensten ist der Aufwand für menschliche Leser enorm. Bislang wurden nur einige tausend Dienste umfassend bewertet, was angesichts der Größe des Internets nur ein Tropfen auf den heißen Stein ist. Hier kommt das Machine Learning ins Spiel. Der Autor und Entwickler Evan Radkoff hat gemeinsam mit ToS;DR ein System namens Docbot entwickelt, das mithilfe von künstlicher Intelligenz die Arbeit der menschlichen Helfer unterstützt und beschleunigt. Dieses System nutzt historische Daten – annotierte Textstellen aus bestehenden Bewertungen – um eine Vielzahl von Modellen zu trainieren, die erkennen können, ob eine Datenschutz-Erklärung bestimmte Datenschutz-Cases bestätigt oder ablehnt.

Jedes Modell wurde für eine spezifische Datenschutzfrage („Case“) gebaut und arbeitet als binärer Klassifikator. Der Algorithmus bewertet dabei einzelne Sätze oder Satzgruppen aus den Dokumenten und ermittelt, wie wahrscheinlich es ist, dass der Text die jeweilige Aussage bestätigt. So hilft das System, relevante Textstellen automatisiert zu extrahieren, die anschließend von menschlichen Prüfern validiert werden. Sollte die KI eine Passage mit hoher Sicherheit bestätigen, wird sie vorgeschlagen und kann den Freigabeprozess deutlich beschleunigen. Die Herausforderung bei der Entwicklung von Docbot bestand darin, mit extrem langen und komplexen Dokumenten umzugehen.

Datenschutzbestimmungen umfassen oft mehrere tausend Wörter, und relevante Informationen sind nicht immer leicht zu finden. Das System musste daher Strategien entwickeln, wie es die wichtigsten Textabschnitte identifiziert. Radkoff gestaltete das Verfahren so, dass zunächst jeder Satz einzeln bewertet wird. Anschließend überprüft das Modell, ob sich durch das Hinzufügen benachbarter Sätze die Aussagekraft verbessert. Dieses Verfahren sorgt dafür, dass nicht nur isolierte Sätze, sondern sinnvoll zusammenhängende Abschnitte als Belege verwendet werden, was auch für bessere Verständlichkeit sorgt.

Ein weiterer wichtiger Aspekt war die Erstellung von Trainingsdaten. Während positive Beispiele aus den bereits annotierten Datenbanken einfach übernehmbar waren, stellte sich die Frage nach geeigneten negativen Beispielen. Hier wurden verschiedenste Strategien angewandt, um das Modell nicht nur auf einfache Keywords zu konditionieren, sondern es für komplexere Bedeutungsunterschiede zu sensibilisieren. Beispielsweise wurde versucht, Sätze aus dem Umfeld positiver Beispiele als harte negative Beispiele zu nutzen, um das System auf Feinheiten aufmerksam zu machen. So wurde das Modell robuster gegenüber häufig vorkommenden, aber inhaltlich nicht zutreffenden Textstellen.

Technisch basieren die Modelle auf ausgereiften Transformer-Architekturen wie BERT oder RoBERTa, die für ihre Fähigkeit bekannt sind, Sprache sehr gut zu verstehen und kontextualisierte Embeddings zu liefern. Statt ganze Modelle neu zu trainieren, wurden Parameter-Adapter (LoRA) verwendet, die deutlich weniger Speicherplatz beanspruchen und durch geringeren Rechenaufwand das Training effizienter gestalten. Das Ergebnis sind gut funktionierende, spezialisierte Modelle, von denen derzeit über 100 für unterschiedliche Datenschutz-Themen existieren. Die Genauigkeit der Modelle variiert je nach Komplexität der jeweiligen Fragestellung. Für relativ klar definierte Datenschutzfragen konnten sehr hohe F1-Scores nahe 0,9 oder mehr erreicht werden, was für automatisierte Systeme eine beeindruckende Leistung darstellt.

Schwieriger gestalteten sich dagegen Aussagen, die sehr subjektiv oder sprachlich variabel formuliert werden, wie beispielsweise die Lesbarkeit der Nutzungsbedingungen oder unklare Definitionen von Datenaufbewahrungszeiträumen. Die Integration von Docbot in den Workflow von ToS;DR hat die Geschwindigkeit und Reichweite der Datenschutzbewertung maßgeblich erhöht. Anstatt ausschließlich auf menschliche Freiwillige angewiesen zu sein, kann die KI auf Hunderttausende von Dokumenten angewandt werden, um potenziell relevante Passagen vorzuschlagen. Diese werden dann von menschlichen Kuratoren überprüft und freigegeben – eine Symbiose aus automatischer Skalierbarkeit und menschlichem Urteilsvermögen. Für die Zukunft plant ToS;DR, die Automatisierung weiter voranzutreiben, unter anderem durch eine mögliche automatische Vergabe von Bewertungen bei sehr hohen Vertrauensmaßen oder durch eine optimierte Nutzeroberfläche, die den Kuratoren das schnelle Abspecken von Vorschlägen ermöglicht.

Auch die Ausweitung der Technik auf Nicht-Englischsprachige Dokumente sowie Fälle mit wenigen Trainingsdaten steht auf der Agenda. Das Projekt ist offen für Community-Beiträge und unterstützt Forschende durch geplante Veröffentlichungen von Datensätzen und Modellen. Der Nutzen für die Nutzer ist enorm: Sie gewinnen einen besseren Überblick darüber, mit welchen Bedingungen sie tatsächlich einverstanden sind, und können bewusster entscheiden, welche Dienste sie nutzen möchten. Dies stärkt die digitale Selbstbestimmung und schafft Druck auf Unternehmen, verständlicher und transparenter zu kommunizieren. Darüber hinaus könnte die Technik langfristig zu regulatorischen Neuerungen beitragen, die maschinenlesbare und verständliche Datenschutzinformationen vorschreiben.

Dies würde nicht nur Verbrauchern nützen, sondern auch Entwicklern und Rechtsberatern, die sich täglich mit einem schwer durchschaubaren Regelwerk auseinandersetzen müssen. Insgesamt zeigt der Einsatz von Machine Learning in der Analyse und Zusammenfassung von Datenschutzerklärungen ein vielversprechendes Potenzial, komplexe rechtliche Texte zugänglich und handhabbar zu machen. Die Kombination aus fortschrittlicher Technologie und engagierter Communityarbeit setzt neue Standards im Umgang mit digitalen Rechten und Datenschutz. Gleichzeitig mahnt sie daran, dass Mensch und Maschine Hand in Hand arbeiten müssen, um Vertrauen und Transparenz im digitalen Raum sicherzustellen – ein wichtiger Schritt in Richtung einer datensouveränen Gesellschaft.