Die Tokenisierung ist ein entscheidender Schritt in der Verarbeitung natürlicher Sprache und bildet die Grundlage für moderne Sprachmodelle wie BERT und GPT-2. Sie bestimmt, wie Texte in kleinere Einheiten zerlegt werden, welche von Maschinen verarbeitet und verstanden werden können. Bei der Wahl der richtigen Tokenisierungsmethode stehen insbesondere Byte Pair Encoding (BPE) und Unigram-Sprachmodellierung im Fokus, wobei beide Ansätze unterschiedliche Strategien zur Segmentierung von Wörtern verfolgen. Ihre jeweilige Wirksamkeit und Morphologieerfassung beeinflussen maßgeblich die Leistung von Sprachmodellen in vielfältigen Anwendungen. Byte Pair Encoding, kurz BPE, hat sich in den letzten Jahren als Standardverfahren etabliert.

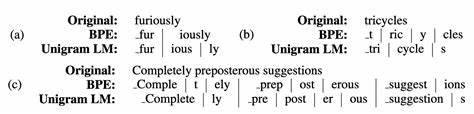

Ursprünglich aus der Informationstheorie kommend, zielt BPE darauf ab, eine maximale Kompression zu erreichen, indem wiederkehrende Zeichenfolgen in einem Text identifiziert und als einzelne Token zusammengefasst werden. Dadurch werden häufige Substrings bevorzugt, wobei die linguistische Struktur oder die morphologische Zusammensetzung der Sprache nur Randbeachtung findet. Dieses Verfahren bringt den Vorteil einer effizienten und datengetriebenen Korpuskompression mit sich, kann jedoch problematisch sein, wenn es darum geht, komplexe Wortformen in ihrer Bedeutung korrekt zu erfassen. Ein praktisches Beispiel verdeutlicht die Herausforderung: Das Wort "destabilizing" lässt sich auf vielfältige Weisen tokenisieren. Bei BPE kommt es oft vor, dass das Wort in Einheiten zerlegt wird, die nicht unbedingt der Wortbedeutung oder der sprachlichen Morphologie entsprechen.

So werden beispielsweise die Segmente "des", "ta", "bil" und "izing" getrennt behandelt, obwohl "de" als Negationspräfix und "stabilizing" als Stamm mit eigenständiger Bedeutung bestehen. Dadurch gehen wichtige Bedeutungsschichten verloren oder werden falsch interpretiert. Modelle müssen diese Wortformen anschließend unabhängig voneinander erlernen, was zusätzlichen Aufwand und eine höhere Komplexität für das maschinelle Lernen bedeutet. Im Gegensatz dazu steht die Unigram-Sprachmodellierung, eine Methode, die die wahrscheinlichsten Token aufgrund eines Wahrscheinlichkeitsmodells auswählt. Anders als BPE, das auf einem additiven Prozess basiert, beginnt Unigram-LM mit einem umfangreichen Vokabular und reduziert es durch iterative Entfernung seltener Token, wobei stets die Gesamtwahrscheinlichkeit des Korpus maximiert wird.

So gelingt es, Token zu identifizieren, die einer natürlichen Wortstruktur und Morphologie näherkommen. Diese modellbasierte Methode führt zu einer besseren Erfassung von Wortpräfixen, Suffixen und anderen morphologischen Elementen. Besonders bei komplexen Wortformen wie "destabilizing" segmentiert die Unigram-Sprachmodellierung das Wort sinnvoll in "de" und "stabilizing", wodurch die linguistischen Relationen klarer erhalten bleiben und vom Modell leichter erkannt werden können. Dies fördert eine effizientere Generalisierung und ein tieferes Verständnis, was gerade bei hochfrequenten morphologischen Konstruktionen von Vorteil ist. Diese Unterschiede wirken sich auch auf die Trainings- und Feinabstimmungsphasen von Modellen aus.

Während BPE-Tokenisierungen ebenfalls bemerkenswerte Resultate erzielen, wie in vielen Studien und auch in praktischen Anwendungen gezeigt wird, zeichnen sich Unigram-basierte Tokenisierungen durch bessere morphologische Interpretierbarkeit und damit potenzielle Leistungsverbesserungen in verschiedenen Downstream-Tasks aus. Besonders in Szenarien mit begrenzten Daten oder bei Aufgaben, die stark von morphologischen Beziehungen abhängen, kann dies zu verbesserten Ergebnissen führen. Des Weiteren sorgt die Unigram-Methode für eine robustere Token-Grammatik. Vergleichende Untersuchungen mit sogenannten "gold standard"-Tokenisierungen, die beispielsweise anhand von Merriam-Webster-Phonetikhilfen erstellt wurden, zeigen, dass Unigram Modellierung signifikant mehr morphologisch korrekte Subwörter erzeugt als BPE. Das bedeutet, dass Tokenisierungseinheiten häufiger komplette Bedeutungseinheiten oder Morpheme erfassen, was wiederum eine logische und sprachkonforme Verarbeitung fördert.

Der Faktor Geschwindigkeit ist bei der Wahl der Tokenisierungsmethode ebenfalls relevant. Während das Training eines Unigram-Modells initial länger dauert als bei BPE, gestaltet sich die Laufzeit bei der Inferenz ähnlich oder sogar vorteilhaft für Unigram. Gerade bei großen Datensätzen und komplexen Modellen amortisiert sich der Mehraufwand beim Training durch die bessere semantische Struktur der Tokens. Die weitgehende Akzeptanz von BPE durch die NLP-Community resultiert womöglich aus seiner Einfachheit und der etablierten Verfügbarkeit in zahlreichen Frameworks. Dabei ist insbesondere bemerkenswert, dass selbst bahnbrechende Modelle wie Googles T5 sich auf BPE stützen und die Untersuchung alternativer Tokenisierungstechniken nur am Rande erfolgt.

Ein Umdenken hin zu überhaupt besseren Verfahren wie der Unigram-Sprachmodellierung könnte in Zukunft die Sprachmodellierung auf ein neues Level heben. Neben dem Vergleich von BPE und Unigram gibt es auch weiterführende Überlegungen zur Optimierung von Tokenisierern. Ein wesentliches Anliegen ist, dass aktuelle Tokenizer Subworte am Wortanfang anders behandeln als solche im Inneren, was vor allem der Rückverfolgbarkeit und String-Rekonstruktion dient. Es wird diskutiert, ob alternative Ansätze denkbar sind, die einheitlichere und zugleich präzisere Wortdarstellungen zulassen, etwa durch zusätzliche Eingabemaske, die Wortgrenzen kenntlich macht. Darüber hinaus wird die rein kompressionsbasierte Vorverarbeitung hinterfragt.

Im Gegensatz zur Bildverarbeitung, bei der neuronale Netze direkt die Rohdaten – also Pixel – verarbeiten, sehen einige Experten Potenzial darin, Sprachmodelle ebenfalls auf Charakter- oder Byte-Ebene zu trainieren. Dies könnte die Modellarchitektur näher an sprachliche Phänomene heranführen und eine flexiblere Repräsentation von Sprache ermöglichen. Praktische Hürden bestehen dabei in der effizienten Verarbeitung längerer Sequenzen, da der Transformer beispielsweise mit quadratischem Aufwand bezüglich der Sequenzlänge skaliert. Es gibt daher Ansätze, bei denen Modelle Sprachstrukturen hierarchisch verstehen, indem sie zunächst kurze Fenster von Zeichen sequenziell verarbeiten und daraus abstrahierte Repräsentationen bilden, welche dann auf höheren Ebenen kombiniert werden. Solche Modelle könnten Tiefe und Komplexität der Sprache besser abbilden ohne prohibitiv hohe Rechenkosten zu verursachen.

Abschließend lässt sich festhalten, dass die Qualität der Tokenisierung ein fundamentaler Faktor ist, der die Leistungsfähigkeit von Sprachmodellen maßgeblich beeinflusst. Während Byte Pair Encoding noch dominiert, zeigt die Unigram-Sprachmodellierung eine vielversprechende Alternative mit Vorteilen in Morphologieerkennung, Trainingseffizienz und Modellverständnis. Die Zukunft der Sprachmodellierung könnte von einem tiefergehenden Verständnis und der Integration linguistischer Strukturen in die Tokenisierung profitieren und damit Leistungsbarrieren überwinden, die durch rein datengetriebene Kompressionstechnik gesetzt sind. Die Forschung bleibt gespannt auf weitere Innovationen und verbesserte Ansätze zur effizienten und zugleich semantisch adäquaten Sprachrepräsentation.