Deep Learning hat in den letzten Jahren einen bemerkenswerten Aufschwung erlebt. Was einst als experimentelles Forschungsfeld galt, ist heute eine grundlegende Technologie, die von selbstfahrenden Autos über Sprachassistenten bis hin zu medizinischer Bildgebung nahezu alle Lebensbereiche revolutioniert. In diesem Kontext bieten die Alchemist’s Notes von Kevin Frans eine wertvolle Ressource, um in die faszinierende Welt des Deep Learning einzutauchen – mit einem tiefen Verständnis, das sowohl theoretische Grundlagen als auch praktische Anleitungen umfasst. Die Bezeichnung "Alchemist’s Notes" weist auf eine besondere Herangehensweise hin, die dem tiefen Lernen als einer Art moderner Alchemie gerecht wird. Deep Learning ist noch keine exakte Wissenschaft, vielmehr gleicht es einem Prozess des Experimentierens und Entdeckens.

Die gesammelten Erkenntnisse ähneln eher Fragmente aus einer unvollständigen Formel als einem fertigen Gesetz. Dies unterstreicht die Notwendigkeit, offen für neue Ideen zu sein und bewährte, aber nicht unverrückbare, Methoden flexibel anzuwenden. Die Inhalte der Notes richten sich an Leser mit mindestens grundlegendem Verständnis im Bereich Maschinelles Lernen sowie einer gewissen Vertrautheit mit der Programmiersprache Python. Von dort aus werden theoretische Definitionen und praxisnahe Beispiele miteinander verwoben, um komplexe Konzepte verständlich darzustellen. Dabei liegt ein großer Fokus auf der Nutzung konkreter Codebeispiele, oft in Form von Jupyter-Notebooks mit Möglichkeiten zur interaktiven Bearbeitung, was den Lernprozess besonders effektiv und zugänglich gestaltet.

Ein zentrales Element der Alchemist’s Notes ist die Einbindung von JAX, einem modernen numerischen Toolkit, das vor allem für maschinelles Lernen und insbesondere für Deep Learning entwickelt wurde. JAX kombiniert die Vorteile von automatischer Differenzierung und hochoptimierter linearen Algebra, was es ermöglicht, neuronale Netzwerke effizient zu trainieren und zu evaluieren. In Kombination mit Flax, einer auf JAX aufbauenden Bibliothek für neuronale Netze, bietet das Framework eine leistungsfähige und flexible Basis, um Modelle auf professionelle Weise zu erstellen und zu verfeinern. Die Notes behandeln alle fundamentalen Bausteine, die für den Aufbau neuronaler Netzwerke notwendig sind. Dazu zählen lineare Schichten, Aktivierungsfunktionen, Normalisierungen, Residual-Strukturen, Faltungs- und Rekurrente Netze sowie das Aufmerksamkeitsprinzip, das insbesondere bei Transformern von zentraler Bedeutung ist.

Dies garantiert einen ganzheitlichen Einblick, der sowohl klassischen Architekturen als auch modernen bahnbrechenden Methoden gerecht wird. Besonderes Augenmerk wird auch auf den Trainingsprozess gelegt. Die Techniken des Backpropagation sind ebenso eingehend erläutert wie Optimierungsmethoden, die das quasimathematische Herzstück erfolgreicher Netzwerke darstellen. Zusätzlich enthält die Sammlung Überblicke zu weiterführenden Themen wie Lernraten-Scheduling oder sogar Second-Order Optimierung, um tiefer in die Feinheiten moderner Trainingsverfahren einzutauchen. Das Verständnis von Modellen verschiedener Klassen wird durch direkt anwendbare Beispiele verstärkt.

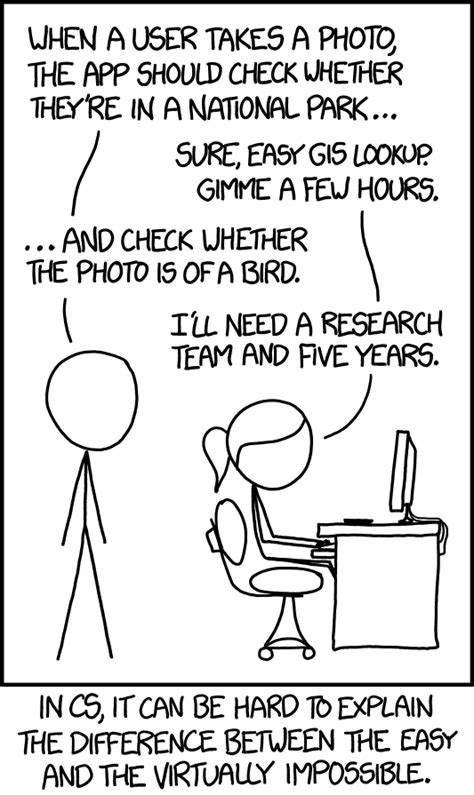

Angefangen bei Klassifizierungs-Aufgaben über Variationale Autoencoder, Generative Adversarial Networks bis hin zu Diffusionsmodellen und autoregressiven Modellen, die unter anderem große Sprachmodelle (LLMs) etablieren, bekommen Lernende einen umfassenden Einblick in diverse Facetten des Generativen und Diskriminativen Lernens. Der Begriff "Alchemist" ist dabei kein Zufall. Deep Learning steckt noch immer in einer Phase des Umbruchs, vergleichbar mit dem historischen Übergang von der Alchemie zur modernen Chemie. Es gibt zwar viele bewährte Techniken und fundamentale mathematische Grundlagen, doch eine übergreifende, vollständig einheitliche Theorie fehlt weiterhin. Dies macht das Gebiet spannend, jedoch auch herausfordernd, da immer wieder neue Experimente und Ansätze erprobt und kritisch hinterfragt werden müssen.

Neben der theoretischen Tiefe zeichnen sich die Alchemist’s Notes auch durch ihre Praxisorientierung aus. Die zugrunde liegenden Codebeispiele und Jupyter-Notebooks laden zum Mitmachen und eigenen Experimentieren ein. So können Interessierte nicht nur den Theorievortrag passiv verfolgen, sondern aktiv Modelle erstellen, testen und anpassen. Dies fördert ein intensiveres Verständnis und hilft, den oft abstrakten Stoff greifbar zu machen. Darüber hinaus eröffnet der strukturierte Aufbau der Notes den Zugang zu weiterführenden Themen.

Neben den Kernbereichen bietet die Sammlung auch Kapitel zu fortgeschrittenen Gebieten wie Meta Learning, Reinforcement Learning, Multi-GPU-Parallelismus oder Mixed Precision Training an. Damit wird ein umfassendes Bild gezeichnet, das nicht nur für Einsteiger passend ist, sondern auch für fortgeschrittene Forscher und Entwickler inspirierende Impulse liefert. Der Autor selbst ist tief in der Forschung verwurzelt und nutzt die Alchemist’s Notes als lebendes Dokument, das er kontinuierlich erweitert, korrigiert und ergänzt. Der offene Charakter des Projekts – etwa durch die Möglichkeit, Feedback zu geben oder eigene Ideen einzubringen – macht es zu einer lebendigen Community-Ressource, die den aktuellen Stand der Forschung und Technik reflektiert. Neben den reinen Lerninhalten geben die Notes auch eine ehrliche Einschätzung der Herausforderungen und Unwägbarkeiten im Deep Learning.

Es wird klar gemacht, dass erfolgreiche Modelle oft das Ergebnis langwieriger Entwicklung und sorgfältiger Analyse sind und dass auch bekannte Methoden keine Garantien bieten, sondern stets mit kritischem Blick betrachtet und an die jeweilige Problemstellung angepasst werden müssen. Zusammenfassend bieten die Alchemist’s Notes von Kevin Frans einen außergewöhnlichen Kompass durch die komplexe Welt des Deep Learning. Sie verbinden akademisches Wissen mit praktischer Anwendung, verbinden mathematische Formalismen mit handfestem Programmiercode und mahnen zugleich zur Bescheidenheit, da der Stand der Technik weiterhin in Bewegung ist. Für alle, die sich mit Leidenschaft und technischem Anspruch den Herausforderungen moderner neuronaler Netzwerke stellen wollen, sind die Notes ein unverzichtbarer Begleiter. Der Weg des Lernens im Deep Learning gleicht dem eines Alchemisten: Experimente, Beobachtungen und stetiges Verfeinern führen Schritt für Schritt zu neuen Erkenntnissen.

Mit diesem Verständnis ausgestattet, ist man bestens gerüstet, um die faszinierenden Möglichkeiten der Künstlichen Intelligenz aktiv mitzugestalten und selbst Teil einer Bewegung zu werden, die unsere Welt nachhaltig verändern wird.

![Anthropic: The "Spiritual Bliss" Attractor State [pdf]](/images/79EE285C-EF19-48D1-95AF-2B8B38AB1B24)