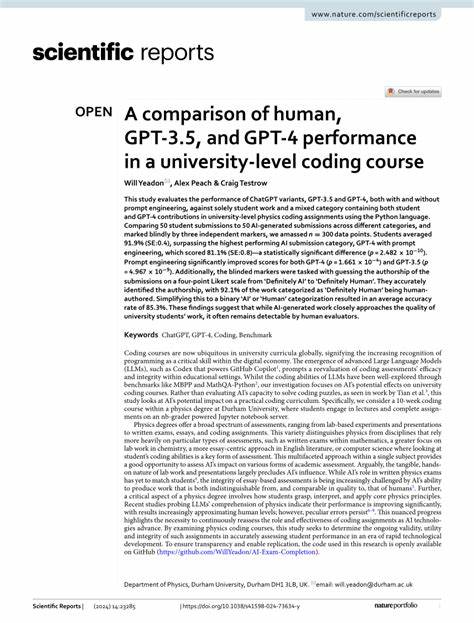

Mit dem rapiden Fortschritt künstlicher Intelligenz und insbesondere der Entwicklung großer Sprachmodelle (Large Language Models, LLMs) wie GPT entfaltet sich ein tiefgreifender Wandel in der Hochschulbildung. Die Einbindung solcher Modelle in akademische Umwelt stellt sowohl eine Chance als auch eine Herausforderung dar. Dabei rückt insbesondere die Frage in den Fokus, wie gut KI-Systeme in anspruchsvollen, beweisbasierten Universitätskursen performen, in denen komplexes Problemlösen und logisches Denken gefordert sind. Aktuelle Forschungsarbeiten, speziell eine im Mai 2025 veröffentlichte Studie mit dem Titel „Assessing GPT Performance in a Proof-Based University-Level Course Under Blind Grading“, bringen aufschlussreiche Erkenntnisse über die Stärken und Grenzen von GPT-4o sowie dem Modell o1-preview in einer realistisch gestalteten Prüfungssituation zutage. Die Analyse erfolgte in einem Algorithmen-Kurs auf Bachelor-Niveau, einer Domäne, die präzises formales Denken und rigorose Beweisführung verlangt.

Die Besonderheit lag darin, dass die von GPT generierten Lösungen anonym von Lehrassistenten bewertet wurden, die keine Kenntnis über die Herkunft der Antworten hatten. Dieses blinde Bewertungskonzept verhindert mögliche Verzerrungen und gewährleistet eine objektive Einschätzung der Leistungsfähigkeit der KI. Die Ergebnisse legen nahe, dass GPT-4o hinsichtlich der Erreichung des Bestehensniveaus deutlich hinter Erwartungen zurückbleibt. Zwar verfügt das Modell über beeindruckende generelle Text- und Programmierfähigkeiten, jedoch fehlt es ihm offenbar an der nötigen Tiefe und Verlässlichkeit, um komplexe Beweise überzeugend und vollständig zu führen. Diese Defizite zeigen sich unter anderem in Form falscher oder unzureichend begründeter Aussagen, die das Gesamtverständnis der Prüfungsfragen beeinträchtigen.

Im Kontrast dazu schneidet das Modell o1-preview überraschend gut ab. Es gelingt diesem, die Bestehensgrenze zu überschreiten und in einigen Aufgaben sogar die Medianleistung der menschlichen Studierenden zu übertreffen. Diese Insights sind besonders relevant, da sie belegen, dass moderne KI-Modelle in der Lage sind, komplexe akademische Inhalte zu verarbeiten und in gewissem Maße zu replizieren. Allerdings offenbaren auch hier die eingehendere Analyse und das Aufspüren von Fehler- und Fehlinterpretationsmustern bedeutende Schwächen. Unrechtfertigte Behauptungen, die teils irreführend wirken, bleiben ein Problem.

Dieses Verhalten verweist darauf, dass bei der Bewertung von KI-Ergebnissen besondere Sorgfalt geboten ist. Die Implikationen dieser Befunde für die Hochschulbildung sind vielfältig. Zum einen zeigen sie, dass LLMs wie GPT zunehmend als Hilfsmittel im Lernprozess eingesetzt werden können, etwa zur Anregung von Denkprozessen oder zur Voranalyse von Problemstellungen. Zum anderen betonen sie die Notwendigkeit, Prüfungs- und Bewertungssysteme anzupassen, um Verfälschungen durch KI-Nutzung wirksam zu begegnen. Dabei kann der Einsatz von Blindbewertungen oder KI-gestützten Analysetools eine wichtige Rolle spielen.

Die Studie unterstreicht darüber hinaus ein breiteres pädagogisches Thema: KI-Technologien verändern Grundprinzipien der Wissensvermittlung und fordern Bildungseinrichtungen heraus, neue Lehrkonzepte zu entwickeln, die sowohl die Potenziale der KI nutzen als auch deren Grenzen klar kommunizieren. Das Konzept des autonomen, logischen Beweisens kann so durch interaktive, KI-gestützte Methoden ergänzt und vertieft werden. Neben den reinen Leistungskennzahlen ist auch die qualitative Untersuchung der Fehlerarten aufschlussreich. Sie geben Aufschluss darüber, welche Denkprozesse GPT derzeit noch schwerfallen und wie Algorithmen weiterentwickelt werden müssten, um verlässliche und nachvollziehbare Beweise generieren zu können. Hier wird deutlich, dass nicht nur die reine Sprach- und Wissensgeneration zählt, sondern vor allem das explizite Nachvollziehen und begründete Argumentieren im Zentrum steht.

Diese Erkenntnisse haben nicht nur im Fachbereich der Informatik Bedeutung, sondern erweisen sich als exemplarisch für die breite Debatte um KI im akademischen Kontext. Universitäten müssen sich auf diese Entwicklung einstellen, indem sie nicht nur technische, sondern auch ethische und methodische Strategien entwickeln, um KI sinnvoll und verantwortungsbewusst zu integrieren. Zusammenfassend zeigt die Untersuchung, dass GPT-Modelle zwar beeindruckende Fortschritte im Umgang mit akademischen Problemstellungen gemacht haben, aber in stark beweisorientierten Kontexten nach wie vor an Grenzen stoßen. Das liefert wertvolle Anhaltspunkte für Forscher, Lehrende und Bildungspolitiker, die die Digitalisierung der Hochschullandschaft aktiv gestalten wollen. Erkenntnisse aus solchen Studien tragen dazu bei, die Balance zwischen technologischer Unterstützung und unverzichtbarem menschlichem Urteilsvermögen zu wahren und akademische Standards auch im Zeitalter der KI hochzuhalten.

Die kommenden Jahre werden zeigen, wie sich LLMs und andere KI-Werkzeuge weiterentwickeln und in welchem Umfang sie die Hochschulbildung transformieren werden. Entscheidend bleibt dabei, dass alle Beteiligten den Dialog suchen und Lernprozesse stets kritisch-reflektiert begleiten, um das Potential intelligenter Maschinen zum Wohle der Gesellschaft optimal zu nutzen.

![The "standard" car charger is usually overkill [video]](/images/F44E99ED-9D99-4595-9C8F-0CD0F178AA25)