In der Welt der Künstlichen Intelligenz spielt die Strukturierung von Ausgaben eine immer wichtigere Rolle. Mit dem zunehmenden Einsatz von großen Sprachmodellen (LLMs) und dem Wunsch nach präzisen, wohlgeformten Antworten wächst der Bedarf an effektiven Frameworks zur Modellierung von Ausgaben. Ein populäres Werkzeug hierfür ist Pydantic, das klar definierte, typisierte Datenstrukturen ermöglicht. Doch steht man im Entwicklungsprozess oft vor einer scheinbar banalen, aber dennoch wirkungsvollen Frage: Beeinflusst die Reihenfolge der Felder in einem Pydantic-Datenmodell die Qualität oder die Leistung des KI-Modells? Diese Frage ist nicht nur akademischer Natur. Sie hat tiefgreifende Auswirkungen auf die Gestaltung von Anwendungen, die auf LLMs basieren und strukturierte Antworten benötigen.

Im Folgenden soll untersucht werden, welche Effekte unterschiedliche Feldanordnungen auf die Modellergebnisse haben, insbesondere im Kontext von Aufgaben, die mehr oder weniger reasoning-intensiv sind. Ausgangspunkt der Überlegung ist das Verhalten von Modellen, wenn sie eine strukturierte Antwort generieren müssen, die aus mehreren Feldern besteht. Ein Beispiel wäre ein Agenten-Output, der sowohl eine direkte Antwort als auch eine Begründung enthalten soll. Die intuitive Annahme könnte sein, dass die Reihenfolge der Felder keine Rolle spielt, da das Modell alle relevanten Informationen insgesamt verarbeiten und ausgeben sollte. Doch verschiedene Szenarien legen nahe, dass gerade die Reihenfolge Einfluss auf die Art und Weise haben kann, wie das Modell die Antwort konstruiert.

Es gibt Theorien, die darauf hinweisen, dass bei reasoning-intensiven Aufgaben das Voranstellen von Feldern, die eine Begründung oder eine gedankliche Herleitung beinhalten, das Modell dazu bringt, eher im Sinne eines Chain-of-Thought-Denkprozesses zu agieren. Dadurch könnte die Qualität der Antwort verbessert werden, indem sie besser durchdacht und nachvollziehbar wird. Im Gegensatz dazu könnte das Modell bei direkt gefragtem Antwortfeld zuerst eher geneigt sein, eine schnelle Antwort zu generieren, die im Nachgang rationalisiert wird, was die Qualität und Korrektheit negativ beeinflussen könnte. Um diese Hypothesen empirisch zu überprüfen, wurden Untersuchungen mit realen Daten durchgeführt. Als Grundlage diente eine spezielle Klassifikationsaufgabe mit einem Gemälde-Stil-Datensatz von HuggingFace.

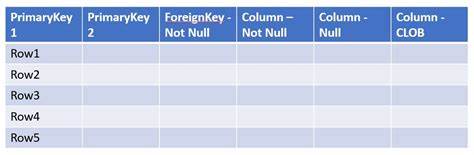

Dort geht es darum, Gemälde ihrem Stil zuzuordnen. Eine Herausforderung hierbei ist die Erweiterung der Aufgabe innerhalb einer “Hard Task”, die das Modell nicht nur anweist, die Klassifikation durchzuführen, sondern daraufhin noch eine Auswahl unter vorgegebenen Strings zu treffen, welche Anforderungen an die Länge erfüllen, die dynamisch vom vorherigen Ergebnis abhängen. Dieses Setting erfordert deutlich mehr reasoning als eine einfache Klassifikation und eignet sich daher, um den Einfluss der Feldreihenfolge auf reasoning-intensive Prozesse zu prüfen. Die Strukturierung der Ausgaben der KI erfolgt mittels Pydantic-Modellen, bei denen einmal das Antwortfeld (answer) vor der Begründung (reasoning) und einmal umgekehrt definiert wurde. Die Resultate aus verschiedenen Modelltests zeigen je nach Modell und Aufgabenkomplexität unterschiedliche Auswirkungen.

In einfachen Aufgaben zeigen sich teilweise marginale Unterschiede in der Genauigkeit, wobei keine klare Richtung dominiert. Interessanter wird es bei den komplexeren Aufgaben, wo manchmal die Anordnung mit Begründung zuerst zu besseren Ergebnissen führen kann, in anderen Fällen jedoch auch das Gegenteil zutrifft. Die Ergebnisse deuten darauf hin, dass kein simples Patentrezept existiert und die Wirkung der Feldreihenfolge stark von Modellarchitektur, Aufgabenstellung und wahrscheinlich auch Trainingsdaten abhängt. Dennoch ist die Untersuchung wichtig, da sie die Sensibilität moderner KI-Modelle gegenüber subtilen Einflussfaktoren hervorhebt. Für Entwickler und Forscher bedeutet dies, dass es sich lohnt, die Anordnung von strukturierten Antwortfeldern bewusst zu gestalten und zu experimentieren, um optimale Ergebnisse zu erzielen.

Zudem reflektiert diese Beobachtung die Tatsache, dass große Sprachmodelle nicht als reine deterministische Systeme zu betrachten sind, sondern eher als komplexe statistische Modelle, deren Verhalten von Aufgabenkontext, Eingabepräsentation und kleinsten Details abhängen kann. Ein weiterer Aspekt ist die Rolle von sogenannten Chain-of-Thought Promptings, also Eingabeaufforderungen, die das Modell anregen, seine Antworten schrittweise zu entwickeln. Das Voranstellen von bestimmten Feldern kann eine formale Entsprechung einer solchen Strategie sein, indem die Modellstruktur es erzwingt, zunächst die Gedankengänge zu formulieren, bevor die eigentliche Antwort erfolgt. Diese Erkenntnis könnte in Zukunft helfen, bessere Promptings und Datenstrukturen für verschiedenste Aufgaben zu entwickeln. Abgesehen von der Reihenfolge der Felder stellt die Verwendung von klar definierten, typisierten Modellen wie Pydantic sicher, dass die Antworten der KI eine vorhersagbare Struktur haben.

Dies erleichtert nicht nur die automatische Auswertung und Integration in Anwendungen, sondern erhöht auch die Robustheit gegenüber fehlerhaften Ausgaben. Zusammenfassend kann gesagt werden, dass die Reihenfolge der Felder in Pydantic- und ähnlichen Modellen durchaus einen Einfluss auf das Modellverhalten und deren Leistung haben kann. Dies hängt stark vom Charakter der Aufgabe und der eingesetzten Modellversion ab. Die Komplexität moderner KI-Systeme führt dazu, dass selbst kleine Änderungen in der Struktur der erwarteten Ausgabe zu spürbaren Abweichungen führen können. Für die Praxis bedeutet dies, dass Entwickler die Feldreihenfolge nicht als triviale Designentscheidung betrachten sollten.

Stattdessen lohnt es sich, mit verschiedenen Anordnungen zu experimentieren und diese empirisch zu validieren. Die Wissenschaft der KI-Ausgabeformatierung ist somit ein aufstrebendes Feld, das noch weitere Forschungen erfordert, um allgemeingültige Prinzipien abzuleiten. Ein tieferes Verständnis könnte langfristig dazu beitragen, KI-Systeme vertrauenswürdiger, transparenter und effizienter zu gestalten. Im Ergebnis ist die Frage, ob die Feldreihenfolge die Modellleistung beeinflusst, nicht einfach mit Ja oder Nein zu beantworten. Vielmehr handelt es sich um ein multidimensionales Thema, das subtile Wechselwirkungen aufweist und vor allem dazu motiviert, neue Wege zu finden, um die Fähigkeiten von LLMs gezielt zu verbessern.

Für die Zukunft ist zu erwarten, dass Entwickler zunehmend auf solche Details achten und damit die nächste Generation leistungsfähiger und nutzerfreundlicher KI-Anwendungen formen werden.