Die rasante Entwicklung der Künstlichen Intelligenz (KI) wirft auch die Frage nach geeigneter Hardware auf, die den hohen Rechenanforderungen moderner Algorithmen gerecht wird. Klassische digitale Computersysteme stoßen zunehmend an ihre Grenzen, sowohl in puncto Geschwindigkeit als auch Energieeffizienz. In diesem Kontext gewinnen thermodynamische Computersysteme an enormer Bedeutung, da sie eine revolutionäre Herangehensweise an das Rechnen bieten, basierend auf den physikalischen Prinzipien der Thermodynamik und Stochastik. Diese Systeme bieten insbesondere für probabilistische und generative KI-Modelle Vorteile, welche mit konventioneller Hardware nur schwer realisierbar sind. Thermodynamische Computer verwenden physikalische Prozesse, die auf Zufallsdynamiken und Energieminimierungsprinzipien basieren, um komplexe Rechenaufgaben effizient zu lösen.

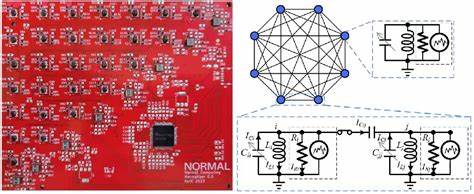

Die Grundlage bildet die mathematische Beschreibung von Systemen, die sich in einem thermodynamischen Gleichgewicht befinden und deren Variablen stochastischen Differentialgleichungen genügen. Die sogenannte Langevin-Dynamik ermöglicht es, kontinuierliche Wahrscheinlichkeitsverteilungen zu simulieren, was besonders gut zu den Anforderungen moderner KI-Modelle passt, die auf Wahrscheinlichkeitsverteilungen, Bayesscher Inferenz und Unsicherheitsquantifizierung basieren. Eine praktische Umsetzung dieser Vision erfordert spezialisierte Hardware. Ein beeindruckendes Beispiel hierfür ist der sogenannte Stochastische Verarbeitungseinheit (SPU), ein thermodynamischer Computer, der aus kapazitiv gekoppelten RLC-Schaltungen aufgebaut ist. Jede Einheit funktioniert als Oszillator mit einer Kombination aus Widerstand, Induktivität und Kapazität, die alle miteinander gekoppelt sind, um komplexe Wechselwirkungen abzubilden.

Die Steuerung von Rauschquellen ist dabei nicht nur unerlässlich, sondern fördert geradezu die Funktionsweise, da das eingebrachte Rauschen wichtige stochastische Elemente zur Berechnung liefert. Ein entscheidender Vorteil der thermodynamischen Computing-Architektur liegt in ihrer Fähigkeit, Mittelwerte und Wahrscheinlichkeitsverteilungen aktiv und natürlich aus der physikalischen Dynamik abzuleiten. Im Rahmen der Anwendung bei KI kann dies beispielsweise bedeuten, dass das System direkt von der Hardware aus Stichproben aus einer gewünschten Wahrscheinlichkeitsverteilung zieht, etwa einer multivariaten Gaußverteilung, oder große Matrizen invertiert – eine Grundlage für viele Optimierungs- und Lernverfahren in der KI. Diese Operationen sind für konventionelle digitale Systeme sehr rechenintensiv und verbrauchen viel Energie, während sie sich mit thermodynamischen Computern potenziell schneller und energieeffizienter durchführen lassen. Die Experimente mit einem achtzelligen SPU führen zu überzeugenden Ergebnissen: Das System zeigt eine gute Übereinstimmung zwischen den theoretischen Erwartungswerten und den tatsächlich auf der Hardware gesammelten Daten.

Insbesondere die Samples der Spannung über den Kondensatoren entsprechen den erwarteten Gaußverteilungen, und auch komplexe Operationen wie die Inversion von Matrizen gelingen mit hoher Genauigkeit. Diese Ergebnisse sind ein Meilenstein und belegen, dass thermodynamische Computer eine praktikable Alternative oder Ergänzung zu traditionellen Computern sein können, wenn es um anspruchsvolle KI-Anwendungen geht. Ein weiteres wichtiges Thema ist die Skalierung dieser Technologie. Während die aktuell existierenden Prototypen relativ klein sind, bestehen vielversprechende Ansätze, thermodynamische Hardware auf größere Dimensionen zu erweitern, wodurch sich signifikante Performancevorteile gegenüber modernen GPUs erzielen lassen. Theoretische Modelle zeigen, dass ab einer gewissen Problemgröße der sogenannte thermodynamische Vorteil zum Tragen kommt – also der Punkt, an dem thermodynamische Systeme schneller und energieschonender sind als digitale Alternativen.

Bei Dimensionen von ca. 3000 Variablen scheint dieser Punkt erreichbar zu sein, mit einem erwarteten Performancegewinn um eine Größenordnung bei 10.000 Variablen. Dabei geht es nicht nur um Zeitersparnis, sondern auch um Energieeffizienz. Intelligente, energieeffiziente Hardware wird zunehmend bedeutsam, gerade vor dem Hintergrund des steigenden Energieverbrauchs durch große Rechenzentren und die Umweltbelastung durch umfangreiche KI-Trainingsprozesse.

Thermodynamische Systeme nutzen die natürlichen physikalischen Prozesse, was einen deutlich geringeren Energieverbrauch ermöglicht – Studien deuten auf Einsparungen von bis zu zehnfach im Vergleich zu aktuellen Hochleistungs-GPUs hin. Technologische Herausforderungen bestehen jedoch weiterhin. Die Integration von Induktivitäten und Transformatoren in integrierte Schaltkreise ist kompliziert, insbesondere wegen der Größe und der elektromagnetischen Störungen, was die Skalierung erschwert. Aufgrund dessen wird ein alternativer Architekturansatz diskutiert, bei dem auf induktive Elemente verzichtet wird und stattdessen reine Widerstands-Kapazitäts-Netzwerke verwendet werden. Diese neuartige Architektur ist besser für die Miniaturisierung und die Einbettung in CMOS kompatible Chips geeignet.

Simulationen und Schaltkreissimulationen (SPICE-Modelle) zeigen, dass mit dieser Architektur vergleichbare Ergebnisse erzielt werden können und die Fehler durch Nichtidealitäten in akzeptablen Grenzen gehalten werden. Neben den rein hardwaretechnischen oder physikalischen Aspekten bietet thermodynamisches Computing ein enormes Potenzial, um die Grenzen aktueller KI-Methoden zu erweitern. Probabilistische KI-Modelle, die in der Praxis auf Stichprobenverfahren und Approximationen beruhen, können durch diese physikalisch-stochastischen Systeme beschleunigt werden. Dadurch werden für Anwendungen in medizinischer Diagnostik, autonomem Fahren oder Finanzmodellierung wichtige Unsicherheitsabschätzungen praktikabler und genauer, was zu vertrauenswürdigeren Entscheidungen führen kann. Auch die Integration mit bestehenden digitalen Kontroll- und Steuerungssystemen wurde bereits gezeigt – thermodynamische Computer funktionieren als Co-Prozessoren, die spezielle Rechenaufgaben auslagern, während klassische Hardware die Parametrierung übernimmt und die Ergebnisse weiterverarbeitet.

Die Symbiose zwischen analog physikalischer Dynamik und digitaler Flexibilität könnte einen neuartigen, hybriden Computertyp hervorbringen, der das Beste aus beiden Welten kombiniert. Die Wissenschaft steht bei thermodynamischem Computing noch am Anfang, und viele Fragen sind offen, etwa welche weiteren Algorithmen sich am besten für diese Hardware eignen oder wie die Fehlerkompensation bei großen Netzwerken optimiert werden kann. Einige Lösungsansätze zeigen bereits, dass man durch geschickte Mittelungstechniken oder Quantisierungsstrategien die Präzision steigern kann, ohne das physikalische System unnötig zu komplizieren. Besonders spannend ist auch das mögliche Zusammenspiel mit nicht-gaussischen Verteilungen und das Einbringen von nichtlinearen Bauteilen wie Transistoren, um komplexere probabilistische Modelle abbilden zu können. Dies öffnet den Weg zu fortgeschrittenen KI-Anwendungen wie generativen Modellen auf Basis von Diffusion oder der Bayesianischen Logistischen Regression.