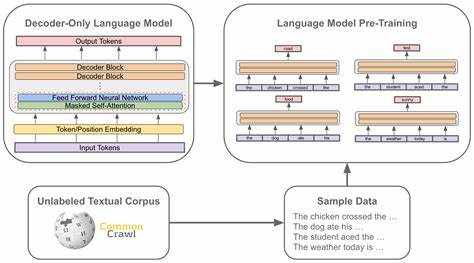

Die rasante Entwicklung großer Sprachmodelle (Large Language Models, LLMs) hat in den letzten Jahren die Art und Weise, wie künstliche Intelligenzen menschliche Sprache verstehen und generieren, revolutioniert. Parallel dazu gewinnt eine vielversprechende Methode namens Modellzusammenführung, insbesondere im Pre-Training großer Sprachmodelle, zunehmend an Bedeutung. Diese Technik zielt darauf ab, verschiedene trainierte Modellzustände miteinander zu vereinen, um daraus leistungsfähigere, effizientere und kostengünstigere Modelle zu entwickeln. Insbesondere vor dem Hintergrund der enormen Ressourcen, die das Pre-Training von Modellen mit mehreren Milliarden Parametern erfordert, bietet die Modellzusammenführung eine innovative Strategie zur Optimierung des Trainingsprozesses und zur Steigerung der Modelleffizienz. Modellzusammenführung bezieht sich auf das Verfahren, bei dem mehrere vortrainierte Modell-Checkpoints miteinander kombiniert werden, um ein Gesamtmodell zu schaffen, das von den Stärken der einzelnen Zustände profitiert.

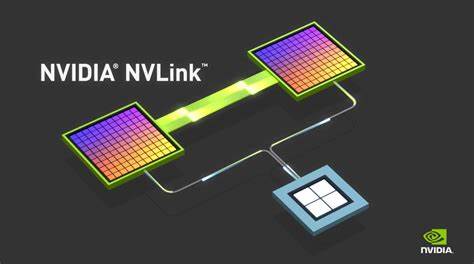

Im Gegensatz zu traditionellen Ansätzen, bei denen Modelle sequenziell weitertrainiert oder fine-getunt werden, ermöglicht die Zusammenführung eine parallele Nutzung existierender Trainingsfortschritte. Dies eröffnet nicht nur eine Zeitersparnis, sondern kann auch zu einer besseren generalisierenden Leistung des resultierenden Modells führen. Einer der zentralen Vorteile der Modellzusammenführung liegt in der verbesserten Effizienz des Pre-Trainingsprozesses. Da das Training großer Sprachmodelle immense Rechenressourcen beansprucht, stellen sich Fragen rund um die Reduzierung von Kosten und Energieverbrauch im Mittelpunkt. Durch das geschickte Kombinieren von Modellen, die etwa mit konstanten Lernraten trainiert wurden, lässt sich nicht nur der Trainingsaufwand reduzieren, sondern auch der Verlauf des Trainingsprozesses besser vorhersagen und steuern.

Dies bedeutet, dass Entwickler und Forscher Modelle deutlich schneller und mit weniger Ressourcenaufwand erstellen können, ohne dabei Abstriche bei der Modellqualität in Kauf zu nehmen. Das Potenzial der Modellzusammenführung entfaltet sich besonders prägnant bei verschiedenen Architekturtypen, darunter sowohl dichte Modelle als auch Mixture-of-Experts-Architekturen (MoE). Die MoE-Strukturen zeichnen sich durch ihre modulare Bauweise aus, bei der spezialisierte Teilmodelle (Experten) dynamisch für bestimmte Aufgaben aktiviert werden. Die Zusammenführung von MoE-Modellen ermöglicht die Kombination verschiedener Expertennetzwerke, was zu einer noch größeren Flexibilität und Leistungssteigerung führt. Diese Vielseitigkeit macht die Technik attraktiv für verschiedenste Anwendungsbereiche und modulare KI-Designs.

Die Praxis zeigt, dass Modelle, welche durch Zusammenführung von Checkpoints mit konstanten Lernraten entstanden sind, signifikante Leistungsverbesserungen aufweisen können. Gleichzeitig unterstützt dieses Verfahren die präzise Prognose des Modellsverhaltens unter Lernraten-Anpassungen, was im traditionellen Training ohne Modellzusammenführung schwieriger zu erreichen ist. Abgesehen von den Effizienzgewinnen trägt die Zusammenführung also auch zu einem besseren Verständnis der Trainingsdynamiken bei. Das wiederum hilft Forschern, gezieltere Hyperparameter-Einstellungen zu entwickeln und die Entwicklung neuer, noch leistungsfähigerer Modelle voranzutreiben. Neben den technischen Vorzügen bringen Untersuchungen zur Modellzusammenführung auch neue Erkenntnisse über die zugrunde liegenden Mechanismen ans Licht.

Durch umfangreiche Ablationsstudien wurde herausgefunden, dass die Wahl der Zusammenführungsstrategie und die Einstellung der Hyperparameter entscheidend für den Erfolg sind. Dabei gilt es, das richtige Gleichgewicht zwischen der individuellen Stärke der Modelle und ihrer Komplementarität zu finden. Der offene Austausch dieser Erkenntnisse und die Bereitstellung praktischer Richtlinien an die Open-Source-Community fördern die breite Akzeptanz und Weiterentwicklung dieser Methode. Die Implementierung der Modellzusammenführung im Pre-Training verspricht, den Entwicklungszyklus großer Sprachmodelle maßgeblich zu verändern. Zukünftig könnten Modellbausteine flexibler kombiniert und wiederverwendet werden, wodurch die Innovationsgeschwindigkeit in der KI-Forschung steigt.

Zudem bieten sich Potentiale, um spezialisierte Modelle für unterschiedliche Aufgaben in kompaktere und effektivere Einheiten zu integrieren – ein wichtiger Schritt hin zu vielseitigen KI-Systemen, die sich dynamisch an wechselnde Anforderungen anpassen. Insbesondere bei der Skalierung auf Modelle mit über hundert Milliarden Parametern stellt die Modellzusammenführung eine Schlüsseltechnik dar, um den enormen Trainingstransfer zu bewältigen. Große Organisationen und Forschungsinstitute, die sich der Entwicklung solcher Modelle widmen, profitieren von den Einsparungen bei Ressourcen und Kosten, ohne Kompromisse bei der Modellqualität einzugehen. Damit trägt die Methode nicht nur zur ökonomischen Effizienz bei, sondern auch zur ökologischen Nachhaltigkeit im Bereich des maschinellen Lernens. Neben den quantitativen Vorteilen beeinflusst die Modellzusammenführung auch den qualitativen Fortschritt im Bereich der Sprachmodellierung.

Die Kombination unterschiedlicher Trainingsphasen kann zu einer Verbesserung der Sprachverständnisfähigkeiten und Robustheit gegenüber sprachlichen Variationen führen. Diese verbesserte Generalisierungsfähigkeit ist besonders wichtig für praktische Anwendungen, die mit vielfältigen und komplexen Textdaten umgehen müssen. Insgesamt lässt sich feststellen, dass die Modellzusammenführung im Pre-Training großer Sprachmodelle ein zukunftsträchtiges Forschungsthema ist, das sowohl theoretische als auch praktische Innovationen vorantreibt. Ihre Anwendung ermöglicht nicht nur effizientere Modellentwicklung und Ressourcenersparnis, sondern eröffnet auch neue Wege zur Verbesserung der Leistungsfähigkeit und Flexibilität von KI-Systemen. Die stetige Erforschung optimierter Zusammenführungsstrategien und deren Integration in bestehende Trainingspipelines wird maßgeblich darauf Einfluss nehmen, wie leistungsstarke Sprachmodelle künftig gestaltet und eingesetzt werden.

Das Verständnis und die kontinuierliche Weiterentwicklung von Modellzusammenführung werden daher für Forschungseinrichtungen, Unternehmen und Entwickler gleichermaßen zu einem essentiellen Baustein auf dem Weg zu immer intelligenteren und anpassungsfähigeren Sprachmodellen. Die Veröffentlichung praxisorientierter Leitfäden und Open-Source-Tools stellt sicher, dass diese Technik nicht nur in exklusiven Labors verbleibt, sondern weltweit zur Demokratisierung und Beschleunigung von KI-Innovationen beiträgt.