Discord hat sich in den letzten Jahren zu einer der beliebtesten Kommunikationsplattformen entwickelt, insbesondere für Communities rund um Spiele, Bücher und verschiedene Hobbys. Doch so vielfältig die Inhalte auch sein mögen, das Auffinden von qualitativ hochwertigen Diskussionen, hilfreichen Ressourcen oder smarten Mitstreitern gestaltet sich oft schwierig. Vieles geht in der Flut an Nachrichten unter oder ist aufgrund der begrenzten Suchfunktionen der Plattform kaum auffindbar. Vor diesem Hintergrund entstand die Idee, ein freies, datenschutzorientiertes Archiv öffentlicher Discord-Server aufzubauen, um die Suche und Nutzung relevanter Inhalte zu erleichtern, ohne dabei die Privatsphäre der Nutzer zu gefährden. Die Entstehungsgeschichte dieses Projekts ist geprägt von großem persönlichem Engagement, technischer Kreativität und vielen Hindernissen.

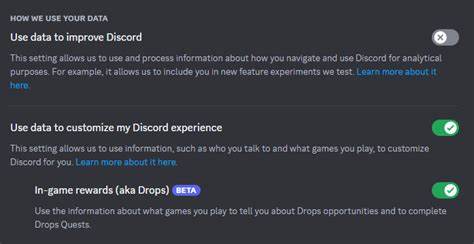

Der Entwickler beschreibt sich selbst als jemanden, der nicht professionell programmiert, aber dennoch mit viel Eigenmotivation und einem klaren Ziel versucht hat, die Plattform für eine Community von Lernenden und Spielern zugänglicher zu machen. Trotz begrenzter Ressourcen wie Zeit, Geld und Unterstützung setzte er auf pragmatische Lösungen, oft mit kleinen Abkürzungen, um das Projekt am Leben zu erhalten. Ein zentrales Anliegen war der Schutz der Privatsphäre. Im Gegensatz zu anderen Archiven wurden gezielte Maßnahmen implementiert, die verhindern sollten, dass einzelne Nutzer oder User IDs auffindbar sind. Die Suchfunktionen wurden bewusst so gestaltet, dass keine Rückschlüsse auf individuelle Teilnehmer gezogen werden können.

Außerdem wurde ein Ticket-System eingeführt, das es Community-Mitgliedern ermöglichte, mit einem Screenshot nachzuweisen, wenn bestimmte Server oder Nachrichten aus dem Archiv entfernt werden sollten. Dies half, Vertrauen aufzubauen und machte das Archiv moderationsfähig, ohne dass der Entwickler selbst Detektivarbeit leisten musste. Wenn Zweifel bestanden oder Nutzer versuchten, unberechtigt Zugang zu Servern zu erhalten, entschied er sich lieber, solche Server komplett zu entfernen, um Risiken zu minimieren. Die technische Umsetzung basierte auf einer Kombination moderner und bewährter Technologien. Unter anderem kam Elasticsearch zum Einsatz, eine leistungsfähige Suchmaschine, die speziell für große Datenmengen konzipiert ist.

Dabei wurde die Funktion _source deaktiviert, ein Schritt, den auch Discord in ihrem Blog als datenschutzfördernd empfiehlt. Für das Hosting der Infrastruktur wurde Proxmox genutzt, eine Open-Source-Plattform für Virtualisierung, die es erlaubte, verschiedene virtuelle Maschinen abzusetzen und die Arbeitslast zu verteilen. Diese VMs benötigten allerdings viel Arbeitsspeicher, was manchmal dazu führte, dass der Dienst auf dem Host-System selbst ausgeführt wurde, wenn die Ressourcen knapp wurden. RAIDZ, eine Art von Speichersystem, wurde eingesetzt, um Kosten zu sparen, obwohl es nachträglich Nachteile bei der Geschwindigkeit des Speicherzugriffs gab. Auf der Frontend-Seite kam SvelteKit zum Einsatz, ein modernes Framework für Webanwendungen, das schlanken und schnellen Code ermöglicht.

Um die Entwicklung zu beschleunigen, wurden Teile der Dokumentation von Svelte in eine KI eingespeist, die dann half, eine Benutzeroberfläche zu generieren. Künstliche Intelligenz spielte auch bei anderen Herausforderungen eine unterstützende Rolle – etwa bei der Fehlersuche oder bei Optimierungen – war jedoch nicht in der Lage, alle Probleme selbstständig zu lösen. Die Arbeit an dem Projekt erforderte ein hohes Maß an Sorgfalt und die Fähigkeit, auch scheinbar unaufwendige Details schnell zu entdecken, um größere Probleme frühzeitig zu verhindern. Trotz der vielen Erfolge gab es auch Rückschläge und Erkenntnisse, die der Entwickler im Nachhinein als Fehler oder vermeidbare Probleme einstuft. Ein Beispiel dafür ist der Einsatz von ScyllaDB, einer NoSQL-Datenbank, die durch hohe CPU-Auslastung herausfordernd im Betrieb war.

Evolutive Verbesserungen, etwa durch die Integration eines Monitoring-Stacks, wurden erst spät umgesetzt. Ebenso führten fehlende Mutexes in Golang zu unerwarteten Programmabstürzen. Ein weiterer Kritikpunkt war die anfängliche Entscheidung, Elasticsearch ohne Sharding einzusetzen, was bei mehreren Milliarden Dokumenten zu Datenverlusten führte. Aus betriebstechnischer Sicht wurden auch die Nachteile fehlender Testumgebungen deutlich. Fehlerhafte Datenbankabfragen direkt auf Live-Systemen beeinträchtigten Performance und Stabilität.

Das bewusste Abschalten von Schreib-Barrieren, um die Entwicklertätigkeit zu beschleunigen, erwies sich als zweischneidiges Schwert, da bei Stromausfällen wichtige Daten verloren gingen. Solche Fehler zeigen, wie wichtig sorgfältige Planung und professionelle Infrastrukturen gerade bei datenintensiven Anwendungen sind, um langfristigen Erfolg zu sichern. Finanziell war das Projekt eine Herausforderung. Der Entwickler arbeitete in den Ferien als Aushilfe, sparte Kosten durch günstige oder co-lokalisierte Server und nutzte RAIDZ, um Speichermedien effizient zu verwalten. Dennoch war der laufende Aufwand durch Servermieten und notwendige Wartung hoch, was langfristig nicht tragbar war.

Letztlich führte dies zur Entscheidung, das Archiv zu schließen. Trotz der Beendigung des Projekts bleibt der Nutzen solcher datenschutzorientierter Archivlösungen unbestritten. Gerade Communities, die auf der Suche nach Antworten oder Austauschmöglichkeiten sind, profitieren von solchen Nachschlagewerken. Neuere Plattformen wie Answer Overflow, die auf Opt-in basieren und einen ähnlichen Zweck verfolgen, werden als Alternative empfohlen. Aus technischer Sicht zeigt das Projekt, wie vielfältig moderne Tools und Frameworks in einem kleinen, aber ambitionierten Vorhaben zusammenspielen können – von KI-Unterstützung, über Open-Source-Hosting-Lösungen bis hin zu performanten Suchtechnologien.