In der Welt der Hochleistungsnetzwerke und Supercomputer gibt es Technologien, die im Verborgenen arbeiten, aber maßgeblich den Fortschritt vorantreiben. Remote Direct Memory Access, kurz RDMA, zählt zu diesen innovativen Technologien und hat sich zu einem der entscheidenden Treiber für schnelle Netzwerke entwickelt, die heute die leistungsfähigsten Supercomputer und Rechenzentren weltweit antreiben. Ursprünglich eine eher unbekannte Idee, verwandelte sich RDMA durch mehrere glückliche Zufälle und innovative Pionierarbeit in den Treibstoff, der moderne Hochleistungs- und KI-Systeme erst ermöglicht. Die Geschichte von RDMA zeigt, wie eine technische Offenbarung und strategische Partnerschaften das Rückgrat leistungsintensiver Systeme bilden konnten und wie diese Technologie eine zentrale Rolle in der evolutionären Entwicklung von Netzwerken spielt. Aufgrund seines fundamentalen Ansatzes, den Speicherzugriff über Netzwerke auf eine effiziente und latenzarme Weise zu ermöglichen, revolutionierte RDMA die Art und Weise, wie Computer miteinander kommunizieren und Daten austauschen.

Die Ursprünge von RDMA reichen zurück in das Jahr 1993, als ein Team von Ingenieuren bei Hewlett-Packard das Konzept erstmals patentierte. Die Essenz besteht darin, Netzwerkkommunikation so zu gestalten, dass Systeme direkt auf den Arbeitsspeicher anderer Systeme zugreifen können, ohne die jeweiligen Prozessoren oder Betriebssysteme zu belasten. Dies reduziert die Latenz dramatisch, erhöht die Datenübertragungsrate und entlastet die CPUs massiv. Im Kern beseitigt RDMA das ineffiziente Wechselspiel von Datenanforderungen und Antworten, das viele traditionelle Netzwerkarchitekturen ausbremst. Diese technische Innovation versprach vor allem eines: eine deutlich höhere Effizienz bei der Verbindung hunderter oder tausender Computer in Hochleistungsrechenclustern.

Den Durchbruch für RDMA trug ein israelisches Startup namens Mellanox Technologies. Die Firma setzte früh auf das InfiniBand-Protokoll, das RDMA integriert und speziell für Hochleistungsnetzwerke entwickelt wurde. Eine Schlüsselszene in dieser Erfolgsgeschichte fand im August 2001 statt, als D.K. Panda, ein Professor an der Ohio State University, dem Marketing-Vizepräsidenten von Mellanox seine Forschungsergebnisse zum Message Passing Interface (MPI) vorstellte.

Pandas Arbeit erleichterte es Forschern, kostengünstige Cluster aus Standardkomponenten zusammenzustellen und diese in Hochleistungsrechner umzuwandeln. Das Problem damals waren die teuren, proprietären und nur eingeschränkt kompatiblen Netzwerklösungen von Firmen wie Myrinet und Quadrics. Mit der Kombination aus Pandas Softwarelösung und Mellanox’ InfiniBand-Hardware wurde eine kosteneffiziente und leistungsstarke Alternative geschaffen. Die enge Zusammenarbeit zwischen Universität, nationalen Forschungslabors und Mellanox führte dazu, dass die offene Software MVAPICH, die auf RDMA setzt, im Jahr 2002 auf der Supercomputing-Konferenz debütierte. Die hohe Leistung gegenüber bisherigen Technologien sorgte für einen Schneeballeffekt: Immer mehr Organisationen begannen, RDMA-basierte Lösungen zu übernehmen.

Das Resultat war eine Beschleunigung des Fortschritts bei Hochleistungsrechnern. Ein weiterer Meilenstein wurde durch den engagierten Informatikprofessor Srinidhi Varadarajan von der Virginia Tech gesetzt. Mit Unterstützung seiner Universität und staatlicher Fördermittel setzte er auf Apples damals brandneue Power Mac G5-Computer, die mit IBM PowerPC 970 Prozessoren ausgestattet waren. Varadarajan ordnete umgehend den Kauf von über 1000 dieser Systeme an – in der Hoffnung, diese über InfiniBand und RDMA zu vernetzen, um eine kostengünstige, aber leistungsstarke Supercomputer-Architektur zu schaffen. Die ungewöhnliche Bestellung sorgte sogar für ein Treffen mit Steve Jobs persönlich.

Die Entwicklung der InfiniBand-Integration und der passenden Treiber für den Apple Power Mac G5 war eine intensive, teils geheime Kooperation zwischen Mellanox-Ingenieuren vor Ort bei Apple in Cupertino, den Forschern der Virginia Tech und den Entwicklerteams in Israel. Dror Goldenberg, ein leitender Architekt von Mellanox, setzte sich dabei mit vollem Einsatz ein, arbeitete tagelang durch, um Probleme zu lösen, die nur im sehr großen Maßstab auftraten. Die Herausforderungen, beispielsweise bitweise Fehler im Netzwerk bei Tausenden verbundenen Rechnern, erforderten innovative Methoden und enormes technisches Know-how. Am Ende entstand mit dem System X ein 5,2-Millionen-Dollar-Supercomputer, der im November 2003 im TOP500-Ranking auf Platz 3 landete. Dieses System erreichte beeindruckende 10,3 Teraflops und machte deutlich, wie RDMA-basierte Netzwerke der Konkurrenz weit überlegen waren – bei einem Bruchteil der Kosten des damaligen Spitzenreiters, dem japanischen Earth Simulator.

RDMA und InfiniBand hatten sich damit in der Hochleistungsrechnerwelt fest etabliert. Immer mehr Systeme der TOP500-Liste setzen heute auf diese Technologie. Für Mellanox wurde dies zum bedeutenden Geschäftsfeld. Doch die Innovation blieb nicht auf Supercomputer beschränkt. Die Weiterentwicklung von RDMA brachte es in den Mainstream der Netzwerkkommunikation, insbesondere durch die Entwicklung von RDMA over Converged Ethernet (RoCE).

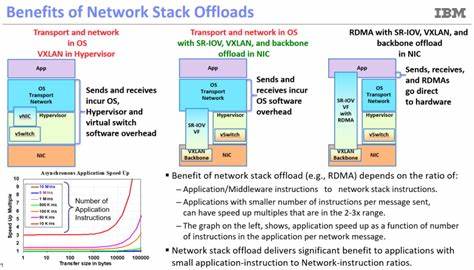

Diese Technologie, die ab 2010 standardisiert wurde, erlaubt es, RDMA-Funktionen über herkömmliche Ethernet-Netzwerke zu realisieren. Die Integration von RDMA in Ethernet ermöglichte eine breitere Verbreitung, die insbesondere in Cloud-Rechenzentren und bei Hyperscalern für enormen Aufschwung sorgte. Unternehmen wie IBM, Microsoft und Alibaba setzten früh auf RoCE, um die Vorteile von RDMA bei ihren riesigen Datenverarbeitungszentren zu nutzen. Mellanox trug maßgeblich dazu bei, dass moderne Hochgeschwindigkeitsnetzwerke mit 25, 50 und 100 Gigabit pro Sekunde die Latenzreduktion und den Durchsatz von RDMA voll ausschöpfen konnten. Das Unternehmen entwickelte erfolgreiche Produktreihen wie die ConnectX-Chips, die sowohl InfiniBand als auch RoCE unterstützen und somit die Brücke zwischen spezialisierten und allgegenwärtigen Netzwerken schlagen.

Ein weiterer Aspekt, der die Leistungsfähigkeit von RDMA und die Rolle von Mellanox unterstreicht, sind die sogenannten Smart NICs – intelligente Netzwerk-Interface-Karten, die heute komplexe Funktionen übernehmen, welche früher die CPUs belasteten. Smart NICs führen Aufgaben wie adaptive Routing-Algorithmen, Staukontrolle und Sicherheitsmechanismen autonom aus. Im Kern fungieren sie als kleine, spezialisierte Computer, die zwischen Netzwerk und Hauptprozessor geschaltet sind. Dabei steht RDMA weiterhin im Fokus, da es den direkten und effizienten Speicherzugriff ermöglicht und so Server-CPU-Ressourcen freisetzt. Dies führt zu einer weiteren Optimierung der Gesamtperformance in Rechenzentren und erlaubt eine bessere Skalierbarkeit.

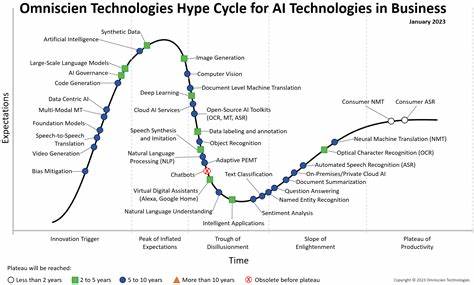

Die nächsten großen Herausforderungen und Chancen für RDMA liegen im Bereich der Künstlichen Intelligenz und des maschinellen Lernens. Der exponentiell steigende Bedarf an Rechenleistung und vor allem Netzwerkbandbreite für das Training großer neuronaler Netze macht schnelle und effiziente Interprozessor-Kommunikation unerlässlich. Mellanox entwickelte mit dem SHARP-Protokoll eine Technologie, die Daten aus verteilten Rechner-Clustern konsolidiert und so die Skalierbarkeit im HPC- und AI-Bereich fördert. Die Kombination von RDMA mit dedizierter Hardware und intelligenten Netzwerktechnologien unterstützt das Aggregieren von Daten wie aktualisierten Gewichten in Deep-Learning-Modellen, was die Trainingszeiten erheblich verkürzt. Ein Höhepunkt in der jüngsten Geschichte von RDMA war die Übernahme von Mellanox Technologies durch NVIDIA im Wert von 6,9 Milliarden US-Dollar, angekündigt 2019 und abgeschlossen im April 2020.

NVIDIA hatte RDMA bereits in seine GPU-basierten Systeme integriert – allen voran durch die GPUDirect-Technologie, die es GPUs erlaubt, effizient direkt mit Netzwerkgeräten zu kommunizieren, ohne über den CPU-Pfad gehen zu müssen. In einem gemeinsamen Ökosystem aus Hochleistungscomputern mit NVIDIA-GPUs und Mellanox-Netzwerken entstanden optimierte Systeme wie NVIDIAs DGX-Plattform, die speziell auf KI-Workloads ausgelegt ist. Die Fusion dieser Technologiefelder verdeutlicht, wie eng vernetzt heute Prozessor- und Netzwerktechnologien sind. Die Verschmelzung von Hochleistungsrechnen, Big Data und KI beschleunigt die Notwendigkeit, latenzarme und extrem schnelle Netzwerke zu schaffen. RDMA liefert gerade dafür die Basis.

Die Technologie ist inzwischen weitverbreitet und fast unsichtbar geworden, da sie in den Netzwerkstack und die Hardware so tief integriert ist, dass Endnutzer selten aktiv von RDMA hören oder wissen. Doch gerade diese Allgegenwärtigkeit zeigt, wie essentiell RDMA für die moderne IT-Landschaft geworden ist. Durch kontinuierliche Weiterentwicklungen ist RDMA nicht nur schneller und effizienter geworden, sondern auch vielseitiger und robuster. Die Unterstützung von Routing in RoCE beispielsweise hat es ermöglicht, RDMA über größere und heterogenere Netzwerke hinweg zu nutzen. Gleichzeitig werden neue Anwendungsgebiete erschlossen, die von speicherintensiven Big-Data-Analysen über datenintensive KI-Algorithmen bis hin zu hochverfügbaren Cloud-Services reichen.

Blickt man in die Zukunft, so steht fest: RDMA wird weiterhin eine Schlüsselrolle in der Netzwerk- und Computertechnologie spielen. Die Verschmelzung mit Smart NICs, die Integration in KI-Systeme und die Unterstützung durch Branchengrößen wie NVIDIA und IBM sichern RDMA einen festen Platz in der IT-Infrastruktur von morgen. Dank der Innovationen von Pionieren wie Mellanox und engagierten Forschern, die komplexe Probleme bei der Skalierung lösten, können Unternehmen heute Systeme bauen, die schnell, kosteneffizient und leistungsstark sind. RDMA ist damit ein Paradebeispiel dafür, wie technologische Vision, strategische Partnerschaft und unermüdliche Entwicklungsarbeit zusammenwirken können, um eine ganze Branche zu transformieren.