Im Zeitalter der Künstlichen Intelligenz wächst der Bedarf an effizienten, skalierbaren Lösungen zur Verarbeitung großer Datenmengen stetig. Unternehmen und Entwickler, die mit umfangreichen Textdaten arbeiten, stehen häufig vor der Herausforderung, diese zuverlässig, kosteneffizient und vor allem skalierbar zu bearbeiten. Hier setzt Anthropics Message Batches API in Verbindung mit Temporal an – eine Kombination, die genau diese Probleme adressiert und zugleich die Integration von AI-Workflows vereinfacht. Die Message Batches API von Anthropic ist ein spezialisierter Dienst, der es ermöglicht, Tausende von Claude-Anfragen asynchron und besonders günstig zu verarbeiten. Im Gegensatz zu den herkömmlichen synchronen API-Anfragen verzichtet das Batch-System auf sofortige Antworten zugunsten einer kostengünstigeren Bearbeitung innerhalb von bis zu 24 Stunden.

Diese Arbeitsweise bedeutet eine erhebliche Kostenersparnis von 50 bis 85 Prozent gegenüber Standardaufrufen. Für viele Anwendungen, die keine unmittelbare Antwort benötigen, ist dies ein entscheidender Vorteil. Darüber hinaus unterstützt die Batches API große Modelle wie Claude 3 Haiku, Opus und Sonnet, was vielfältige Einsatzmöglichkeiten eröffnet. Sie ermöglicht zudem die Einreichung unterschiedlicher Anfragearten in einer einzigen Charge, was die Flexibilität erhöht. Im Gegensatz zu Einzelanfragen profitiert man bei der Batches API nicht nur von besseren Durchsatzraten und höheren Limitierungen, sondern kann durch abgestimmtes Prompt-Caching sogar noch tiefere Kosteneinsparungen realisieren.

Die Vorteile gehen über reine Kostenreduzierung hinaus: Durch die Möglichkeit, riesige Mengen an Anfragen gebündelt zu bearbeiten, wird das Management komplexer paralleler Systeme deutlich vereinfacht. Entwickler sparen sich das Aufsetzen eigener Queuing-Systeme oder das Handling von Ratenbegrenzungen. So gestaltet sich die Verarbeitung umfangreicher Datensätze nicht nur günstiger, sondern auch unkomplizierter. Die praktische Anwendung der Message Batches API erfordert dennoch einige Anpassungen. So sollte vor dem Einreichen der Batch-Anfragen eine Validierung der Datenformate erfolgen, da eine asynchrone Fehlerbehandlung schwieriger umzusetzen ist.

Mit aussagekräftigen custom_id Werten lassen sich eingereichte Anfragen klar nachvollziehen und die Ergebnisse leichter zuordnen. Monitoring und Ergebniserfassung bilden weitere wichtige Bausteine. Einfaches Polling, etwa mittels regelmäßiger Statusabfragen, dient dazu, den Fortschritt im Auge zu behalten. Doch hierbei ergeben sich Herausforderungen: Fällt das ausführende Skript aus, geht leicht die Kontrolle über die Batch-IDs verloren, was zu Problemen bei der Nachverfolgung führt. Um diese Schwachstellen auszugleichen, ist eine zuverlässige Orchestrierung notwendig.

Genau hier kommt Temporal ins Spiel. Temporal ist eine Open-Source Plattform zur Orchestrierung verteilter Anwendungen, die sich ideal für langlebige, fehlertolerante Workflows eignet. Temporal bietet eine umfassende State-Management-Lösung sowie automatische Wiederholungen und erlaubt es, Workflows so zu gestalten, dass sie reibungslos auch bei Ausfällen oder Neustarts fortgeführt werden können. Die enge Integration von Temporal mit der Message Batches API eröffnet zahlreiche Vorteile: Entwickler müssen sich nicht mehr selbst um die dauerhafte Speicherung von Batch-IDs kümmern, auch komplexe Wiederholungs- und Polling-Logiken werden automatisch verwaltet. Temporal teilt die Workflows dabei in einzelne Aktivitäten auf, wie das Erstellen des Batches, das Überprüfen des Status und das Einholen der Ergebnisse.

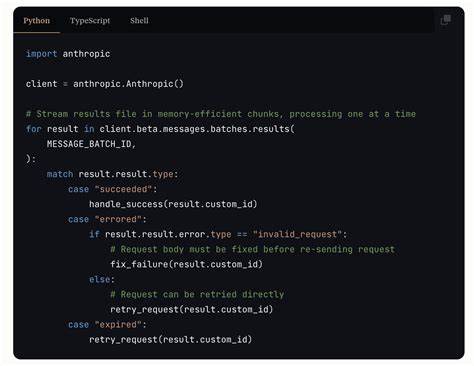

Dies führt nicht nur zu besser wartbarem Code, sondern auch zu granularen Retry-Mechanismen, die für Zuverlässigkeit sorgen. Die Skalierbarkeit ist bei Temporal ebenfalls gegeben: Durch horizontales Scaling der Worker können beliebig viele parallele Batch-Jobs verarbeitet werden, ohne dass ein eigener Queue-Mechanismus erforderlich ist. Die Nutzer profitieren zudem von einem übersichtlichen Web-Interface, das Live-Einblicke in die Abläufe erlaubt – ein nicht zu unterschätzender Vorteil für Debugging und Monitoring in produktiven Umgebungen. Die Entwicklung eines typischen Workflows beginnt oft mit der Anpassung der einzelnen Aktivitäten, die auf die konkrete Anwendung und die Bedürfnisse zugeschnitten sind. In TypeScript können etwa Funktionen erstellt werden, die Batch-Anfragen erzeugen, deren Status überprüfen und die Ergebnisse auslesen.

Im Workflow selbst erfolgt die Orchestrierung mit Polling-Mechanismen, versehen mit Pausen und optionaler exponentieller Rückoff-Strategie für effizientes Abfragen. Über Temporal erhält jede Aktivität verlässliche Timeouts und Retry-Strategien, was den Entwicklungsaufwand für Fehlertoleranz drastisch reduziert. Sobald die Einrichtung der Temporal-Worker und Workflows abgeschlossen ist, lässt sich die Batch-Verarbeitung mit einem einfachen Skript auslösen. Dieses startet die Workflow-Instanz mit den vorbereiteten Anfragen und wartet dann auf die Ergebnislieferung. Im produktiven Einsatz kann dieses Starten natürlich auch an API-Endpoints oder Events geknüpft werden, was den Integrationsspielraum deutlich erweitert.

Zu den typischen Einsatzbereichen gehören große Inhaltsanalysen, automatisierte Zusammenfassungen umfangreicher Dokumente, Feedback-Analysen, Inhaltsmoderation und vieles mehr. Gerade Aufgaben, die nicht unmittelbar auf eine Antwort angewiesen sind, eignen sich optimal als Batch-Prozesse. Für Unternehmen mit hohem Datenvolumen ergeben sich dadurch deutliche Kosteneinsparungen und eine bessere Prozessübersicht. Die Verbindung von Anthropics Message Batches API mit Temporal bietet damit eine perspektivisch zukunftssichere Grundlage für KI-gestützte Anwendungen, die über einfache Einzelanfragen hinausgehen. Durch die robuste Fehlerbehandlung und State-Verwaltung fallen typische Probleme wie verlorene Batch-IDs, Abstürze oder unübersichtliche Retry-Mechanismen weg.

Zukünftige Erweiterungen, wie etwa dynamisches Batchen, eine Web-Dashboard-Integration zur Echtzeit-Überwachung, Prompt-Caching zur weiteren Optimierung der Kosten oder Webhook-Benachrichtigungen nach abgeschlossener Verarbeitung, können diese Plattform komplettieren und noch vielseitiger machen. Auch die Integration mit Datenbanken zur langfristigen Speicherung der Ergebnisse und deren Analyse ist denkbar. Es zeigt sich, dass die Kombination von spezialisierten API-Diensten wie Anthropics Batches API mit einer orchestrierenden Plattform wie Temporal nicht nur technische Vorteile bietet, sondern auch Kosten senkt und die Entwicklung komplexer KI-Workflows deutlich vereinfacht. Besonders in Zeiten steigenden Datenaufkommens und wachsendem Bedarf nach zuverlässiger Automatisierung ergibt sich damit eine wertvolle Chance zur Prozessoptimierung. Wer auf Suche nach einer skalierbaren, ausfallsicheren und effizienten Lösung für die Stapelverarbeitung von KI-Anfragen ist, findet in diesem Ansatz genau die richtigen Bausteine.