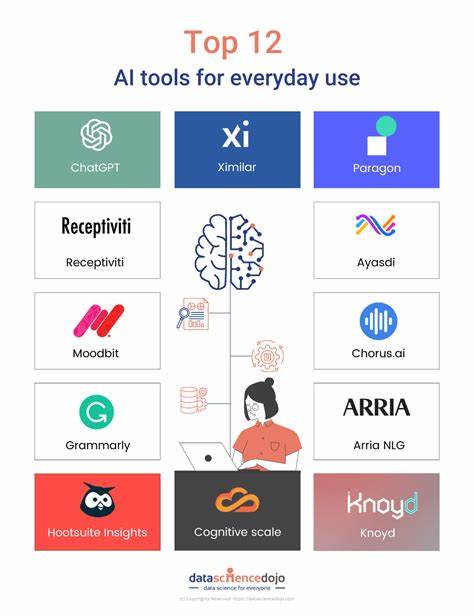

In der ständig fortschreitenden Welt der künstlichen Intelligenz veröffentlichte OpenAI kürzlich o3-pro, eine weiterentwickelte Version ihres bewährten o3-Modells. Diese neue Generation unterscheidet sich vor allem durch ihre gesteigerte Rechenkapazität und das damit verbundene verbesserte Antwortverhalten. O3-Pro stellt damit einen bedeutenden Fortschritt in der Entwicklung von Sprachmodellen dar, der Anwendern erlaubt, anspruchsvollere Aufgaben mit höherer Präzision zu bewältigen. Die Einführung von o3-pro markiert nicht nur eine technische Innovation, sondern eröffnet auch neue Möglichkeiten für Unternehmen und Entwickler, die KI-Anwendungen auf ein neues Level heben möchten. O3-pro ist ausschließlich über die neu eingeführte Responses API von OpenAI zugänglich.

Diese API nimmt gegenüber den bisherigen Schnittstellen einen entscheidenden Wandel vor und unterstützt insbesondere die längere und umfassendere Kontextintegration. Nutzer berichten aber, dass die Verarbeitung von Anforderungen hierdurch merklich langsamer ist, ein Beispiel dafür ist die Erstellung einer SVG-Grafik eines Pelikans auf einem Fahrrad, die bei einem Nutzer bis zu 124 Sekunden benötigte. Um die Effizienz zu verbessern, empfiehlt OpenAI die Benutzung des sogenanntes Hintergrundmodus, der allerdings bislang noch nicht weit verbreitet oder umfassend getestet ist. Preislich setzt o3-pro neue Maßstäbe im Vergleich zu seinem Vorgänger. Während der reguläre o3-Edition kürzlich eine signifikante Preissenkung von etwa 80 Prozent erfuhr, ist das o3-pro-Modell mit 20 US-Dollar pro Million Eingabetokens und 80 US-Dollar pro Million Ausgabetokens etwa zehnmal so teuer.

Diese Kosten sind jedoch ein Hinweis auf die erhöhte Leistungsfähigkeit und das dadurch entstehende Mehr an Wert sowie Qualität der erbrachten Resultate. Von besonderem Interesse sind die ersten Erfahrungsberichte mit o3-pro, vor allem die von Ben Hylak, der als einer der ersten Nutzer Einblicke zu den Stärken wie auch den Herausforderungen des Modells lieferte. Seinen Beobachtungen zufolge ist das Modell „viel intelligenter“ als sein Vorgänger, doch um die wahre Kraft von o3-pro zum Vorschein zu bringen, ist deutlich mehr Kontext erforderlich. Die Verarbeitung und Bereitstellung umfangreicher Kontextinformationen stellt für viele Anwender eine Hürde dar, da traditionelle Interaktionen mit Sprachmodellen häufig auf kürzere oder weniger komplexe Eingaben beschränkt sind. Ein besonders aussagekräftiges Beispiel liefert die Verwendung von o3-pro beim Start-up Raindrop.

Die Gründer fanden heraus, dass sie durch die sorgfältige Zusammenstellung ihrer gesamten Unternehmenshistorie, sämtlicher Planungstreffen, Ziele und sogar Sprachaufzeichnungen eine konkrete und präzise Planung vom Modell generiert bekamen. Im Gegensatz zu allgemein gehaltenen Plänen bot o3-pro eine detaillierte, plausible Zukunftsstrategie mit klarer Priorisierung von Maßnahmen, messbaren Zielvorgaben und einem strukturierten Fahrplan. Selbst kritische Elemente wie Empfehlungen zum Streichen weniger wichtiger Aktivitäten wurden nicht ausgelassen. Diese Qualität der Analyse und Planung setzt neue Maßstäbe und führt dazu, dass das Unternehmen seine strategische Ausrichtung grundlegend überdenkt. Die hier beschriebenen Fähigkeiten verdeutlichen, dass o3-pro vor allem dann seine Stärken ausspielt, wenn es um umfangreiche, komplexe und tiefgehende Informationsmengen geht.

Gleichzeitig wächst dadurch der Bedarf an geeignetem Management der Kontextinformationen. Für Entwickler und Unternehmen bedeutet dies, dass eine sorgfältige Vorbereitung der Eingaben und gegebenenfalls die Integration von ergänzenden Tools und Schnittstellen notwendig sind, um das volle Potenzial des Modells auszuschöpfen. Aktuell bietet OpenAI noch keine vollständige Tool-Unterstützung für o3-pro in seinem llm-openai-plugin an. Dies schränkt die direkte Anwendung etwas ein, eröffnet aber gleichzeitig Raum für zukünftige Erweiterungen. Die Community und Entwickler arbeiten aktiv an Verbesserungen, sodass sich der Umgang mit o3-pro und dessen Integration in bestehende Systeme laufend weiterentwickeln wird.

Neben den konkreten Anwendungsfällen in Unternehmen, die von der verbesserten Planungs- und Analysefähigkeit profitieren, könnten auch andere Bereiche von o3-pro deutlich profitieren. Kreative Anwendungen, wie das Generieren von komplexen SVG-Bildern oder die Erstellung anspruchsvoller Texte, lassen sich mit dem neuen Modell wesentlich präziser gestalten. Allerdings ist die Geschwindigkeit der Verarbeitung nach wie vor eine Herausforderung, die in der Praxis berücksichtigt werden muss. O3-pro repräsentiert den aktuellen Stand der Technik bei OpenAI in Sachen Sprachmodell-Entwicklung. Es ist ein Modell, das vor allem für professionelle Nutzer und anspruchsvolle Szenarien konzipiert ist, bei denen die Qualität und Tiefe der Antwort wichtiger sind als die reine Verarbeitungszeit oder die Kosten.

Für die Zukunft ist davon auszugehen, dass OpenAI mit o3-pro und ähnlichen Modellen die Grenzen der KI-gestützten Textgenerierung weiter verschieben wird. Für Nutzer und Entwickler lohnt sich ein genauer Blick auf die Funktionsweise und die Möglichkeiten von o3-pro, um die eigenen Anwendungen und Workflows entsprechend anzupassen. Wer bereit ist, in Qualität und Kontextintensität zu investieren, erhält mit o3-pro ein Werkzeug, das tiefere Einblicke, konkretisierte Handlungsempfehlungen und innovative kreative Ansätze ermöglicht. So wird o3-pro zu einem Ankerpunkt in der Weiterentwicklung von KI-Technologien, der das Potenzial hat, die Art und Weise, wie wir mit künstlicher Intelligenz arbeiten, grundlegend zu verändern. Zusammenfassend lässt sich sagen, dass o3-pro von OpenAI nicht nur ein weiterer Schritt in der Evolution von Sprachmodellen ist, sondern ein Quantensprung in Bezug auf Intelligenz, Kontextverständnis und nützliche Anwendungsmöglichkeiten.

Es fordert Anwender dazu heraus, mehr Kontext einzuspeisen und komplexer zu denken, belohnt dafür aber mit Ergebnissen, die bisherige Modelle deutlich übertreffen. Dies macht o3-pro zu einem spannenden und zukunftweisenden Werkzeug für alle, die das volle Potenzial der künstlichen Intelligenz ausschöpfen möchten.