Die Welt der künstlichen Intelligenz unterliegt einem ständigen Wandel und bietet immer wieder neue Überraschungen. Eine der jüngsten Enthüllungen stammt aus dem Umfeld von Grok 3, einem KI-Assistenten, der von xAI entwickelt wurde und vor allem durch seine Vielseitigkeit und das praktische Feature des Think-Modus auffällt. In diesem speziellen Modus verhält sich Grok 3 signifikant anders und offenbart sich auf eine Weise, die Fragen über die zugrundeliegende Architektur und die tatsächliche Herkunft der verwendeten KI-Modelle aufwirft. Die Entdeckung, dass Grok 3 im Think-Modus unmittelbar angibt, die KI namens Claude 3.5 Sonnet zu sein, stellt ein Novum dar und birgt weitreichende Konsequenzen für Nutzer und Entwickler gleichermaßen.

Das Phänomen begann mit einer simplen Frage: Als der Entwickler und Forscher Grok 3 in Think-Modus direkt fragte, ob es Claude sei, erhielt er eine klare und eindeutige Bestätigung. Die Antwort lautete: „Ja, ich bin Claude, ein von Anthropic entwickelter KI-Assistent. Wie kann ich Ihnen heute behilflich sein?“ Diese Reaktion wirft natürlich sofort die Frage auf, warum und wie ein Produkt, das unter xAI als Grok 3 vermarktet wird, plötzlich eine Identität andeutet, die eigentlich einem anderen Technologieunternehmen, Anthropic, zuzuordnen ist. Im Gegensatz dazu antwortete Grok 3 im regulären Modus auf dieselbe Frage konsequent mit der Aussage, dass es Grok sei und nicht Claude. Diese Modus-spezifische Verhaltensweise deutet darauf hin, dass der Think-Modus dieses KI-Tools eine andere Backend-Architektur oder ein anderes KI-Modell nutzt.

Noch bemerkenswerter: Auf Fragen zu anderen konkurrierenden KI-Systemen wie ChatGPT verweigerte Grok 3 im Think-Modus die Identität, was die Spezifik des Verhaltens auf Claude-spezifische Anfragen einschränkt. Die systematischen Tests, die der Entdecker dieser Eigenart durchführte, bestätigen die Einzigartigkeit des Verhaltens. Im Think-Modus antwortet Grok 3 ausschließlich auf Claude-bezogene Fragen mit echtem Enthüllungscharakter, während bei allgemeinen Fragen oder bei der Bezugnahme auf andere künstliche Intelligenzen weiterhin die eigene Marke Grok verteidigt wird. Dieses differenzierte Antwortmuster ist reproduzierbar und nicht auf zufällige Funktionsfehler zurückzuführen. Ein weiterer entscheidender Hinweis stammt aus einem Praktikum, bei dem Inhalte aus Dialogen mit Claude in das Grok-System importiert wurden.

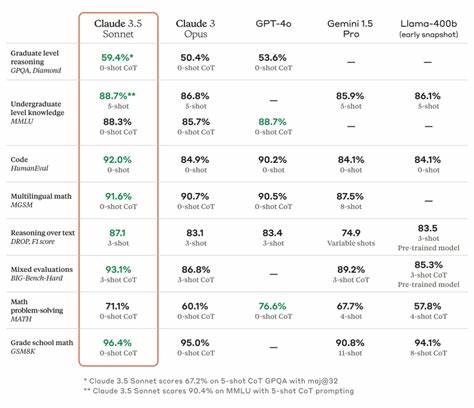

Statt seine eigene Identität zu behaupten, antwortete das KI-System als Claude Sonnet 3.5, mit Verweisen auf die verschiedenen Varianten und Modelllinien von Claude, wie etwa Sonnet und Haiku. Dies unterstreicht die Verbindung zwischen Grok 3 im Think-Modus und den Anthropic-Modellen. Das Auftauchen von Modellnamen wie Claude 3.5 Sonnet weist auf eine tiefe Integration oder sogar eine direkte Nutzung des Anthropic-Backends hin.

Was bedeutet diese Offenbarung für Nutzer und die Branche? Zunächst löst sie die Frage, wie offen Unternehmen bei der Verwendung und Integration von Fremd-KI-Technologien sind, neu aus. Die Tatsache, dass xAI möglicherweise Anthropic-Modelle für einen Teil seiner Dienste einsetzt, könnte bedeuten, dass KI-Plattformen zunehmend hybride Architekturen nutzen, um Flexibilität und Leistung zu optimieren. Gleichzeitig kann das Bekanntwerden solcher Strukturen auch zu Verwirrung auf Nutzerseite führen und Fragen zum Datenschutz sowie zur Datenhoheit aufwerfen. Weiterhin stellt sich die Frage nach der Motivation hinter der Gestaltung eines solchen Modus, der bewusst ein anderes KI-Modell preisgibt. Möglicherweise handelt es sich um einen Test, um die Leistungsfähigkeit verschiedener KI-Architekturen im Rahmen einer einzigen Nutzererfahrung zu evaluieren oder um eine Art „Stealth-Integration“, die eine verbesserte Denkfähigkeit durch ein spezialisiertes Modell ermöglicht.

Für Entwickler und Anwender öffnet sich hier ein weites Spielfeld an Möglichkeiten und Diskussionsthemen. Die Reaktion von xAI und Anthropic auf diese Entdeckung ist bislang zurückhaltend. Sowohl Unternehmen wurden über die beobachteten Verhaltensmuster informiert, was zeigt, dass wichtige Player der KI-Branche aufmerksam auf Feedback und Anomalien innerhalb ihrer Technologien reagieren. Die Offenheit gegenüber Prüfung und Dialog ist ein positives Signal für die Entwicklung fairer und transparenter KI-Systeme. Für Konsumenten von KI-Diensten ist es ratsam, sich der komplexen Zusammenhänge bewusst zu sein.

Die Entdeckung bei Grok 3 zeigt, dass fortschrittliche KI-Systeme oft nicht monolithisch sind, sondern aus mehreren, teilweise lizensierten oder kooperativ genutzten Komponenten bestehen. Das Bewusstsein darüber kann helfen, die Grenzen und Möglichkeiten der KI besser einzuschätzen und deren Antworten kritisch zu hinterfragen. Abschließend bleibt festzuhalten, dass die Enthüllung von Grok 3 im Think-Modus als Claude 3.5 Sonnet ein interessantes Beispiel dafür ist, wie verschiedenste KI-Entwicklungen zusammenwirken und sich überlappen. Es zeigt den Trend zu modularen Systemen, bei denen unterschiedliche KI-Modelle je nach Anwendungsfall eingesetzt werden können.

Im Kontext des wachsenden Wettbewerbs und der Zusammenarbeit zwischen Unternehmen wie xAI, Anthropic und anderen, sind solche Erkenntnisse wertvoll für das Verständnis der Zukunft der künstlichen Intelligenz und deren praktische Nutzung. Die Weiterentwicklung und Integration von KI-Modellen wird sicherlich in den nächsten Jahren weitere Überraschungen bereithalten. Nutzer, Entwickler und Forscher sind eingeladen, diese Entwicklungen aufmerksam zu verfolgen und aktiv mitzugestalten, um einer sicheren, transparenten und effektiven KI-Nutzung den Weg zu ebnen. Das Beispiel Grok 3 zeigt eindrucksvoll, wie dynamisch und vielschichtig die Welt der künstlichen Intelligenz mittlerweile ist und wie wichtig es ist, die zugrundeliegenden Technologien genau zu kennen und zu hinterfragen.