Im Bereich des maschinellen Lernens hat sich Deep Reinforcement Learning als ein besonders vielversprechender Ansatz etabliert, um Agenten zu entwickeln, die komplexe Aufgaben durch Interaktion mit ihrer Umgebung autonom erlernen können. Trotz der enormen Fortschritte, die in den letzten Jahren erzielt wurden, stellen viele existierende Frameworks für Deep Reinforcement Learning oft eine zu große Komplexität für Neueinsteiger dar oder sind für schnelle Prototypenentwicklung ungeeignet. Hier kommt ToyRL ins Spiel, eine leichte und übersichtliche Python-Bibliothek, die klassische Deep Reinforcement Learning Algorithmen implementiert und sich perfekt für Bildungszwecke, Experimente und den schnellen Einstieg in die Welt des Verstärkenden Lernens eignet. ToyRL ermöglicht es Entwicklern, ohne großen Overhead fundamentale Techniken wie REINFORCE, SARSA, DQN, Double DQN, A2C und PPO direkt anzuwenden und zu verstehen. Der Name ToyRL spiegelt bereits die Philosophie hinter dem Projekt wider: Eine minimalistische und doch elegante Plattform, die das komplexe Thema des Verstärkenden Lernens in handhabbare, verständliche Bausteine zerlegt.

Während viele große Bibliotheken mit umfangreichen Abhängigkeiten, modularen Erweiterungen und hoher Komplexität aufwarten, fokussiert sich ToyRL auf das Wesentliche. Dies macht die Bibliothek besonders attraktiv für diejenigen, die sich auf die eigentlichen Algorithmen konzentrieren wollen, ohne von zu vielen Rahmenbedingungen abgelenkt zu werden. Jeder der integrierten Algorithmen ist mit einer klaren Struktur und Dokumentation versehen, was das Lernen sowie das Anpassen eigener Ideen stark vereinfacht. Das Installieren von ToyRL ist denkbar einfach und erfolgt direkt über den Python Package Index (PyPI) mittels eines einfachen pip-Befehls. Dadurch wird die Hürde für den Einstieg sehr niedrig gehalten.

Dank der geringen Abhängigkeiten lässt sich ToyRL problemlos in verschiedenste Projekte integrieren oder als eigenständiges Tool für Lern- und Forschungszwecke einsetzen. Die Bibliothek ist unter der Apache-2.0 Lizenz veröffentlicht, was die Nutzung und Anpassung auch in professionellen Umgebungen ohne größere Restriktionen möglich macht. Die breite Palette der in ToyRL bereitgestellten Algorithmen spiegelt den Fokus auf klassische Verfahren wider, die trotz ihres Alters nach wie vor Grundpfeiler der Forschung und Anwendung im Deep Reinforcement Learning sind. REINFORCE, ein richtungsweisender Algorithmus aus dem Policy Gradient Bereich, ermöglicht es Agenten, ihre Entscheidungsstrategien anhand von Belohnungen direkt zu verbessern.

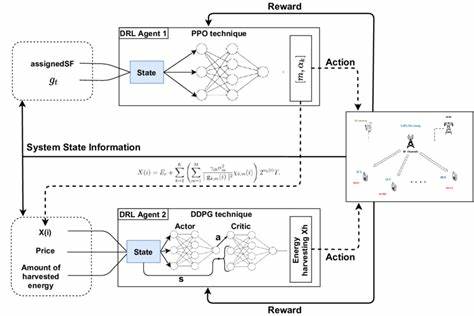

SARSA ist ein wichtiger Vertreter der On-Policy-Methoden, der sich hervorragend für Szenarien eignet, in denen das Erlernen eines möglichst sicheren und stabilen Verhaltens erwünscht ist. DQN und Double DQN gehören zu den Epochenschmieden des Deep Reinforcement Learning und nutzen neuronale Netze, um optimale Aktionen in diskreten Aktionsräumen zu erlernen. Die Integration von A2C und PPO erweitert die Flexibilität und Leistungsfähigkeit von ToyRL durch moderne, sample-effiziente Algorithmen, die in vielen aktuellen Anwendungen überzeugen. Die Inspirationsquellen für die Implementierungen innerhalb von ToyRL sind hochkarätig. Die Entwickler griffen unter anderem auf die Erkenntnisse und Code-Grundlagen aus der SLM-Lab Arbeitsgruppe zurück, die sich auf das Verstehen und die Umsetzung von Konzepten aus dem Buch „Foundations of Deep Reinforcement Learning“ stützt.

Darüber hinaus wurde für die PPO-Implementierung auf cleane und bewährte Quellen wie CleanRL zurückgegriffen, welche für ihre Effizienz, Übersichtlichkeit und Community-Support bekannt sind. Diese Kombination führt zu einer Bibliothek, die sowohl pädagogischen Ansprüchen genügt als auch robust genug für experimentelle Einsätze ist. ToyRL besticht durch eine modulare Struktur, die in einem übersichtlichen Repository auf GitHub gepflegt wird. Die Bibliothek wird kontinuierlich weiterentwickelt und verfügt über Tests, Dokumentationen sowie Beispielskripte, die den Anwender durch verschiedene Reinforcement Learning Aufgaben führen. Die Dokumentation ist mittels eines MkDocs-Systems aufgebaut und online frei verfügbar, was das Onboarding erheblich erleichtert.

Anwender finden dort Schritt-für-Schritt Anleitungen, Erklärungen zu den Algorithmen sowie Hinweise zur Einbindung der Bibliothek in eigene Projekte. Ein großer Vorteil von ToyRL gegenüber schwergewichtigeren Frameworks ist die Geschwindigkeit, mit der neue Modelle entwickelt und getestet werden können. Ohne den Ballast unnötiger Zusatzfunktionen ermöglicht ToyRL eine schnelle Implementierung experimenteller Ansätze mit sofortigem Feedback. Dies macht die Bibliothek besonders attraktiv für akademische Zwecke, Hobbyentwickler und Firmen, die prototypische Lösungen im Bereich der künstlichen Intelligenz realisieren möchten. Der Einsatz von ToyRL ist nicht nur auf Lernumgebungen beschränkt.

Auch in der Forschung kann die Bibliothek helfen, neue Ideen zu entwickeln oder etablierte Algorithmen unter Modellierungsbedingungen zu untersuchen. Da die Bibliothek in Python geschrieben ist, bietet sie großen Spielraum für Anpassungen und Erweiterungen mit anderen Deep Learning Bibliotheken wie PyTorch oder TensorFlow. Der Fokus auf klassische Algorithmen erlaubt es zudem, die Funktionsweise moderner Verfahren besser zu verstehen und diese gegebenenfalls mit ToyRL als Grundlage weiterzuentwickeln. ToyRL hat inzwischen eine moderate Community aufgebaut, welche die Entwicklung unterstützt und Feedback gibt. Das Projekt verfügt über mehrere Releases, in denen Fehler behoben und Funktionen ergänzt wurden.

Die stete Pflege des Codes zertifiziert die Bibliothek als zuverlässiges Werkzeug, das den wachsenden Anforderungen der Nutzer gerecht wird. Zudem motivieren die niedrigen Einstiegshürden mehr Entwickler und Forschende, sich mit den Grundlagen des Deep Reinforcement Learnings auseinanderzusetzen. Zusammenfassend kann gesagt werden, dass ToyRL einen wertvollen Beitrag im Ökosystem der künstlichen Intelligenz und insbesondere des Verstärkenden Lernens leistet. Es bietet einen niederschwelligen Zugang zu klassischen, aber nach wie vor relevanten Algorithmen, die Grundlage für viele moderne Entwicklungen sind. Für Anfänger, die in die Welt des Deep Reinforcement Learning eintauchen möchten, ist ToyRL ein ideales Tool, das mit klarer Struktur, einfacher Handhabung und einer gut dokumentierten Codebasis überzeugt.

Gleichzeitig stellt es für erfahrene Entwickler eine schlanke Plattform dar, um schnell Prototypen zu erstellen und fundierte Experimente durchzuführen. In der schnelllebigen Landschaft der künstlichen Intelligenz ist es wichtig, Werkzeuge zu haben, die nicht nur mit technischen Möglichkeiten glänzen, sondern zugleich Bildung und Verständnis fördern. ToyRL erfüllt diese Rolle mit Bravour, indem es die Komplexität klassischer Reinforcement Learning Algorithmen auf verständliche und zugängliche Weise präsentiert. Die Kombination aus schlanker Architektur, solider Implementierung und leichter Zugänglichkeit macht ToyRL zu einer essentiellen Ressource für alle, die an den Möglichkeiten und Herausforderungen des Deep Reinforcement Learning interessiert sind.

![Multi-Agent Systems in OpenAI's Agents SDK [video]](/images/1AB19FE7-BD6B-4666-A8E6-6B3007866A9D)