Adaptive Systeme spielen eine zentrale Rolle in vielerlei Bereichen von Technik, Wirtschaft und Naturwissenschaften. Sie zeichnen sich dadurch aus, dass sie selbstlernend auf Veränderungen in ihrem Umfeld reagieren können, um eine optimale Funktionsweise aufrechtzuerhalten. Trotz ihrer ausgefeilten Mechanismen und intelligenter Systemarchitekturen sind sie nicht immun gegen Fehlfunktionen. Das Versagen adaptiver Systeme folgt dabei bestimmten, oft wiederkehrenden Mustern. Das Verständnis dieser Muster ist entscheidend, um Schwachstellen zu identifizieren und effektive Gegenmaßnahmen zu entwickeln.

Ein wesentliches Versagensmuster bei adaptiven Systemen ist das sogenannte Overfitting. Dabei passt sich das System zu stark an spezifische Bedingungen oder Daten an, die möglicherweise nur temporär oder zufällig auftreten. Statt generalisierte und belastbare Lösungen zu erzeugen, werden zu stark detailgetreue Modelle entwickelt, die in anderen Situationen versagen. Dieses Verhalten mindert die Fähigkeit des Systems, effektiv auf neue oder unerwartete Situationen zu reagieren. Eng verbunden damit ist das Problem der falschen Rückkopplung.

Adaptive Systeme bauen häufig auf Feedback-Mechanismen auf, durch die sie ihre Leistung bewerten und anpassen. Wenn jedoch das Feedback fehlerhaft, unzureichend oder verzerrt ist, führt dies zu falschen Anpassungen. Diese können sich selbst verstärken und in Ermangelung validierender Kontrollen die Systemleistung langfristig verschlechtern oder gar zerstören. Besonders kritisch ist dies, wenn externe Einflüsse das Feedbacksystem manipulieren oder verzögern. Ein weiteres häufiges Problem ist die Überforderung durch Komplexität.

Adaptive Systeme sind in der Regel für eine bestimmte Komplexitätsstufe entworfen. Überschreitet die Umweltkomplexität oder die Anzahl der Variablen diesen Bereich, stoßen sie an Grenzen ihrer Verarbeitungskapazität. Dies kann in Form von instabilen Reaktionen, Inkonsistenzen oder gar vollständigen Systemausfällen resultieren. Die Herausforderung besteht darin, die Balance zwischen ausreichender Flexibilität und überschaubarer Komplexität zu finden. Zusätzlich besteht die Gefahr von Pfadabhängigkeit oder Lock-in-Effekten, bei denen sich das adaptive System auf bestimmte Strategien oder Konfigurationen festlegt.

Dies geschieht häufig aufgrund vergangener erfolgreicher Anpassungen, die jedoch in veränderten Umweltbedingungen suboptimal sind. Solche Systeme verlieren ihre Fähigkeit zur Evolution und Anpassung, da sie in lokal optimalen, aber global unbrauchbaren Zuständen gefangen sind. Diese Starrheit kann im Einzelfall katastrophale Folgen haben, etwa in sicherheitskritischen Anwendungen oder dynamischen Märkten. Des Weiteren müssen adaptive Systeme die Balance zwischen Exploration und Exploitation meistern. Exploration beschreibt das Ausprobieren neuer Lösungsmöglichkeiten, um möglicherweise bessere Anpassungen zu finden, während Exploitation bedeutet, bewährte Anpassungen weiterhin zu nutzen.

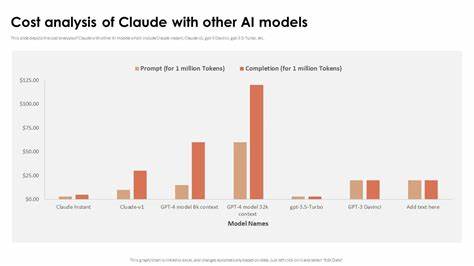

Ein Versagen tritt auf, wenn das System zu stark auf bereits bekannte Lösungen setzt und neue Optionen vernachlässigt. Umgekehrt kann exzessive Erkundung wertvolle Ressourcen erschöpfen und zu ineffizientem Verhalten führen. Die optimale Steuerung dieses Gleichgewichts bleibt eine Kernherausforderung bei der Gestaltung adaptiver Systeme. Fehlende Transparenz und Nachvollziehbarkeit erschweren zudem das Erkennen von Fehlerquellen in adaptiven Systemen. Viele dieser Systeme, insbesondere jene mit KI-Komponenten, arbeiten als blackbox, was bedeutet, dass ihre inneren Entscheidungsprozesse für Menschen schwer verständlich sind.

Dies erschwert nicht nur die Diagnose von Problemen, sondern auch das Vertrauen in das System selbst. Eine verstärkte Entwicklung in Richtung erklärbarer und interpretierbarer Modelle ist daher von großer Bedeutung, um Ausfälle frühzeitig zu erkennen und zu vermeiden. Nicht zuletzt können externe Störungen, seien sie zufällig oder absichtlich herbeigeführt, das Versagen adaptiver Systeme bewirken. Cyberangriffe, Umweltveränderungen oder plötzliche Systembruchstellen stellen Stresstests dar, denen adaptive Systeme standhalten müssen. Die Robustheit gegenüber solchen Einflüssen hängt von der Fähigkeit ab, Fehler zu isolieren und schnell zu korrigieren, ohne das Gesamtsystem zu gefährden.

Zusammenfassend lässt sich sagen, dass adaptive Systeme trotz ihrer hohen Anpassungsfähigkeit vulnerabel gegenüber klar identifizierbaren Mustern des Versagens sind. Overfitting, fehlerhafte Rückkopplungen, Überforderung durch Komplexität, Pfadabhängigkeit, unausgewogenes Explorationsverhalten, mangelnde Transparenz und externe Störungen gehören zu den häufigsten Ursachen. Ein tiefgreifendes Verständnis dieser Mechanismen ermöglicht es Entwicklern, Ingenieuren und Entscheidern, Resilienzstrategien zu entwickeln und die Systeme zielgerichtet zu optimieren. Die Zukunft wird zweifelsohne eine stärkere Integration adaptiver Systeme in immer sensiblere Bereiche bringen. Deshalb ist es von essenzieller Bedeutung, aus den Mustern des Scheiterns zu lernen und sowohl theoretische als auch praktische Lösungsansätze zu erforschen.

Dabei spielt interdisziplinäre Zusammenarbeit eine entscheidende Rolle, indem Erkenntnisse aus Technik, Psychologie, Biologie und Management zusammengeführt werden, um ganzheitliche und nachhaltige adaptive Systeme zu gestalten, die den Herausforderungen von morgen gewachsen sind.